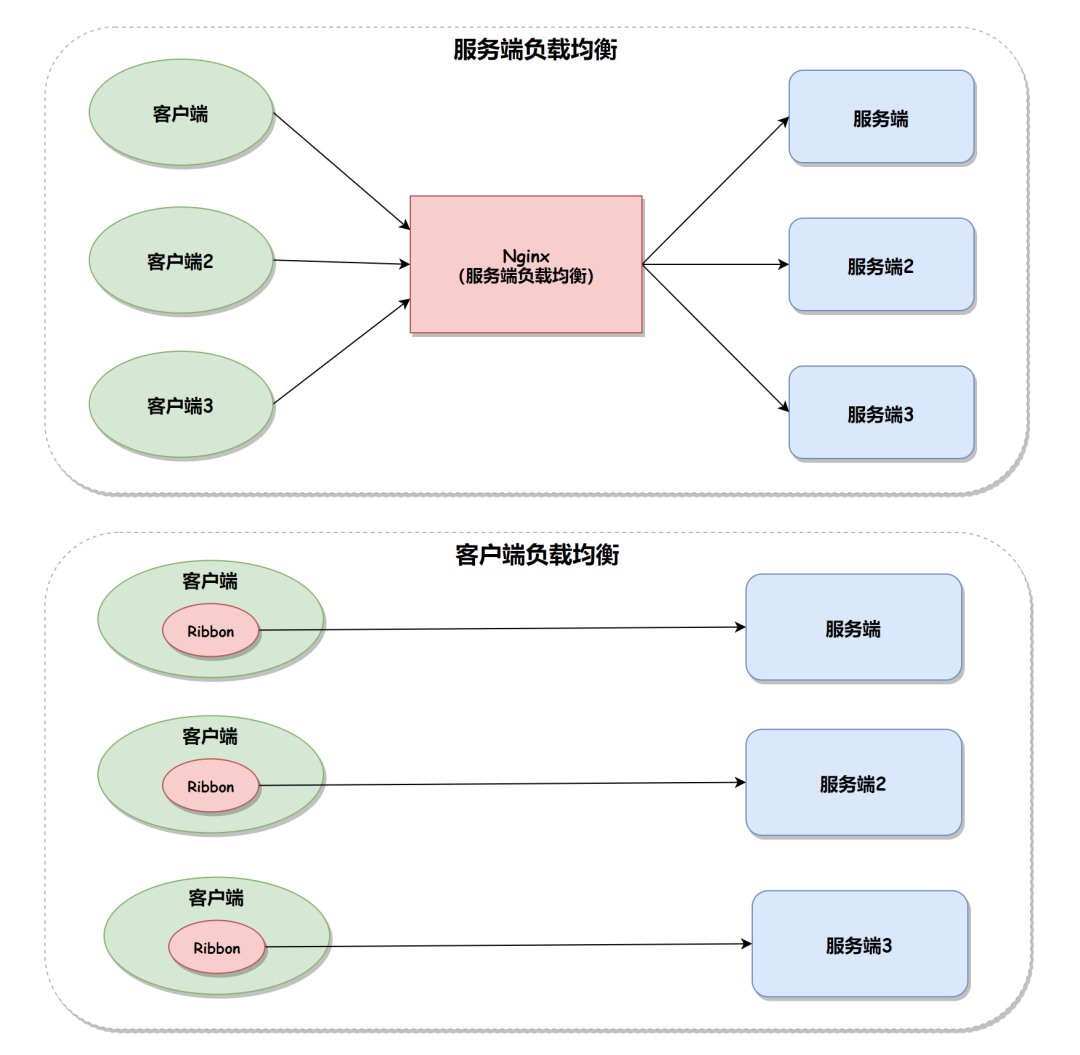

負載均衡集群是 load balance 集群的簡寫,翻譯成中文就是負載均衡集群。常用的負載均衡開源軟件有nginx、lvs、haproxy,商業(yè)的硬件負載均衡設(shè)備F5、Netscale。這里主要是學(xué)習(xí) LVS 并對其進行了詳細的總結(jié)記錄。

LB集群的架構(gòu)和原理很簡單,就是當(dāng)用戶的請求過來時,會直接分發(fā)到Director Server上,然后它把用戶的請求根據(jù)設(shè)置好的調(diào)度算法,智能均衡地分發(fā)到后端真正服務(wù)器(real server)上。為了避免不同機器上用戶請求得到的數(shù)據(jù)不一樣,需要用到了共享存儲,這樣保證所有用戶請求的數(shù)據(jù)是一樣的。

LVS是 Linux Virtual Server 的簡稱,也就是Linux虛擬服務(wù)器。這是一個由章文嵩博士發(fā)起的一個開源項目,它的官方網(wǎng)是??現(xiàn)在 LVS 已經(jīng)是 Linux 內(nèi)核標準的一部分。使用 LVS 可以達到的技術(shù)目標是:通過 LVS 達到的負載均衡技術(shù)和 Linux 操作系統(tǒng)實現(xiàn)一個高性能高可用的 Linux 服務(wù)器集群,它具有良好的可靠性、可擴展性和可操作性。從而以低廉的成本實現(xiàn)最優(yōu)的性能。LVS 是一個實現(xiàn)負載均衡集群的開源軟件項目,LVS架構(gòu)從邏輯上可分為調(diào)度層、Server集群層和共享存儲。

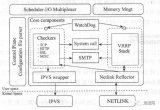

1. 當(dāng)用戶向負載均衡調(diào)度器(Director Server)發(fā)起請求,調(diào)度器將請求發(fā)往至內(nèi)核空間

2.?PREROUTING鏈首先會接收到用戶請求,判斷目標IP確定是本機IP,將數(shù)據(jù)包發(fā)往INPUT鏈

3.?IPVS是工作在INPUT鏈上的,當(dāng)用戶請求到達INPUT時,IPVS會將用戶請求和自己已定義好的集群服務(wù)進行比對,如果用戶請求的就是定義的集群服務(wù),那么此時IPVS會強行修改數(shù)據(jù)包里的目標IP地址及端口,并將新的數(shù)據(jù)包發(fā)往POSTROUTING鏈

4.?POSTROUTING鏈接收數(shù)據(jù)包后發(fā)現(xiàn)目標IP地址剛好是自己的后端服務(wù)器,那么此時通過選路,將數(shù)據(jù)包最終發(fā)送給后端的服務(wù)器

LVS 由2部分程序組成,包括 ipvs 和 ipvsadm。

1.ipvs(ip virtual server):一段代碼工作在內(nèi)核空間,叫ipvs,是真正生效實現(xiàn)調(diào)度的代碼。

2. ipvsadm:另外一段是工作在用戶空間,叫ipvsadm,負責(zé)為ipvs內(nèi)核框架編寫規(guī)則,定義誰是集群服務(wù),而誰是后端真實的服務(wù)器(Real Server)

四、LVS相關(guān)術(shù)語

1. DS:Director Server。指的是前端負載均衡器節(jié)點。

2. RS:Real Server。后端真實的工作服務(wù)器。

3. VIP:向外部直接面向用戶請求,作為用戶請求的目標的IP地址。

4. DIP:Director Server IP,主要用于和內(nèi)部主機通訊的IP地址。

5. RIP:Real Server IP,后端服務(wù)器的IP地址。

6. CIP:Client IP,訪問客戶端的IP地址。

下邊是三種工作模式的原理和特點總結(jié)。

五、LVS/NAT原理和特點

1. 重點理解NAT方式的實現(xiàn)原理和數(shù)據(jù)包的改變。

(a). 當(dāng)用戶請求到達Director Server,此時請求的數(shù)據(jù)報文會先到內(nèi)核空間的PREROUTING鏈。 此時報文的源IP為CIP,目標IP為VIP

(b). PREROUTING檢查發(fā)現(xiàn)數(shù)據(jù)包的目標IP是本機,將數(shù)據(jù)包送至INPUT鏈

(c). IPVS比對數(shù)據(jù)包請求的服務(wù)是否為集群服務(wù),若是,修改數(shù)據(jù)包的目標IP地址為后端服務(wù)器IP,然后將數(shù)據(jù)包發(fā)至POSTROUTING鏈。 此時報文的源IP為CIP,目標IP為RIP

(d). POSTROUTING鏈通過選路,將數(shù)據(jù)包發(fā)送給Real Server

(e). Real Server比對發(fā)現(xiàn)目標為自己的IP,開始構(gòu)建響應(yīng)報文發(fā)回給Director Server。 此時報文的源IP為RIP,目標IP為CIP

(f). Director Server在響應(yīng)客戶端前,此時會將源IP地址修改為自己的VIP地址,然后響應(yīng)給客戶端。 此時報文的源IP為VIP,目標IP為CIP

2. LVS-NAT模型的特性

RS應(yīng)該使用私有地址,RS的網(wǎng)關(guān)必須指向DIP

DIP和RIP必須在同一個網(wǎng)段內(nèi)

請求和響應(yīng)報文都需要經(jīng)過Director Server,高負載場景中,Director Server易成為性能瓶頸

支持端口映射

RS可以使用任意操作系統(tǒng)

缺陷:對Director Server壓力會比較大,請求和響應(yīng)都需經(jīng)過director server

六、LVS/DR原理和特點1.重將請求報文的目標MAC地址設(shè)定為挑選出的RS的MAC地址

(a)?當(dāng)用戶請求到達Director Server,此時請求的數(shù)據(jù)報文會先到內(nèi)核空間的PREROUTING鏈。 此時報文的源IP為CIP,目標IP為VIP

(b)?PREROUTING檢查發(fā)現(xiàn)數(shù)據(jù)包的目標IP是本機,將數(shù)據(jù)包送至INPUT鏈

(c)?IPVS比對數(shù)據(jù)包請求的服務(wù)是否為集群服務(wù),若是,將請求報文中的源MAC地址修改為DIP的MAC地址,將目標MAC地址修改RIP的MAC地址,然后將數(shù)據(jù)包發(fā)至POSTROUTING鏈。 此時的源IP和目的IP均未修改,僅修改了源MAC地址為DIP的MAC地址,目標MAC地址為RIP的MAC地址

(d)?由于DS和RS在同一個網(wǎng)絡(luò)中,所以是通過二層來傳輸。POSTROUTING鏈檢查目標MAC地址為RIP的MAC地址,那么此時數(shù)據(jù)包將會發(fā)至Real Server。

(e)?RS發(fā)現(xiàn)請求報文的MAC地址是自己的MAC地址,就接收此報文。處理完成之后,將響應(yīng)報文通過lo接口傳送給eth0網(wǎng)卡然后向外發(fā)出。 此時的源IP地址為VIP,目標IP為CIP

(f)?響應(yīng)報文最終送達至客戶端

2. LVS-DR模型的特性

特點1:保證前端路由將目標地址為VIP報文統(tǒng)統(tǒng)發(fā)給Director Server,而不是RS

RS可以使用私有地址;也可以是公網(wǎng)地址,如果使用公網(wǎng)地址,此時可以通過互聯(lián)網(wǎng)對RIP進行直接訪問

RS跟Director Server必須在同一個物理網(wǎng)絡(luò)中

所有的請求報文經(jīng)由Director Server,但響應(yīng)報文必須不能進過Director Server

不支持地址轉(zhuǎn)換,也不支持端口映射

RS可以是大多數(shù)常見的操作系統(tǒng)

RS的網(wǎng)關(guān)絕不允許指向DIP(因為我們不允許他經(jīng)過director)

RS上的lo接口配置VIP的IP地址

缺陷:RS和DS必須在同一機房中

3. 特點1的解決方案:

在前端路由器做靜態(tài)地址路由綁定,將對于VIP的地址僅路由到Director Server

存在問題:用戶未必有路由操作權(quán)限,因為有可能是運營商提供的,所以這個方法未必實用

arptables:在arp的層次上實現(xiàn)在ARP解析時做防火墻規(guī)則,過濾RS響應(yīng)ARP請求。這是由iptables提供的

修改RS上內(nèi)核參數(shù)(arp_ignore和arp_announce)將RS上的VIP配置在lo接口的別名上,并限制其不能響應(yīng)對VIP地址解析請求。

七、LVS/Tun原理和特點在原有的IP報文外再次封裝多一層IP首部,內(nèi)部IP首部(源地址為CIP,目標IIP為VIP),外層IP首部(源地址為DIP,目標IP為RIP)

(a)?當(dāng)用戶請求到達Director Server,此時請求的數(shù)據(jù)報文會先到內(nèi)核空間的PREROUTING鏈。 此時報文的源IP為CIP,目標IP為VIP 。

(b)?PREROUTING檢查發(fā)現(xiàn)數(shù)據(jù)包的目標IP是本機,將數(shù)據(jù)包送至INPUT鏈

(c)?IPVS比對數(shù)據(jù)包請求的服務(wù)是否為集群服務(wù),若是,在請求報文的首部再次封裝一層IP報文,封裝源IP為為DIP,目標IP為RIP。然后發(fā)至POSTROUTING鏈。 此時源IP為DIP,目標IP為RIP

(d)?POSTROUTING鏈根據(jù)最新封裝的IP報文,將數(shù)據(jù)包發(fā)至RS(因為在外層封裝多了一層IP首部,所以可以理解為此時通過隧道傳輸)。 此時源IP為DIP,目標IP為RIP

(e)?RS接收到報文后發(fā)現(xiàn)是自己的IP地址,就將報文接收下來,拆除掉最外層的IP后,會發(fā)現(xiàn)里面還有一層IP首部,而且目標是自己的lo接口VIP,那么此時RS開始處理此請求,處理完成之后,通過lo接口送給eth0網(wǎng)卡,然后向外傳遞。 此時的源IP地址為VIP,目標IP為CIP

(f)?響應(yīng)報文最終送達至客戶端

LVS-Tun模型特性

RIP、VIP、DIP全是公網(wǎng)地址

RS的網(wǎng)關(guān)不會也不可能指向DIP

所有的請求報文經(jīng)由Director Server,但響應(yīng)報文必須不能進過Director Server

不支持端口映射

RS的系統(tǒng)必須支持隧道

其實企業(yè)中最常用的是 DR 實現(xiàn)方式,而 NAT 配置上比較簡單和方便,后邊實踐中會總結(jié) DR 和 NAT 具體使用配置過程。

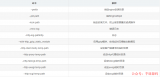

1.輪叫調(diào)度 rr

這種算法是最簡單的,就是按依次循環(huán)的方式將請求調(diào)度到不同的服務(wù)器上,該算法最大的特點就是簡單。輪詢算法假設(shè)所有的服務(wù)器處理請求的能力都是一樣的,調(diào)度器會將所有的請求平均分配給每個真實服務(wù)器,不管后端 RS 配置和處理能力,非常均衡地分發(fā)下去。

2. 加權(quán)輪叫 wrr

這種算法比 rr 的算法多了一個權(quán)重的概念,可以給 RS 設(shè)置權(quán)重,權(quán)重越高,那么分發(fā)的請求數(shù)越多,權(quán)重的取值范圍 0 – 100。主要是對rr算法的一種優(yōu)化和補充, LVS 會考慮每臺服務(wù)器的性能,并給每臺服務(wù)器添加要給權(quán)值,如果服務(wù)器A的權(quán)值為1,服務(wù)器B的權(quán)值為2,則調(diào)度到服務(wù)器B的請求會是服務(wù)器A的2倍。權(quán)值越高的服務(wù)器,處理的請求越多。

3. 最少鏈接 lc

這個算法會根據(jù)后端 RS 的連接數(shù)來決定把請求分發(fā)給誰,比如 RS1 連接數(shù)比 RS2 連接數(shù)少,那么請求就優(yōu)先發(fā)給 RS1

4. 加權(quán)最少鏈接 wlc

這個算法比 lc 多了一個權(quán)重的概念。

5. 基于局部性的最少連接調(diào)度算法 lblc

這個算法是請求數(shù)據(jù)包的目標 IP 地址的一種調(diào)度算法,該算法先根據(jù)請求的目標 IP 地址尋找最近的該目標 IP 地址所有使用的服務(wù)器,如果這臺服務(wù)器依然可用,并且有能力處理該請求,調(diào)度器會盡量選擇相同的服務(wù)器,否則會繼續(xù)選擇其它可行的服務(wù)器

6. 復(fù)雜的基于局部性最少的連接算法 lblcr

記錄的不是要給目標 IP 與一臺服務(wù)器之間的連接記錄,它會維護一個目標 IP 到一組服務(wù)器之間的映射關(guān)系,防止單點服務(wù)器負載過高。

7. 目標地址散列調(diào)度算法 dh

該算法是根據(jù)目標 IP 地址通過散列函數(shù)將目標 IP 與服務(wù)器建立映射關(guān)系,出現(xiàn)服務(wù)器不可用或負載過高的情況下,發(fā)往該目標 IP 的請求會固定發(fā)給該服務(wù)器。

8. 源地址散列調(diào)度算法 sh

與目標地址散列調(diào)度算法類似,但它是根據(jù)源地址散列算法進行靜態(tài)分配固定的服務(wù)器資源。

九、實踐LVS的NAT模式

1、實驗環(huán)境

三臺服務(wù)器,一臺作為 director,兩臺作為 real server,director 有一個外網(wǎng)網(wǎng)卡(172.16.254.200) 和一個內(nèi)網(wǎng)ip(192.168.0.8),兩個 real server 上只有內(nèi)網(wǎng) ip (192.168.0.18) 和 (192.168.0.28),并且需要把兩個 real server 的內(nèi)網(wǎng)網(wǎng)關(guān)設(shè)置為 director 的內(nèi)網(wǎng) ip(192.168.0.8)

2、安裝和配置

兩個?real?server?上都安裝?nginx?服務(wù)

# yum install -y nginx

?

Director?上安裝?ipvsadm

# yum install -y ipvsadm

Director 上編輯 nat 實現(xiàn)腳本

# vim /usr/local/sbin/lvs_nat.sh

# 編輯寫入如下內(nèi)容:

#! /bin/bash

# director服務(wù)器上開啟路由轉(zhuǎn)發(fā)功能:

echo?1?> /proc/sys/net/ipv4/ip_forward

# 關(guān)閉 icmp 的重定向

echo?0?> /proc/sys/net/ipv4/conf/all/send_redirects

echo?0?> /proc/sys/net/ipv4/conf/default/send_redirects

echo?0?> /proc/sys/net/ipv4/conf/eth0/send_redirects

echo?0?> /proc/sys/net/ipv4/conf/eth1/send_redirects

# director設(shè)置 nat 防火墻

iptables?-t?nat?-F

iptables?-t?nat?-X

iptables?-t?nat?-A?POSTROUTING?-s?192.168.0.0/24?-j?MASQUERADE

# director設(shè)置 ipvsadm

IPVSADM='/sbin/ipvsadm'

$IPVSADM?-C

$IPVSADM?-A?-t?172.16.254.200:80?-s?wrr

$IPVSADM?-a?-t?172.16.254.200:80?-r?192.168.0.18:80?-m?-w?1

$IPVSADM?-a?-t?172.16.254.200:80?-r?192.168.0.28:80?-m?-w?1

保存后,在 Director 上直接運行這個腳本就可以完成 lvs/nat 的配置

/bin/bash?/usr/local/sbin/lvs_nat.sh

查看ipvsadm設(shè)置的規(guī)則

ipvsadm?-ln

3、測試LVS的效果

通過瀏覽器測試2臺機器上的web內(nèi)容??。為了區(qū)分開,我們可以把 nginx 的默認頁修改一下:

在?RS1?上執(zhí)行

# echo "rs1rs1" >/usr/share/nginx/html/index.html

?

在?RS2?上執(zhí)行

# echo "rs2rs2" >/usr/share/nginx/html/index.html

注意,切記一定要在兩臺 RS 上設(shè)置網(wǎng)關(guān)的 IP 為 director 的內(nèi)網(wǎng) IP。

十、實踐LVS的DR模式

1、實驗環(huán)境

三臺機器:

Director節(jié)點: ?(eth0 192.168.0.8? vip eth0:0 192.168.0.38)

Real server1: (eth0 192.168.0.18 vip lo:0 192.168.0.38)

Real server2: (eth0 192.168.0.28 vip lo:0 192.168.0.38)

2、安裝

兩個?real?server?上都安裝?nginx?服務(wù)

# yum install -y nginx

?

Director?上安裝?ipvsadm

# yum install -y ipvsadm

3、Director 上配置腳本

# vim /usr/local/sbin/lvs_dr.sh

#! /bin/bash

echo?1?> /proc/sys/net/ipv4/ip_forward

ipv=/sbin/ipvsadm

vip=192.168.0.38

rs1=192.168.0.18

rs2=192.168.0.28

ifconfig?eth0:0?down

ifconfig?eth0:0?$vip?broadcast?$vip?netmask?255.255.255.255?up

route?add?-host?$vip dev?eth0:0

$ipv?-C

$ipv?-A?-t?$vip:80?-s?wrr

$ipv?-a?-t?$vip:80?-r?$rs1:80?-g?-w?3

$ipv?-a?-t?$vip:80?-r?$rs2:80?-g?-w?1

執(zhí)行腳本:

# bash /usr/local/sbin/lvs_dr.sh

4、在2臺 rs 上配置腳本:

# vim /usr/local/sbin/lvs_dr_rs.sh

#! /bin/bash

vip=192.168.0.38

ifconfig?lo:0?$vip?broadcast?$vip?netmask?255.255.255.255?up

route?add?-host?$vip?lo:0

echo?"1"?>/proc/sys/net/ipv4/conf/lo/arp_ignore

echo?"2"?>/proc/sys/net/ipv4/conf/lo/arp_announce

echo?"1"?>/proc/sys/net/ipv4/conf/all/arp_ignore

echo?"2"?>/proc/sys/net/ipv4/conf/all/arp_announce

rs 上分別執(zhí)行腳本:

bash?/usr/local/sbin/lvs_dr_rs.sh

5、實驗測試

測試方式同上,瀏覽器訪問?

注意:在 DR 模式下,2臺 rs 節(jié)點的 gateway 不需要設(shè)置成 dir 節(jié)點的 IP 。

參考鏈接地址:

十一、LVS結(jié)合keepalive

LVS可以實現(xiàn)負載均衡,但是不能夠進行健康檢查,比如一個rs出現(xiàn)故障,LVS 仍然會把請求轉(zhuǎn)發(fā)給故障的rs服務(wù)器,這樣就會導(dǎo)致請求的無效性。keepalive 軟件可以進行健康檢查,而且能同時實現(xiàn) LVS 的高可用性,解決 LVS 單點故障的問題,其實 keepalive 就是為 LVS 而生的。

1、實驗環(huán)境

4臺節(jié)點

Keepalived1 + lvs1(Director1):192.168.0.48

Keepalived2 + lvs2(Director2):192.168.0.58

Real server1:192.168.0.18

Real server2:192.168.0.28

IP: 192.168.0.38

2、安裝系統(tǒng)軟件

Lvs + keepalived的2個節(jié)點安裝

# yum install ipvsadm keepalived -y

Real server + nginx服務(wù)的2個節(jié)點安裝

# yum install epel-release -y

# yum install nginx -y

3、設(shè)置配置腳本

Real server節(jié)點2臺配置腳本:

# vim /usr/local/sbin/lvs_dr_rs.sh

#! /bin/bash

vip=192.168.0.38

ifconfig?lo:0?$vip?broadcast?$vip?netmask?255.255.255.255?up

route?add?-host?$vip?lo:0

echo?"1"?>/proc/sys/net/ipv4/conf/lo/arp_ignore

echo?"2"?>/proc/sys/net/ipv4/conf/lo/arp_announce

echo?"1"?>/proc/sys/net/ipv4/conf/all/arp_ignore

echo?"2"?>/proc/sys/net/ipv4/conf/all/arp_announce

?

2節(jié)點rs?上分別執(zhí)行腳本:

bash?/usr/local/sbin/lvs_dr_rs.sh

keepalived節(jié)點配置(2節(jié)點):

主節(jié)點(?MASTER?)配置文件

vim?/etc/keepalived/keepalived.conf

vrrp_instance?VI_1?{

????state?MASTER

????interface?eth0

????virtual_router_id?51

????priority?100

????advert_int?1

????authentication?{

????????auth_type PASS

????????auth_pass?1111

????}

????virtual_ipaddress?{

????????192.168.0.38

????}

}

?

virtual_server?192.168.0.38?80?{

????delay_loop?6

????lb_algo rr

????lb_kind DR

????persistence_timeout?0

????protocol TCP

?

????real_server?192.168.0.18?80?{

????????weight?1

????????TCP_CHECK?{

????????????connect_timeout?10

????????????nb_get_retry?3

????????????delay_before_retry?3

????????????connect_port?80

????????}

????}

?

????real_server?192.168.0.28?80?{

????????weight?1

????????TCP_CHECK?{

????????????connect_timeout?10

????????????nb_get_retry?3

????????????delay_before_retry?3

????????????connect_port?80

????????}

????}

}

從節(jié)點( BACKUP )配置文件

拷貝主節(jié)點的配置文件keepalived.conf,然后修改如下內(nèi)容:

state?MASTER?->?state BACKUP

priority?100?->?priority?90

keepalived的2個節(jié)點執(zhí)行如下命令,開啟轉(zhuǎn)發(fā)功能:

# echo 1 > /proc/sys/net/ipv4/ip_forward

4、啟動keepalive

<strong>先主后從分別啟動keepalivestrong>

service keepalived?start

5、驗證結(jié)果

實驗1

手動關(guān)閉192.168.0.18節(jié)點的nginx,service?nginx stop 在客戶端上去測試訪問??結(jié)果正常,不會出現(xiàn)訪問18節(jié)點,一直訪問的是28節(jié)點的內(nèi)容。

實驗2

手動重新開啟 192.168.0.18 節(jié)點的nginx,?service?nginx start 在客戶端上去測試訪問??結(jié)果正常,按照 rr 調(diào)度算法訪問18節(jié)點和28節(jié)點。

實驗3

測試 keepalived 的HA特性,首先在master上執(zhí)行命令 ip addr ,可以看到38的vip在master節(jié)點上的;這時如果在master上執(zhí)行?service?keepalived stop 命令,這時vip已經(jīng)不再master上,在slave節(jié)點上執(zhí)行 ip addr 命令可以看到 vip 已經(jīng)正確漂到slave節(jié)點,這時客戶端去訪問??訪問依然正常,驗證了 keepalived的HA特性。

lvs 介紹:

電子發(fā)燒友App

電子發(fā)燒友App

評論