不久前,一位朋友跟筆者講了這樣一個故事:去年底,曾有人問他為什么說賽靈思(Xilinx)是百度這樣的互聯網公司的“爸爸”?他表示,起初還真不知道如何回答這個問題。恰好有一場賽靈思的線下活動,他們就一起來到活動現場。在親眼目睹賽靈思展示的數據中心加速方案后,尤其是看到服務器中因插入賽靈思那張紅色的Alveo加速器卡,數據處理能力立刻有了驚人的提升,他們頓時有了自己的答案。

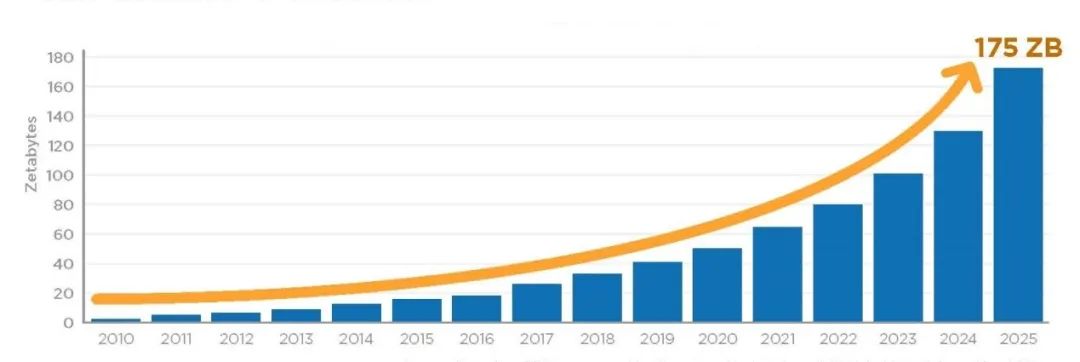

我們知道,所謂的萬物互聯,就是無數的電子設備與互聯網進行連接,從而創造一個魔幻的數字世界,與此同時,也產生了海量的數據。根據IDC的預測,從2018年至2025年,全球的數據增長量達到5倍以上,將從2018年的32ZB增至2025年的175ZB。中國將在2025年以48.6ZB的數據量及27.8%的占比成為全球最大的數據匯集地。然而,這些數據的分析和使用必須借助數據中心強大的計算平臺來完成,對數據中心而言,這是難得的機遇,更是前所未有的挑戰。

圖1:2010年至2025年全球數據量增長情況(圖片來源:IDC) 數據中心蘊含巨大的市場潛力

現在,企業和專業用戶越來越意識到從物理和虛擬世界收集到的大量數據蘊含的價值。隨著數據量繼續呈指數級增長,對數據分析的需求也將以類似的速度增長。為此,數據中心必須加速轉型,以達到增加網絡帶寬,優化人工智能等工作負載的目的,同時還要保證較低的功耗以及提供新服務的能力。綜合技術與成本等因素,數據中心加速器有助于顯著提高數據中心的性能。

在數據中心加速器市場,深度學習訓練(Deep Learning Training)在應用方面占有重要份額。根據BMRC的預測,到2025年,深度學習訓練市場將達到233.8億美元,2018年和2025年復合年增長率為40.16%。數據中心又如何支持這一巨大需求呢?

在回答這個問題之前,我們先來看一看各大咨詢機構對數據中心發展潛力的研判。

根據調研機構Gartner的分析結果,預計全球公有云服務市場在2020年將增長17%,達到2664億美元。其中,軟件即服務(SaaS)仍將是最大的細分市場,預計該市場將在2020年增長至1160億美元。第二大市場則是基礎設施即服務(IaaS),2020年的市場規模將達到500億美元。

圖2:全球公共云服務收入預測(單位:十億美元)(圖片來源:Gartner)

根據思科公司的調查數據,到2021年,全球云計算數據中心流量可能達到每年20.6ZB,預計全球將有628個超大規模數據中心運營。

根據調研機構Frost&Sullivan的調查報告,全球互聯網IP流量預計會從2016年的6.8ZB增長到2022年的24.6ZB。不斷增長的全球互聯網和移動數據流量導致數據增長,因此,對數據中心的數據傳輸和存儲需求將明顯增加。

Technavio公司最新發布的報告顯示,2019~2023年全球數據中心市場規模有望增長2844.4億美元,復合年增長率將超過17%。

根據Structure Research公司的調查數據,到2024年,全球托管數據中心市場收入將增加一倍,達到697.6億美元。

據Vertiv公司預測,到2025年,邊緣數據中心將成為該行業的普遍發展做法,邊緣計算的站點到2025年將增加三倍。

云計算基礎設施廠商Apcera公司預測,到2025年,全球數據中心轉型市場預計將從2017年的58.6億美元增長到159.2億美元,至2026年的預測期內,復合年增長率為13.2%。

數據中心硬件加速勢在必行

數據量的爆炸性增長和工作負載的復雜性,已經超過了現有數據中心計算平臺的性能。面對如此情形,無論是公有云、私有云還是混合云,大幅提升數據中心的利用率、性能和能效,降低運營成本和總成本,實現數據中心的轉型升級成為當務之急。

高性能計算(HPC)領域的專家一直致力于推動新平臺的開發,通過異構體系架構實現硬件加速,將傳統CPU、圖形處理單元(GPU)和現場可編程門陣列(FPGA)等進行靈活組合。隨著新一代計算加速器的出現,數據中心在性能和能效上均有了大幅提升。 那么,究竟從何時開始數據中心的服務器需要增加FPGA、GPU等加速器呢?這要從摩爾定律開始講起。 根據摩爾定律,集成電路中每平方英寸的晶體管數量每隔18個月就會翻一番。然而到了2020年,業界關于摩爾定律即將失效的討論越來越多。2015年4月,英特爾表示,通過開發7nm和5nm制程工藝,摩爾定律仍將得以延續。然而,進一步減小處理器的尺寸將非常困難,因為這樣做會減少電子和空穴之間的空間,進而出現電流泄漏和過熱等問題,最終導致芯片的性能下降、功耗大、耐久性降低。因此,必須尋找其他替代方案來提高芯片的計算能力。

按處理器類型劃分的數據中心加速器市場,目前主要有三種方案,即通過GPU、FPGA、ASIC來加速,其中,GPU在數據中心加速器市場的占比較大。英偉達是數據中心GPU加速器市場的主要推動者,在數據中心市場與英特爾形成了激烈的競爭。隨著摩爾定律的放緩,GPU加速器有望在深度學習、訓練和推理應用方面取得重大成功。

圖3:英偉達HGX A100支持標準化的高性能服務器(圖片來源:英偉達)

現在,一個典型的通用處理器已經無法維持分析應用程序增加的計算復雜度,基于FPGA的異構體系結構使計算密集型和重復性任務能夠從主CPU上卸載。與其他平臺相比,FPGA可以提供更高的性能,并且具有足夠的適應性,能夠滿足未來的需求和未來的算法,進而有望成為高效執行數據分析的主要平臺。

為什么看好FPGA加速器?

FPGA(現場可編程門陣列)是一種集成可重構器件,具有運算速度快、功耗低等優點,在計算密集型應用中得到廣泛的應用。與GPU和多核CPU相比,FPGA具有更好的能量效率,并且可以達到11x和57x的速度。此外,對于某些類型的圖像處理應用,如立體視覺應用,FPGA可以說是非常好的選擇。FPGA的不足也很明顯,比如設計一個FPGA架構需要很長時間,需要設計人員有較強的軟硬件開發技能。

現在,數據中心在其基礎設施中部署FPGA有兩種主要方法,一種是FPGA與CPU緊密耦合,另一種是FPGA作為獨立組件。

方法一

將FPGA作為協處理器,FPGA與CPU物理連接在一起,此時的FPGA既是加速器又是數據中心的一部分。但是,數據中心的FPGA數量受CPU數量的限制,不能作為獨立的計算資源使用。在市場上,已經有Amazon提供的集成Xilinx Virtex UltraScale+的EC2 F1實例。F1實例易于編程,并且配備了開發、模擬、調試和編譯硬件加速代碼所需的各種資源,包括FPGA Developer AMI,并支持在云上進行硬件級開發。對于許多應用程序,使用F1實例部署硬件加速都非常有用,可解決需要高帶寬、增強型聯網和超高計算能力的復雜科學、工程和業務問題。按照Amazon的信息,在EC2 F1實例上運行高性能計算幾乎可以實現無限的容量來擴展基礎設施。與CPU相比,Amazon EC2 F1實例可將速度提升高達100倍,適用于各種受計算限制的應用程序。

方法二

將FPGA看作獨立于CPU的單獨組件,FPGA直接連接到網絡。這種方法將網絡和應用程序處理耦合在同一個FPGA器件中。因為應用程序可以獨立于服務器數量來擴展FPGA的數量,所以系統的延遲和吞吐量都會有明顯改善。

圖4:賽靈思Alveo加速器卡大幅提升數據中心部署的標準服務器性能(圖片來源:Xilinx) 在這場基于FPGA加速器的數據中心變革中,賽靈思可謂是一大受益者。該公司自2018年啟動數據中心優先戰略以來,在2019年就推出了Alveo加速器卡,大幅提升了云端和本地數據中心部署的標準服務器的性能。Alveo產品系列目前已擴展至Alveo U50、U200、U250、U280四款產品,并已在美國、歐洲和中國市場得到廣泛應用。 目前,中國的浪潮集團已基于主流FPGA芯片,開發出高密度、高性能、易編程的FPGA異構加速運算卡,并且在機器學習、視頻分析、語音識別、文本搜索等場景得到了很好的落地應用。根據IDC最新數據,浪潮已經躋身全球服務器出貨量前三,中國的AI服務器市場出貨量第一。在浪潮提供的AI產品和解決方案中,包括全球首款內嵌HBM2高帶寬內部存儲的加速卡、面向視頻監控領域的多通道視頻AI加速卡等都內置了賽靈思的FPGA產品。 結語

隨著數據量以指數級增長,對數據分析的需求也開始快度增長。原有的硬件和軟件體系結構已經無法滿足數據生成、存儲和分析的需求,“加速”正在成為數據中心的當務之急。從目前的市場情況看,GPU在數據中心加速器市場占據較大比例,主要面向深度學習、AI訓練和推理等應用。FPGA以其可配置性、靈活性、并行性和功耗效率,確保了數據處理工作負載的有效和高效加速,進而迅速成為眾多互聯網公司在云計算和AI業務上的重要支撐,為云服務提供了一個令人信服的替代方案。

-

數據中心

+關注

關注

16文章

4859瀏覽量

72382 -

萬物互聯

+關注

關注

1文章

224瀏覽量

14172

原文標題:數據中心當務之急的三件事是什么?加速!加速!加速!

文章出處:【微信號:Mouser-Community,微信公眾號:貿澤電子設計圈】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

數據中心三維可視化管理系統功能特點

數據中心當務之急的三件事是什么?

數據中心當務之急的三件事是什么?

評論