進入2021年,隨著越來越多的組織采用新技術,人工智能在技術和網絡安全方面的未來將繼續(xù)發(fā)展。根據最近的一項調查,三分之二的組織已經在將智能技術用于網絡安全目的。使用這些工具可以使公司為使用網絡犯罪技術而不斷發(fā)展的創(chuàng)新攻擊做好更充分的準備,也可以使用AI技術。例如,僅在去年,犯罪分子就使用了基于AI的軟件來復制CEO的聲音,要求現金轉移220,000歐元(約合243,000美元)。

對于希望在2021年將更多的AI集成到其安全堆棧中的企業(yè)而言,遵循以下六個步驟以確保有效使用AI而不至于損害其他任何地方的安全至關重要。

鼓勵將AI負責任地用于網絡安全

最近的數據發(fā)現,四分之三的高管認為使用AI可使他們的組織對違規(guī)行為做出更快的響應。威脅形勢繼續(xù)迅速變化,網絡安全領導者必須采用AI來應對網絡犯罪分子制定的新策略。反過來,企業(yè)必須集中精力確保政策支持這種擁抱。例如,美國對AI計劃的出口管制應確保企業(yè)在使用AI方面繼續(xù)在全球網絡安全市場中保持競爭力。

確保AI概念參與威脅建模和風險管理

AI的部署在全球范圍內不斷增長,已經有超過四分之一的AI計劃已經投入生產,而超過三分之一的項目則處于高級開發(fā)階段。但是,謹慎考慮攻擊者可能如何試圖破壞這種增長和新集成的AI系統(tǒng)的穩(wěn)定性。盡管尚未廣泛使用,但隨著數據攻擊被廣泛采用,包括數據中毒攻擊和訓練模型后門在內的網絡攻擊可能會針對機器學習系統(tǒng)進行部署。結合了AI系統(tǒng)的威脅模型很少見,而且往往不成熟。業(yè)務領導者應努力開發(fā)方法,以確保AI處于風險管理活動范圍之內,以最大程度地減少此類威脅。

制定和推廣AI系統(tǒng)的道德準則

公共部門和私營部門都應在AI應用程序中使用道德準則,并鼓勵在這些道德框架中納入強大的安全性和透明度控制。有很多方法可以將AI應用于網絡安全程序,并且重要的是要確保認可諸如Microsoft AI原則之類的框架。可以支持道德AI的原則包括:消除AI偏見,保護AI數據以及確保人們對AI技術如何影響世界負責。

支持透明度并公開分享新發(fā)現

有關AI的新研究以及新的對抗性攻擊和防御經常在會議論文集和學術期刊上發(fā)表。但是,有時,這些貢獻沒有足夠深入地解釋如何得出這些發(fā)現,并且許多論文沒有提供或鏈接到代碼,這將導致結果的準確再現。同樣,進行AI研究的企業(yè)通常是秘密進行的,這給AI進步的驗證和實施帶來了負擔。這給安全從業(yè)人員提供了一個更具挑戰(zhàn)性的環(huán)境,以評估針對這些模型的可能攻擊,最終使企業(yè)更難應對這些威脅。

優(yōu)先進行AI系統(tǒng)的進攻性研究

在將AI技術應用于產品之前,企業(yè)必須驗證針對這些新技術的潛在風險。組織應確保AI應用程序和相關的機器學習系統(tǒng)對當前的安全程序監(jiān)視和測試范圍有意義。監(jiān)視和測試應包括兩家企業(yè)自發(fā)采取的措施,以支持發(fā)現可能未注意到的無法預料的AI缺陷,以及安全框架和指導以及與安全研究人員的合作。

敦促創(chuàng)建和整合隱私保護機器學習

盡管機器學習和AI技術繼續(xù)變得越來越流行,但對隱私的影響尚待廣泛探討。特別是神經網絡可以從訓練數據中記住特定的例子。因此,AI系統(tǒng)可能容易受到模型反轉攻擊的攻擊,這些攻擊導致通過重復查詢模型重新創(chuàng)建訓練示例的方式,竊取了模型所訓練的數據。如果模型是針對敏感數據進行訓練的,則攻擊者可能能夠恢復有關訓練數據的信息。隱私漏洞的風險不斷增加,導致人們越來越需要采用和開發(fā)保留隱私的機器學習系統(tǒng)。這不僅可以保護業(yè)務,還可以保護使用數據來訓練模型的消費者。

將AI集成到網絡安全計劃中并非易事。企業(yè)領導者必須認識到合并所帶來的挑戰(zhàn),并開發(fā)解決方案以增強網絡安全計劃,同時保持道德并保護私有數據。負責任地使用人工智能技術,除了遵循明確的公共準則外,鼓勵進行威脅建模和持續(xù)的人工智能研究是必不可少的步驟,這些步驟將在將AI集成到網絡安全程序中時帶來成功。

責編AJX

-

網絡安全

+關注

關注

10文章

3193瀏覽量

60206 -

AI

+關注

關注

87文章

31520瀏覽量

270335 -

機器學習

+關注

關注

66文章

8438瀏覽量

133087

發(fā)布評論請先 登錄

相關推薦

加密算法在網絡安全中扮演什么角色?

IP地址庫在網絡安全中有哪些作用

如何安全有效的刪代碼?

邏輯異或在網絡安全中的應用實例

最有效的云服務器網絡安全防護措施

IBM和微軟加強在網絡安全領域的合作

IP地址與網絡監(jiān)控

微軟和IBM宣布加強網絡安全領域的合作:助力安全運營現代化,降低云身份安全風險

3芯M16接頭在網絡工程中的應用

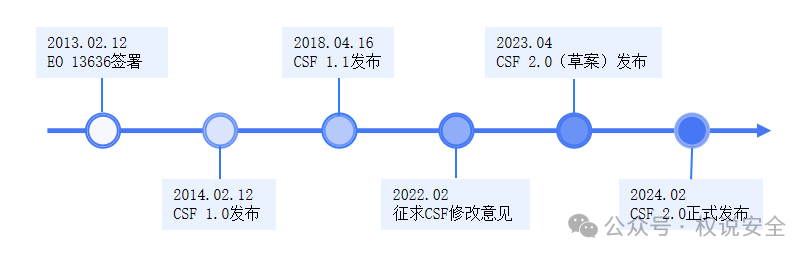

專家解讀 | NIST網絡安全框架(1):框架概覽

微軟即將發(fā)布AI安全產品

智慧路燈桿AI監(jiān)測應用,讓高速出行更安全

如何在網絡中有效地更安全使用AI?

如何在網絡中有效地更安全使用AI?

評論