NVIDIA AI 仍是唯一能夠運行 MLPerf 行業基準測試中所有測試的平臺, A100 GPU 自發布以來連續兩年一直保持著獲勝次數最多的紀錄。

根據今天發布的 MLPerf 基準測試結果, NVIDIA 及其合作伙伴占了所有參賽生態伙伴的 90%,并且繼續提供了最佳的整體 AI 訓練性能和提交了最多的測試項。

NVIDIA AI 平臺覆蓋了 MLPerf 訓練 2.0 版本中的所有八項基準測試,突顯了其領先的通用性。

除 NVIDIA 之外,無其它加速器運行過所有基準測試,這些基準測試代表了流行的 AI 用例,包括語音識別、自然語言處理、推薦系統、目標檢測、圖像分類等,而 NVIDIA 自 2018 年 12 月向作為行業標準 AI 基準測試的 MLPerf 提交首輪測試結果以來就一直如此。

領先的基準測試結果與可用性

在連續第四次 MLPerf 訓練提交結果中,基于 NVIDIA Ampere 架構的 NVIDIA A100 Tensor Core GPU 依然表現出色。

各個提交者平臺在每個網絡的“最快訓練時間”

Selene 是 NVIDIA 內部的一臺 AI 超級計算機,它基于模塊化的 NVIDIA DGX SuperPOD,并由 NVIDIA A100 GPU、軟件堆棧和 NVIDIA InfiniBand 網絡驅動,在八項大規模工作負載測試的四項中獲得 “最快訓練時間” 。

為了計算單芯片性能,該圖表將每份提交結果歸一化到每個提交者最常見的尺度,檢測分數歸一化到速度最快的競爭者,最快競爭者顯示為 1 倍。

NVIDIA A100 還保持了單芯片性能上的領導地位,在八項測試中的六項測試中呈現了最快的速度。

共有 16 家合作伙伴使用 NVIDIA AI 平臺提交了本輪結果,包括華碩、百度、中國科學院自動化研究所、戴爾科技、富士通、技嘉、新華三、慧與、浪潮、聯想、寧暢和超微。

NVIDIA 的大多數 OEM 合作伙伴提交了使用 NVIDIA 認證系統得到的結果,這些服務器經過 NVIDIA 驗證,能夠為企業部署提供出色的性能、可管理性、安全性和可擴展性。

多種模型驅動實際 AI 應用

AI 應用可能需要理解用戶說出的要求,對圖像進行分類、提出建議并以語音信息的形式作出回應。

即使是上圖簡單的用例也需要將近 10個模型,這突出了運行每個基準的重要性

這些任務需要多種類型的 AI 模型按順序工作,用戶需要能夠快速且靈活地設計、訓練、部署和優化這些模型。

這也是為什么通用性(能夠在 MLPerf 及其他版本中運行每個模型)以及領先的性能都是將現實世界的 AI 引入入生產的關鍵。

通過 AI 實現投資回報

對于客戶而言,數據科學和工程團隊是最寶貴的資源,他們的生產力決定了 AI 基礎設施的投資回報。客戶必須考慮昂貴的數據科學團隊的成本,這通常在部署 AI 的總成本中占比很重,而部署 AI 基礎設施本身的成本相對較少。

AI 研究人員的生產力取決于能否快速測試新的想法,這需要通用性來訓練任何模型,以及大規模訓練模型所能提供的速度。這就是為什么企業關注單位成本的整體生產力,以確定最佳的 AI 平臺——更全面的視角,更準確地代表了部署 AI 的真實成本。

此外, AI 基礎設施的利用率取決于可替換性,或在單一平臺上加速從數據準備到訓練再到推理的整個 AI 工作流程的能力。

憑借 NVIDIA AI,客戶可以在整個 AI 流程中使用相同的基礎設施,重新利用它來適配數據準備、訓練和推理之間的不同需求,這極大地提高了利用率,實現了非常高的投資回報率。

隨著研究人員發現新的 AI 突破口,支持最新模型創新是最大程度地延長 AI 基礎設施使用壽命的關鍵。

NVIDIA AI 兼容并適用于每個模型、可以擴展到任何規模,并加速從數據準備到訓練再到推理的端到端 AI 流程,能夠實現最高的單位成本生產力。

今天的結果再次證明了 NVIDIA 在迄今為止所有 MLPerf 訓練、推理和 HPC 評測中所展示的豐富而深厚的 AI 專業性。

3 年半內將性能提高 23 倍

自首次基于 A100 提交 MLPerf 基準測試以來的兩年時間里,在 NVIDIA 軟件堆棧持續優化的推動下, NVIDIA 平臺的性能已提高了 6 倍。

自 MLPerf 問世以來,歸功于跨 GPU、軟件和大規模改進的全棧式創新, NVIDIA AI 平臺在 3 年半時間里,在基準測試中實現了 23 倍的性能提升。正是這種對創新的持續追求,讓客戶確信他們現今投資的 AI 平臺將持續服務 3 至 5 年,并將繼續推進以適配最先進的技術。

此外, NVIDIA 于 3 月發布的 NVIDIA Hopper架構有望在未來的 MLPerf 基準測評中實現性能的另一巨大飛躍。

NVIDIA 如何做到這一點

軟件創新持續釋放 NVIDIA Ampere架構的更多性能。

例如,在提交結果中大量使用的 CUDA Graphs,該軟件可以最大限度地減少跨多個加速器上運行作業的啟動開銷。NVIDIA 不同庫的內核優化,如 cuDNN 和預處理庫 DALI,解鎖了額外的加速。NVIDIA 還實現了跨硬件、軟件和網絡的全棧改進,如 NVIDIA Magnum IO 和 SHARP,將部分 AI 功能卸載到網絡中,以獲得更好的性能,特別是在大規模的情況中。

NVIDIA 所使用的所有軟件均可從 MLPerf 資源庫中獲取,所有人都可以獲得 NVIDIA 的世界級領先成果。NVIDIA 不斷地將這些優化集成到 NVIDIA 的 GPU 應用軟件中心—— NGC 上提供的容器中,并通過 NVIDIA AI Enterprise 提供完全由 NVIDIA 支持,并經過優化的軟件。

從 A100 GPU 兩年前首次提交以來, NVIDIA AI 平臺繼續在 MLPerf 2.0 中提供最高的性能,仍是唯一能夠提交所有基準測試的平臺。NVIDIA 的下一代 Hopper 架構有望在未來的 MLPerf 評測中實現另一巨大飛躍。

NVIDIA 平臺適用于任何規模的模型和框架,并具有可替代性以處理 AI 工作負載的每個部分。它可以在所有云端和主要的服務器制造商上使用。

原文標題:NVIDIA 與合作伙伴在 MLPerf 中展示領先的 AI 性能和通用性

文章出處:【微信公眾號:NVIDIA英偉達企業解決方案】歡迎添加關注!文章轉載請注明出處。

審核編輯:湯梓紅

-

NVIDIA

+關注

關注

14文章

5076瀏覽量

103728 -

gpu

+關注

關注

28文章

4777瀏覽量

129360 -

AI

+關注

關注

87文章

31536瀏覽量

270347 -

基準測試

+關注

關注

0文章

21瀏覽量

7614 -

MLPerf

+關注

關注

0文章

35瀏覽量

649

原文標題:NVIDIA 與合作伙伴在 MLPerf 中展示領先的 AI 性能和通用性

文章出處:【微信號:NVIDIA-Enterprise,微信公眾號:NVIDIA英偉達企業解決方案】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

NVIDIA發布Cosmos平臺,加速物理AI開發

交通運輸領先企業率先采用NVIDIA Cosmos平臺

NVIDIA發布Cosmos?平臺,助力物理AI系統發展

MLCommons推出AI基準測試0.5版

使用NVIDIA AI平臺確保醫療數據安全

賴耶科技通過NVIDIA AI Enterprise平臺打造超級AI工廠

NVIDIA與思科合作打造企業級生成式AI基礎設施

浪潮信息AS13000G7榮獲MLPerf? AI存儲基準測試五項性能全球第一

NVIDIA在加速計算和生成式AI領域的創新

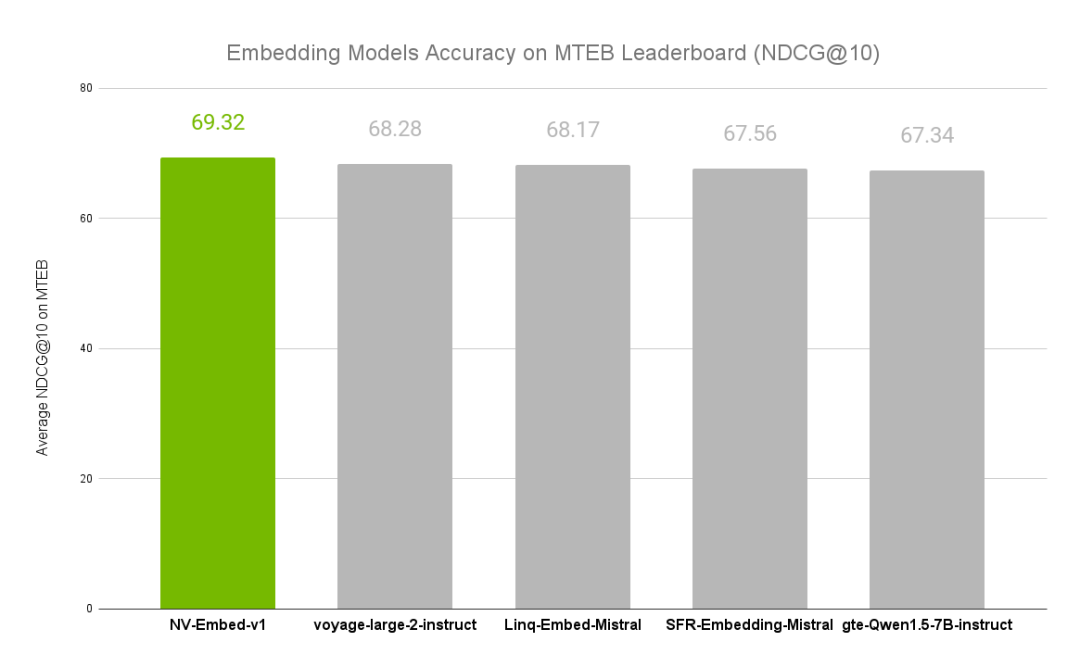

NVIDIA文本嵌入模型NV-Embed的精度基準

NVIDIA推出用于支持在全新GeForce RTX AI筆記本電腦上運行的AI助手及數字人

NVIDIA 通過 Holoscan 為 NVIDIA IGX 提供企業軟件支持,實現邊緣實時醫療、工業和科學 AI 應用

NVIDIA AI平臺在MLPerf基準測試實現飛躍

NVIDIA AI平臺在MLPerf基準測試實現飛躍

評論