“ 在學(xué)習(xí)CNN的時候,我讀到Dropout具有正則化的作用時,不明白正則化的意思,查看了很多資料,寫的都很深奧,這里我用簡單的語言來記錄一下。。”

01

—

正則化定義

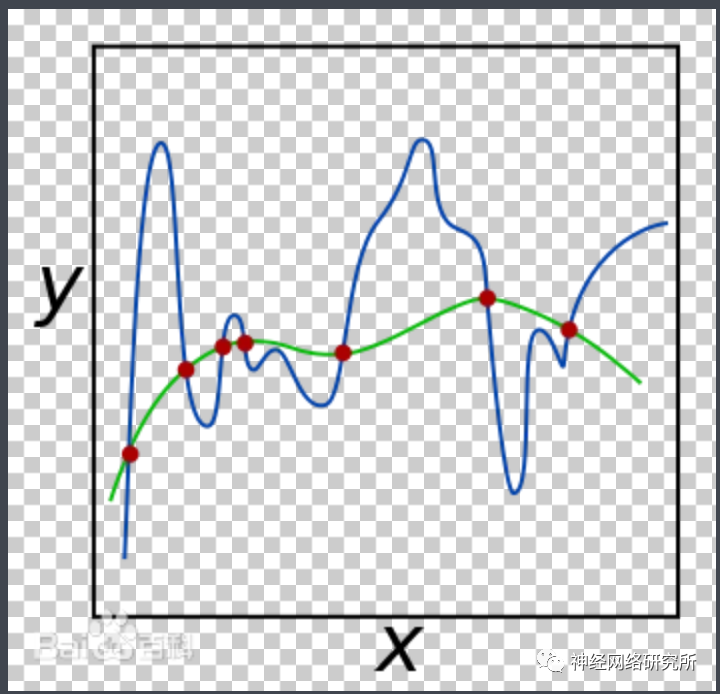

百度百科的定義寫的非常的學(xué)術(shù)化,我用我的理解來敘述一遍:通俗的意義來講就是我們想要通過一條光滑曲線(圖中綠色的曲線)來最大程度的擬合另外一條歪七扭八的曲線(圖中的藍(lán)色曲線),這樣我們就可以將這條歪七扭八存在諸多奇點(diǎn)的曲線通過方程的形式表達(dá)出來,這種做法就叫做正則化。

這樣做后,我們通過曲線來預(yù)測或者表示原圖像的時候,結(jié)果勢必就會有誤差,如果沒有誤差會是什么呢?那就是說我們找了一條和圖中藍(lán)色曲線一模一樣的線來表示藍(lán)色的線,也就是說我們把一些有噪音的點(diǎn)也表示出來了,這種行為放在卷積中就叫做 過擬合 ,而在卷積中,相比較于過擬合曲線,我們更希望有一條正則化的曲線。換句話說,正則化的作用就是為了防止過擬合。那么Dropout是怎么實(shí)現(xiàn)過擬合的呢?

02

—

Dropout怎么防止過擬合

在第一眼看到Dropout的時候,我本來認(rèn)為只是簡單地舍棄了一些神經(jīng)元而已,經(jīng)過研究,我發(fā)現(xiàn)其中的原理并沒有我想的那么簡單。

我們從圖中看到,Dropout在每一層中通過概率來隨機(jī)的舍棄一些神經(jīng)元,注意!!!這些舍棄的神經(jīng)元只是在這一次訓(xùn)練中被舍棄,而不是永久的被舍棄,也就是說,等到下一波數(shù)據(jù)到來的時候,其中一些神經(jīng)元依然會參與訓(xùn)練,最后整個網(wǎng)絡(luò)被訓(xùn)練完成后,圖中所有的神經(jīng)元都是被訓(xùn)練過的!那這么做有什么好處呢?

在左圖的標(biāo)準(zhǔn)神經(jīng)網(wǎng)絡(luò)中,這只是一個神經(jīng)網(wǎng)絡(luò)在參與訓(xùn)練,而且容易發(fā)生過擬合。但是在右圖中,每一次訓(xùn)練的時候,都是不同的神經(jīng)元在參與訓(xùn)練,也就是說, 右圖不僅僅是一個神經(jīng)網(wǎng)絡(luò)!!!而是具有數(shù)十個神經(jīng)網(wǎng)絡(luò)在一起訓(xùn)練!!!這就是Dropout的偉大之處! 這種方法就相當(dāng)于,原來你是自己出謀劃策,現(xiàn)在多了數(shù)十個軍師為你出謀劃策,每一次都只聽取一個軍師的意見,這種方法當(dāng)然可以防止過擬合,而CNN的原理就是擬合一條曲線來表示每個輸入,在我們解決了過擬合問題后,我們就認(rèn)為Dropout具有正則化的作用!

-

曲線

+關(guān)注

關(guān)注

1文章

82瀏覽量

20909 -

方程

+關(guān)注

關(guān)注

0文章

33瀏覽量

16954 -

正則化

+關(guān)注

關(guān)注

0文章

17瀏覽量

8153

發(fā)布評論請先 登錄

相關(guān)推薦

關(guān)于Dropout、BN及數(shù)據(jù)預(yù)處理方案

shell正則表達(dá)式學(xué)習(xí)

賽靈思ISE? 設(shè)計(jì)套件11.1版對FPGA有什么優(yōu)化作用?

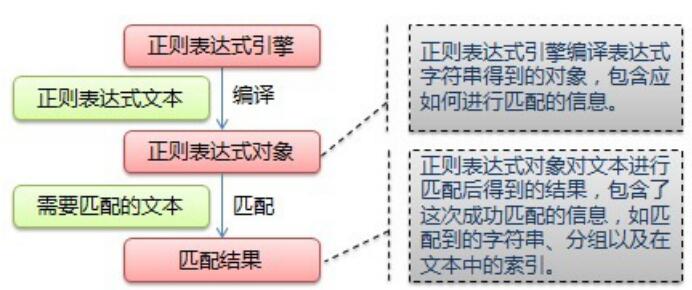

字符串處理、正則表達(dá)式用法

如何創(chuàng)建正則的表達(dá)式?

在舵機(jī)控制上PWM的作用是怎么體現(xiàn)的呢

如何使用QTIMER模塊來實(shí)現(xiàn)正交解碼

初識 Python 正則表達(dá)式

dropout正則化技術(shù)介紹

加權(quán)正則文法語言

【連載】深度學(xué)習(xí)筆記5:正則化與dropout

深度學(xué)習(xí)筆記5:正則化與dropout

UPIoT的主要作用和價值體現(xiàn)

Python正則表達(dá)式指南

Dropout怎么體現(xiàn)正則化作用?

Dropout怎么體現(xiàn)正則化作用?

評論