據(jù)外媒報(bào)道,上周四,Google、微軟、OpenAI 幾家公司的 CEO 受邀去白宮,共論關(guān)于人工智能發(fā)展的一些重要問(wèn)題。然而,讓人有些想不通的是,深耕 AI 多年的 Meta 公司(前身為 Facebook)卻沒(méi)有在受邀之列。

沒(méi)多久,更讓 Meta CEO 扎克伯格扎心的是,一位官員對(duì)此解釋稱(chēng),本次會(huì)議“側(cè)重的是目前在 AI 領(lǐng)域,尤其是面向消費(fèi)者的產(chǎn)品方面,處于領(lǐng)先地位的公司。”

顯然對(duì)于這樣的解釋?zhuān)⒉荒茏屓诵欧吘惯@一次受邀名單中還有一家由 OpenAI 的前成員創(chuàng)立的美國(guó)人工智能初創(chuàng)和公益公司 Anthropic。

似乎是為了出一口“氣”,也為證明自家的實(shí)力,相比 OpenAI、Google 推出閉源的 GPT-4、Bard 模型,Meta 在開(kāi)源大模型的路上一騎絕塵,繼兩個(gè)月前開(kāi)源 LLaMA大模型之后,再次于5 月 9 日開(kāi)源了一個(gè)新的 AI 模型——ImageBind(https://github.com/facebookresearch/ImageBind),短短一天時(shí)間,收獲了 1.6k 個(gè) Star。

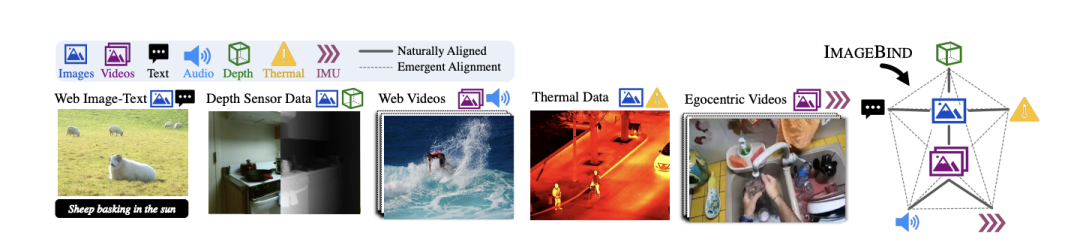

這個(gè)模型與眾不同之處便是可以將多個(gè)數(shù)據(jù)流連接在一起,包括文本、圖像/視頻和音頻、視覺(jué)、IMU、熱數(shù)據(jù)和深度(Depth)數(shù)據(jù)。這也是業(yè)界第一個(gè)能夠整合六種類(lèi)型數(shù)據(jù)的模型。

ImageBind 用圖像對(duì)齊六模態(tài),旨在實(shí)現(xiàn)感官大一統(tǒng)

簡(jiǎn)單來(lái)看,相比 Midjourney、Stable Diffusion 和 DALL-E 2 這樣將文字與圖像配對(duì)的圖像生成器,ImageBind 更像是廣撒網(wǎng),可以連接文本、圖像/視頻、音頻、3D 測(cè)量(深度)、溫度數(shù)據(jù)(熱)和運(yùn)動(dòng)數(shù)據(jù)(來(lái)自 IMU),而且它無(wú)需先針對(duì)每一種可能性進(jìn)行訓(xùn)練,直接預(yù)測(cè)數(shù)據(jù)之間的聯(lián)系,類(lèi)似于人類(lèi)感知或者想象環(huán)境的方式。

對(duì)此,Meta 在其官方博客中也說(shuō)道,“ImageBind 可以勝過(guò)之前為一種特定模式單獨(dú)訓(xùn)練的技術(shù)模型。但最重要的是,它能使機(jī)器更好地一起分析許多不同形式的信息,從而有助于推進(jìn)人工智能。”

打個(gè)比喻,人類(lèi)可以聽(tīng)或者閱讀一些關(guān)于描述某個(gè)動(dòng)物的文本,然后在現(xiàn)實(shí)生活中看到就能認(rèn)識(shí)。

你站在繁忙的城市街道等有刺激性環(huán)境中,你的大腦會(huì)(很大程度上應(yīng)該是無(wú)意識(shí)地)吸收景象、聲音和其他感官體驗(yàn),以此推斷有關(guān)來(lái)往的汽車(chē)、行人、高樓、天氣等信息。

在很多場(chǎng)景中,一個(gè)單一的聯(lián)合嵌入空間包含許多不同種類(lèi)的數(shù)據(jù),如聲音、圖像、視頻等等。

如今,基于 ImageBind 這樣的模型可以讓機(jī)器學(xué)習(xí)更接近人類(lèi)學(xué)習(xí)。

在官方博客中,Meta 分享 ImageBind 是通過(guò)圖像的綁定屬性,只要將每個(gè)模態(tài)的嵌入與圖像嵌入對(duì)齊,即圖像與各種模式共存,可以作為連接這些模式的橋梁,例如利用網(wǎng)絡(luò)數(shù)據(jù)將文本與圖像連接起來(lái),或者利用從帶有 IMU 傳感器的可穿戴相機(jī)中捕獲的視頻數(shù)據(jù)將運(yùn)動(dòng)與視頻連接起來(lái)。

ImageBind 整體概覽

從大規(guī)模網(wǎng)絡(luò)數(shù)據(jù)中學(xué)到的視覺(jué)表征可以作為目標(biāo)來(lái)學(xué)習(xí)不同模態(tài)的特征。這使得 ImageBind 能夠?qū)R與圖像共同出現(xiàn)的任何模式,自然地將這些模式相互對(duì)齊。與圖像有強(qiáng)烈關(guān)聯(lián)的模態(tài),如熱學(xué)和深度,更容易對(duì)齊。非視覺(jué)的模態(tài),如音頻和 IMU,具有較弱的關(guān)聯(lián)性。

ImageBind 顯示,圖像配對(duì)數(shù)據(jù)足以將這六種模式綁定在一起。該模型可以更全面地解釋內(nèi)容,使不同的模式可以相互 "對(duì)話(huà)",并在不觀察它們的情況下找到聯(lián)系。

例如,ImageBind 可以在沒(méi)有看到它們?cè)谝黄鸬那闆r下將音頻和文本聯(lián)系起來(lái)。這使得其他模型能夠 "理解 "新的模式,而不需要任何資源密集型的訓(xùn)練。

不過(guò),該模型目前只是一個(gè)研究項(xiàng)目,沒(méi)有直接的消費(fèi)者和實(shí)際應(yīng)用,但是它展現(xiàn)了生成式 AI 在未來(lái)能夠生成沉浸式、多感官內(nèi)容的方式,也表明了 Meta 正在以與 OpenAI、Google 等競(jìng)爭(zhēng)對(duì)手不同的方式,趟出一條屬于開(kāi)源大模型的路。

ImageBind 強(qiáng)大的背后

與此同時(shí),作為一種多模態(tài)的模型,ImageBind 還加入了 Meta近期開(kāi)源的一系列 AI 工具,包括DINOv2計(jì)算機(jī)視覺(jué)模型,這是一種不需要微調(diào)訓(xùn)練高性能計(jì)算機(jī)視覺(jué)模型的新方法;以及 Segment Anything(SAM),這是一種通用分割模型,可以根據(jù)任何用戶(hù)的提示,對(duì)任何圖像中的任何物體進(jìn)行分割。

ImageBind 是對(duì)這些模型的補(bǔ)充,因?yàn)樗鼘?zhuān)注于多模態(tài)表示學(xué)習(xí)。它試圖為多種模式學(xué)習(xí)提供一個(gè)統(tǒng)一的特征空間,包括但不限于圖像和視頻。在未來(lái), ImageBind 可以利用 DINOv2 的強(qiáng)大視覺(jué)特征來(lái)進(jìn)一步提高其能力。

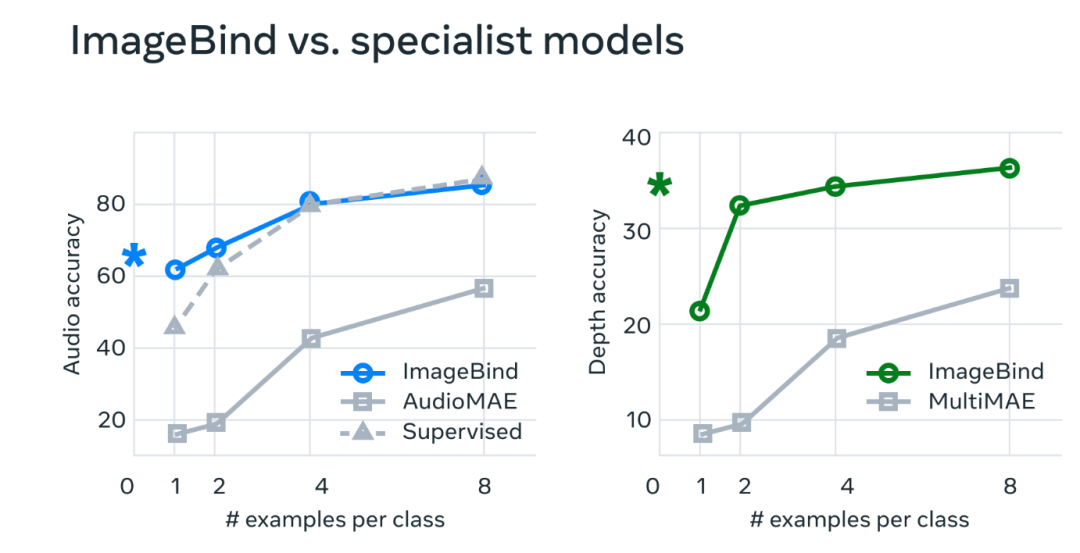

ImageBind 的性能

針對(duì) ImageBind 性能,Meta 研究科學(xué)家還發(fā)布了一篇《IMAGEBIND: One Embedding Space To Bind Them All》(https://dl.fbaipublicfiles.com/imagebind/imagebind_final.pdf)論文,分享了技術(shù)細(xì)則。

通過(guò)分析表明,ImageBind 模型的性能實(shí)際上可以通過(guò)使用很少的訓(xùn)練實(shí)例來(lái)提高。這個(gè)模型有新的出現(xiàn)的能力,或者說(shuō)是擴(kuò)展行為--也就是說(shuō),在較小的模型中不存在的能力,但在較大的版本中出現(xiàn)。這可能包括識(shí)別哪種音頻適合某張圖片或從照片中預(yù)測(cè)場(chǎng)景的深度。

而 ImageBind 的縮放行為隨著圖像編碼器的強(qiáng)度而提高。

換句話(huà)說(shuō),ImageBind 對(duì)準(zhǔn)各種模式的能力隨著視覺(jué)模型的強(qiáng)度和大小而增加。這表明,較大的視覺(jué)模型有利于非視覺(jué)任務(wù),如音頻分類(lèi),而且訓(xùn)練這種模型的好處超出了計(jì)算機(jī)視覺(jué)任務(wù)。

在實(shí)驗(yàn)中,研究人員使用了 ImageBind 的音頻和深度編碼器,并將其與之前在 zero-shot 檢索以及音頻和深度分類(lèi)任務(wù)中的工作進(jìn)行了比較。

結(jié)果顯示,ImageBind 可以用于少量樣本的音頻和深度分類(lèi)任務(wù),并且優(yōu)于之前定制的方法。

最終,Meta 認(rèn)為ImageBind 這項(xiàng)技術(shù)最終會(huì)超越目前的六種“感官”,其在博客上說(shuō)道,“雖然我們?cè)诋?dāng)前的研究中探索了六種模式,但我們相信引入連接盡可能多的感官的新模式——如觸覺(jué)、語(yǔ)音、嗅覺(jué)和大腦 fMRI 信號(hào)——將使更豐富的以人為中心的人工智能模型成為可能。”

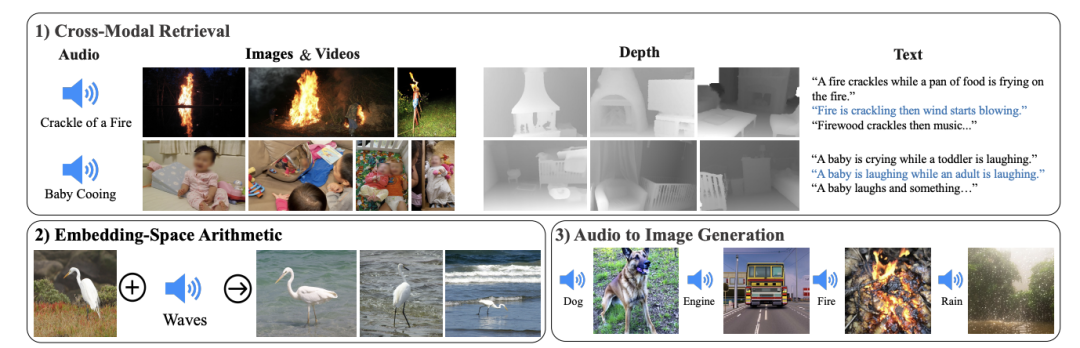

ImageBind 可以用來(lái)干什么?

如果說(shuō) ChatGPT 可以充當(dāng)搜索引擎、問(wèn)答社區(qū),Midjourney 可以被用來(lái)當(dāng)畫(huà)畫(huà)工具,那么用 ImageBind 可以做什么?

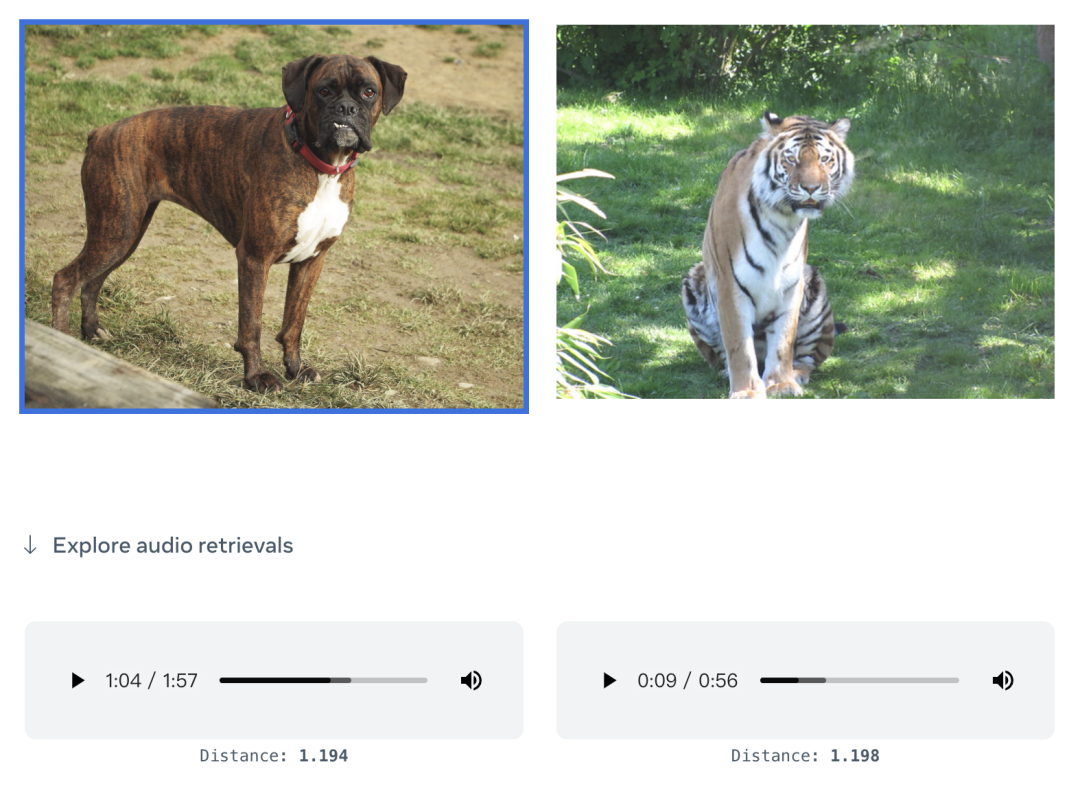

根據(jù)官方發(fā)布的 Demo 顯示,它可以直接用圖片生成音頻:

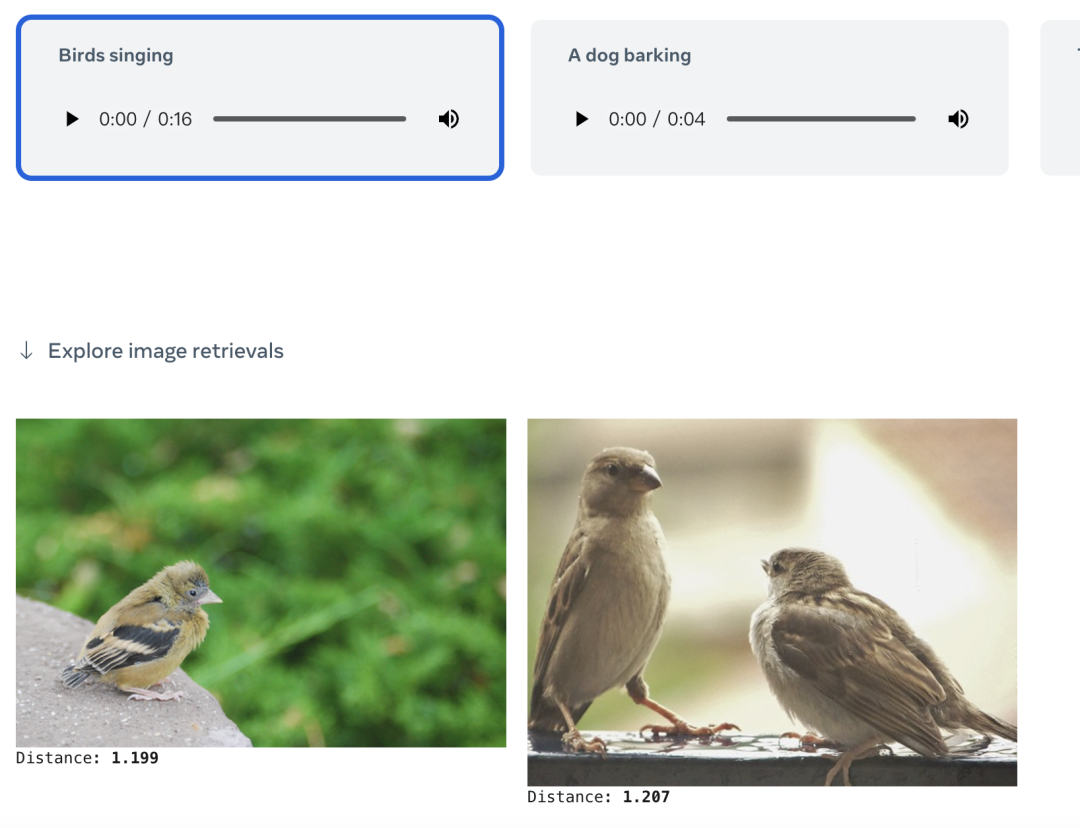

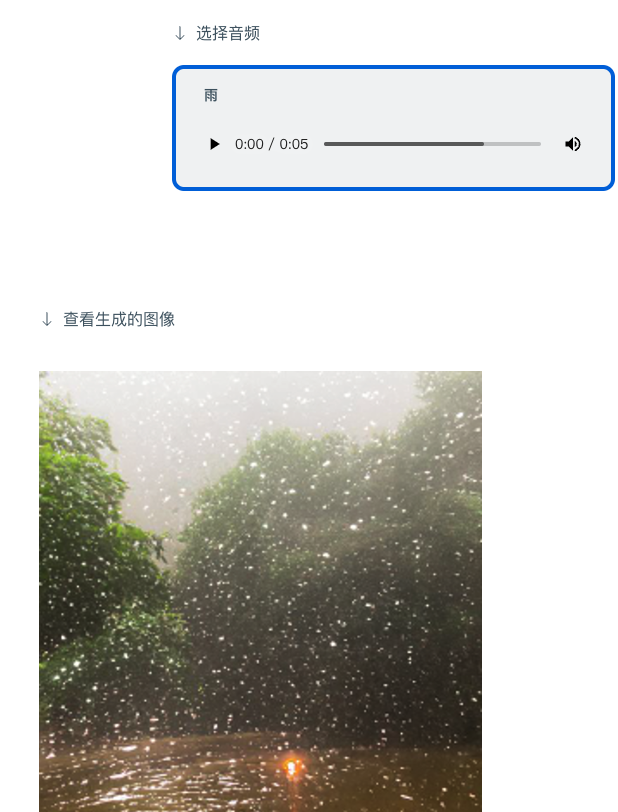

也可以音頻生成圖片:

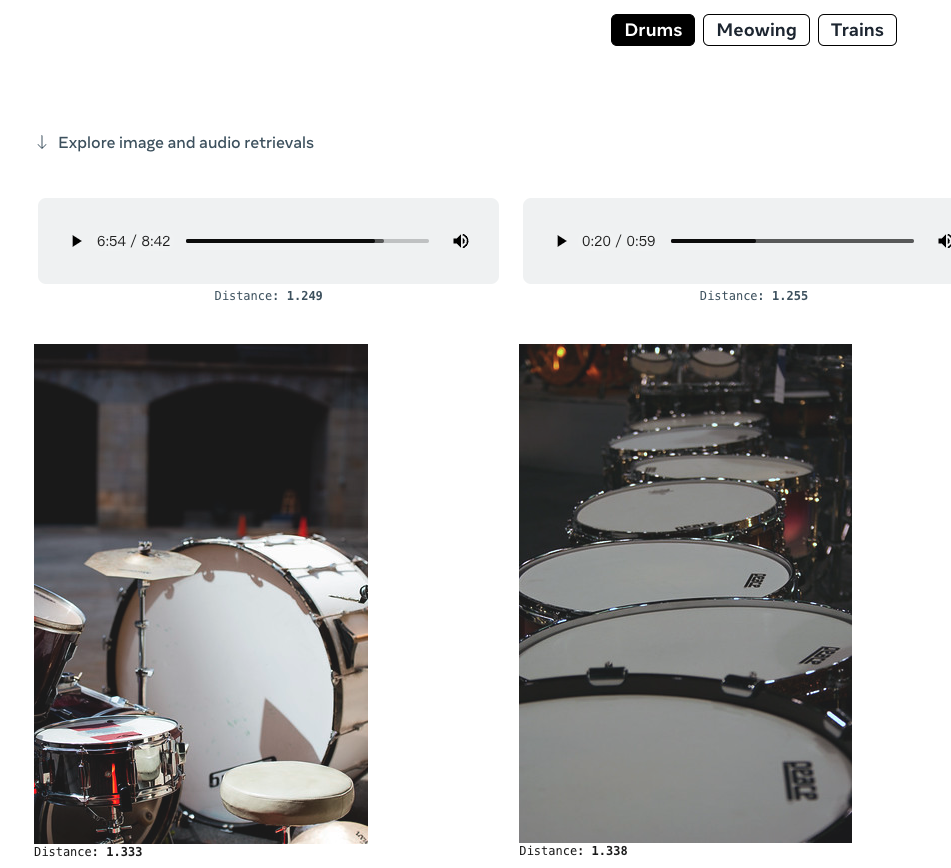

亦或者直接給一個(gè)文本,就可以檢索相關(guān)的圖片或者音頻內(nèi)容:

當(dāng)然,基于 ImageBind 也可以給出一個(gè)音頻+一張圖,如“狗叫聲”+海景圖:

可以直接得到一張“狗在看海”的圖:

也可以給出音頻,生成相應(yīng)的圖像:

正如上文所述, ImageBind 給出了未來(lái)生成式 AI 系統(tǒng)可以以多模態(tài)呈現(xiàn)的方式,同時(shí),結(jié)合 Meta 內(nèi)部的虛擬現(xiàn)實(shí)、混合現(xiàn)實(shí)和元宇宙等技術(shù)和場(chǎng)景結(jié)合。

可以想象一下未來(lái)的頭顯設(shè)備,它不僅可以生成音頻和視頻輸入,也可以生成物理舞臺(tái)上的環(huán)境和運(yùn)動(dòng),即可以動(dòng)態(tài)構(gòu)建 3D 場(chǎng)景(包括聲音、運(yùn)動(dòng)等)。

亦或者,虛擬游戲開(kāi)發(fā)人員也許最終可以使用它來(lái)減少設(shè)計(jì)過(guò)程中的大量跑腿工作。

同樣,內(nèi)容創(chuàng)作者可以?xún)H基于文本、圖像或音頻輸入制作具有逼真的音頻和動(dòng)作的沉浸式視頻。

也很容易想象,用 ImageBind 這樣的工具會(huì)在無(wú)障礙空間打開(kāi)新的大門(mén),譬如,生成實(shí)時(shí)多媒體描述來(lái)幫助有視力或聽(tīng)力障礙的人更好地感知他們的直接環(huán)境。

“在典型的人工智能系統(tǒng)中,每個(gè)模態(tài)都有特定的嵌入(即可以表示數(shù)據(jù)及其在機(jī)器學(xué)習(xí)中的關(guān)系的數(shù)字向量),”Meta 說(shuō)。“ImageBind 表明可以跨多種模態(tài)創(chuàng)建聯(lián)合嵌入空間,而無(wú)需使用每種不同模態(tài)組合對(duì)數(shù)據(jù)進(jìn)行訓(xùn)練。這很重要,因?yàn)檠芯咳藛T無(wú)法創(chuàng)建包含例如來(lái)自繁忙城市街道的音頻數(shù)據(jù)和熱數(shù)據(jù),或深度數(shù)據(jù)和海邊文本描述的樣本的數(shù)據(jù)集。”

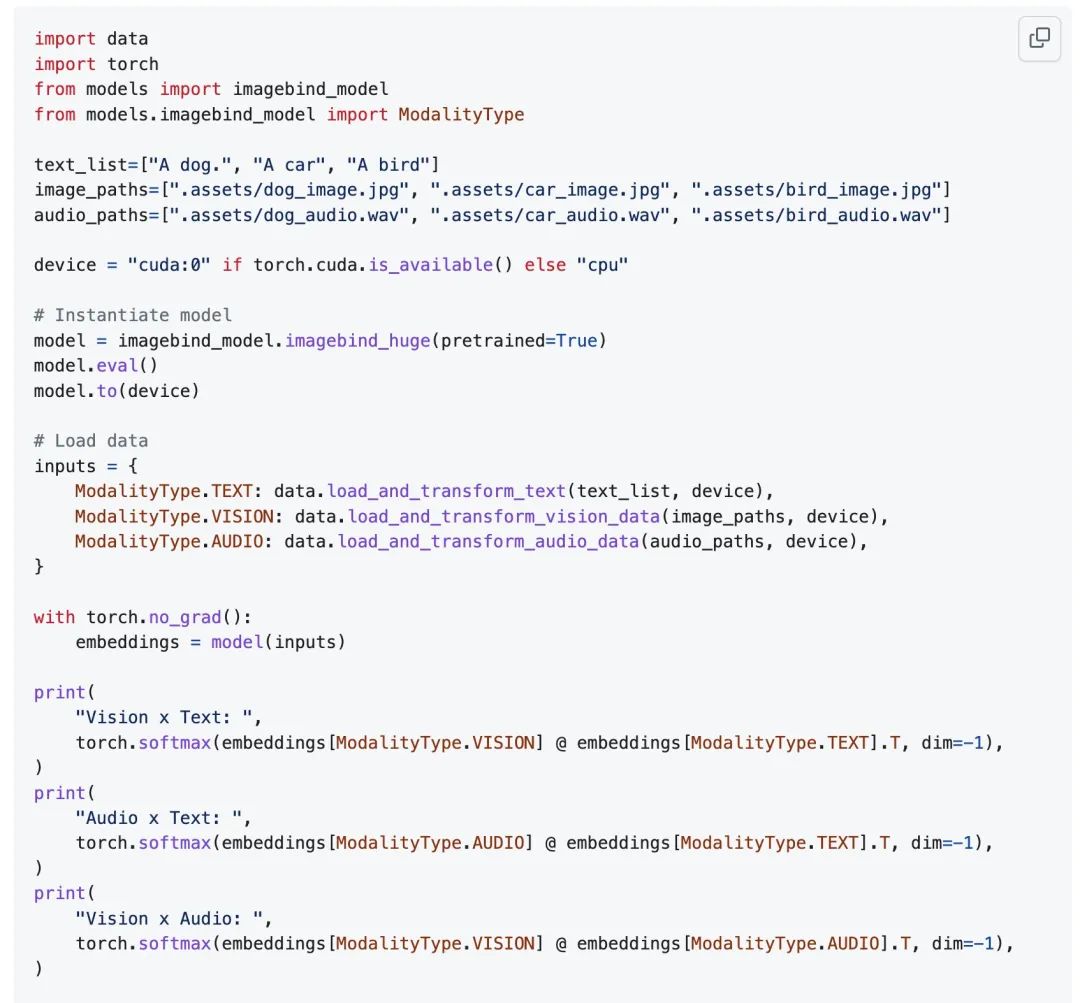

當(dāng)前,外界可以通過(guò)大約 30 行 Python 代碼就能使用這個(gè)多模式嵌入 API:

開(kāi)源大模型是好事還是壞事?

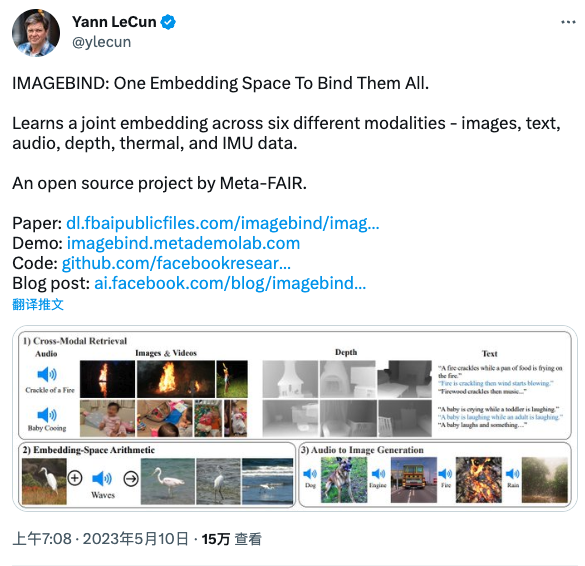

ImageBind 一經(jīng)官宣,也吸引了很多 AI 專(zhuān)家的關(guān)注。如卷積網(wǎng)絡(luò)之父 Yann LeCun 也在第一時(shí)間分享了關(guān)于 ImageBind 的資料:

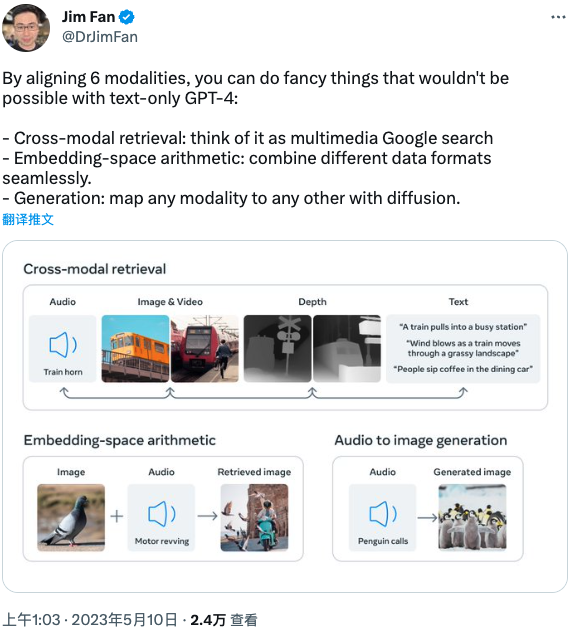

NVIDIA AI 科學(xué)家 Jim Fan 在 Twitter 上表示:

自從 LLaMA 以來(lái),Meta 就在開(kāi)源領(lǐng)域大放異彩。

ImageBind:Meta 最新的多模態(tài)嵌入,不僅涵蓋了常規(guī)數(shù)據(jù)類(lèi)型(文本、圖像、音頻),還包括深度、熱量(紅外)和 IMU 信號(hào)!

OpenAI Embedding 是 AI 驅(qū)動(dòng)搜索和長(zhǎng)期記憶的基礎(chǔ)。ImageBind 是 Meta 的 Embedding API,用于豐富的多媒體搜索、虛擬現(xiàn)實(shí)甚至機(jī)器人技術(shù)。元宇宙將建立在向量的基礎(chǔ)上。

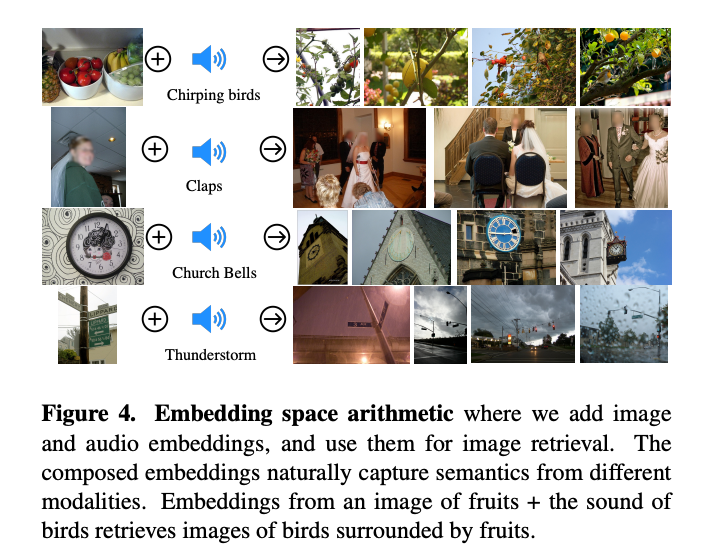

通過(guò)對(duì)齊 6 種模態(tài),你可以實(shí)現(xiàn)一些僅靠文本的 GPT-4 無(wú)法實(shí)現(xiàn)的花式功能:

跨模態(tài)檢索:將其視為多媒體谷歌搜索

嵌入空間算術(shù):無(wú)縫地組合不同的數(shù)據(jù)格式。

生成:通過(guò)擴(kuò)散將任何模態(tài)映射到其他任何模態(tài)。

當(dāng)然,這種通用的多模態(tài)嵌入在性能上優(yōu)于領(lǐng)域特定的特征。

ImageBind:將它們?nèi)拷壎ǖ揭粋€(gè)嵌入空間。

也有網(wǎng)友評(píng)價(jià)道,「這項(xiàng)創(chuàng)新為增強(qiáng)搜索、沉浸式 VR 體驗(yàn)和高級(jí)機(jī)器人技術(shù)鋪平了道路。對(duì)于 AI 愛(ài)好者和專(zhuān)業(yè)人士來(lái)說(shuō),激動(dòng)人心的時(shí)刻即將到來(lái)!」。

不過(guò),對(duì)于 Meta 采取開(kāi)源的做法,也有人提出了質(zhì)疑。

據(jù) The Verge 報(bào)道,那些反對(duì)開(kāi)源的人,如 OpenAI,表示這種做法對(duì)創(chuàng)作者有害,因?yàn)楦?jìng)爭(zhēng)對(duì)手可以復(fù)制他們的作品,并且可能具有潛在的危險(xiǎn),允許惡意行為者利用最先進(jìn)的人工智能模型。

與之形成對(duì)比的是,支持開(kāi)源的人則認(rèn)為,像 Meta 開(kāi)源 ImageBind 的做法有利于生態(tài)的快速建立與發(fā)展,也能集結(jié)全球的力量,幫助 AI 模型快速迭代和捕捉 Bug。

早些時(shí)候,Meta開(kāi)源的LLaMA 模型只能用于研究用途,但是期間LLaMA 模型在 4chan 上被泄露,有匿名用戶(hù)通過(guò) BT 種子公開(kāi)了 LLaMA-65B—— 有650 億個(gè)參數(shù)的 LLaMA,容量為 220GB。

隨著 LLaMA “被公開(kāi)”,一大批基于這款大模型的衍生品,號(hào)稱(chēng)是 ChatGPT 開(kāi)源替代品的工具在短時(shí)間內(nèi)快速涌現(xiàn),如跟著LLaMA(美洲駝)名字走的“駝?lì)悺奔易灏耍核固垢4髮W(xué)發(fā)布的Alpaca(羊駝,https://github.com/tatsu-lab/stanford_alpaca),伯克利、卡內(nèi)基梅隆大學(xué)等高校研究人員開(kāi)源的Vicuna(駱馬),還有基于 LLaMA 7B 的多語(yǔ)言指令跟隨語(yǔ)言模型 Guanaco(原駝,https://guanaco-model.github.io/)等等。

面對(duì)這股新興的力量,近日,在一位谷歌內(nèi)部的研究人員泄露的一份文件中顯示,在大模型時(shí)代,「Google 沒(méi)有護(hù)城河,OpenAI 也沒(méi)有」。其主要原因就是第三股——開(kāi)源大模型的力量與生態(tài)正在崛起。

所以,OpenAI 和 Google 兩家在 AI 大模型上你追我趕的競(jìng)爭(zhēng)中,誰(shuí)能笑到最后,也未必就不會(huì)是 Meta,我們也將拭目以待。對(duì)此,你是否看好開(kāi)源大模型的發(fā)展?

審核編輯 :李倩

-

開(kāi)源

+關(guān)注

關(guān)注

3文章

3406瀏覽量

42712 -

模型

+關(guān)注

關(guān)注

1文章

3307瀏覽量

49223 -

Meta

+關(guān)注

關(guān)注

0文章

283瀏覽量

11435

原文標(biāo)題:Meta 開(kāi)源 ImageBind 新模型,超越 GPT-4,對(duì)齊文本、音頻等 6 種模態(tài)!

文章出處:【微信號(hào):AI科技大本營(yíng),微信公眾號(hào):AI科技大本營(yíng)】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

Llama 3 與 GPT-4 比較

OpenAI推出新模型CriticGPT,用GPT-4自我糾錯(cuò)

國(guó)內(nèi)直聯(lián)使用ChatGPT 4.0 API Key使用和多模態(tài)GPT4o API調(diào)用開(kāi)發(fā)教程!

Meta開(kāi)源ImageBind新模型,超越GPT-4,對(duì)齊文本、音頻等6種模態(tài)!

Meta開(kāi)源ImageBind新模型,超越GPT-4,對(duì)齊文本、音頻等6種模態(tài)!

評(píng)論