5月31日(當地時間),openai宣布其開始對抗人工智能的“錯覺”,并采用新的方法來訓練人工智能模型。

據說,如果open ai開發的chatgpt和谷歌開發的bard等模型完全捏造信息,就像羅列事實一樣,顯示ai的“幻覺(hallucination)”。例如,在谷歌今年2月公開的bard宣傳視頻中,聊天機器人對詹姆斯-韋伯太空望遠鏡進行了虛假說明。chatgpt最近在紐約聯邦法院寫了一份引用虛假案件的文件,涉及此案的紐約律師可能會受到處罰。

目前,openai提出了一種新的方法——來緩解chatgpt中的“幻覺”,并讓激情變得更好,這是通過“過程監督”來提高大ai模型的數學推理能力。

openai研究組在報告書中表示:“最先進的模型也可能生成虛假信息——,有在不確定的瞬間捏造事實的傾向。”“這種幻想在需要多個層次推論的領域尤其有問題,因為邏輯錯誤可能會破壞更大的解決方案。”

openai對抗ai“幻覺”的新戰略不是單純地因為正確答案而給予補償,而是因為猜對正確的推理過程而給予補償。據研究者稱,這種方法被稱為“過程監測”,而不是“結果監測”。

這一策略也可能會導致更具描述性的人工智能,因為它鼓勵模型更多地遵循人類“思想”之類的方法鏈。除了結果監控以外,過程監控也有助于解決排序問題。

openai的研究人員還不知道這些結果是否適用于數學以外的領域,但他們認為在其他領域探索“過程監督”的影響也很重要。

-

模型

+關注

關注

1文章

3313瀏覽量

49231 -

聊天機器人

+關注

關注

0文章

343瀏覽量

12372 -

OpenAI

+關注

關注

9文章

1140瀏覽量

6707

發布評論請先 登錄

相關推薦

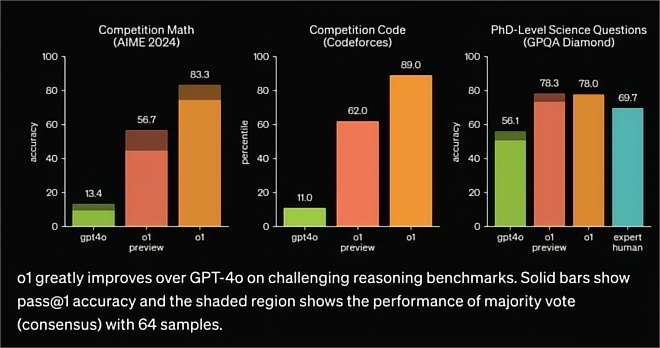

OpenAI發布o1大模型,數理化水平比肩人類博士,國產云端推理芯片的新藍海?

大華股份榮獲中國創新方法大賽一等獎

OpenAI暫不推出Sora視頻生成模型API

基于遺傳算法的QD-SOA設計新方法

一種降低VIO/VSLAM系統漂移的新方法

大華股份榮獲2024年中國創新方法大賽一等獎

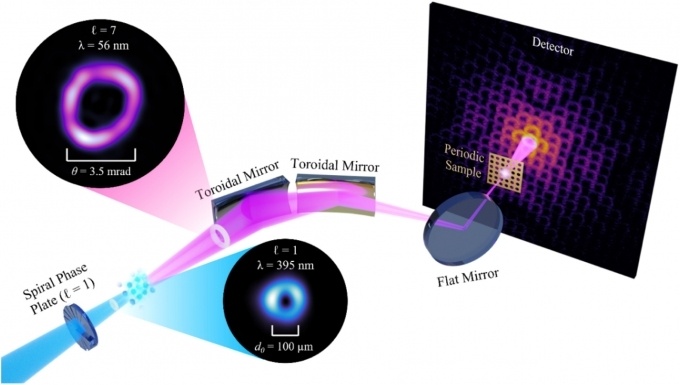

利用全息技術在硅晶圓內部制造納米結構的新方法

一種無透鏡成像的新方法

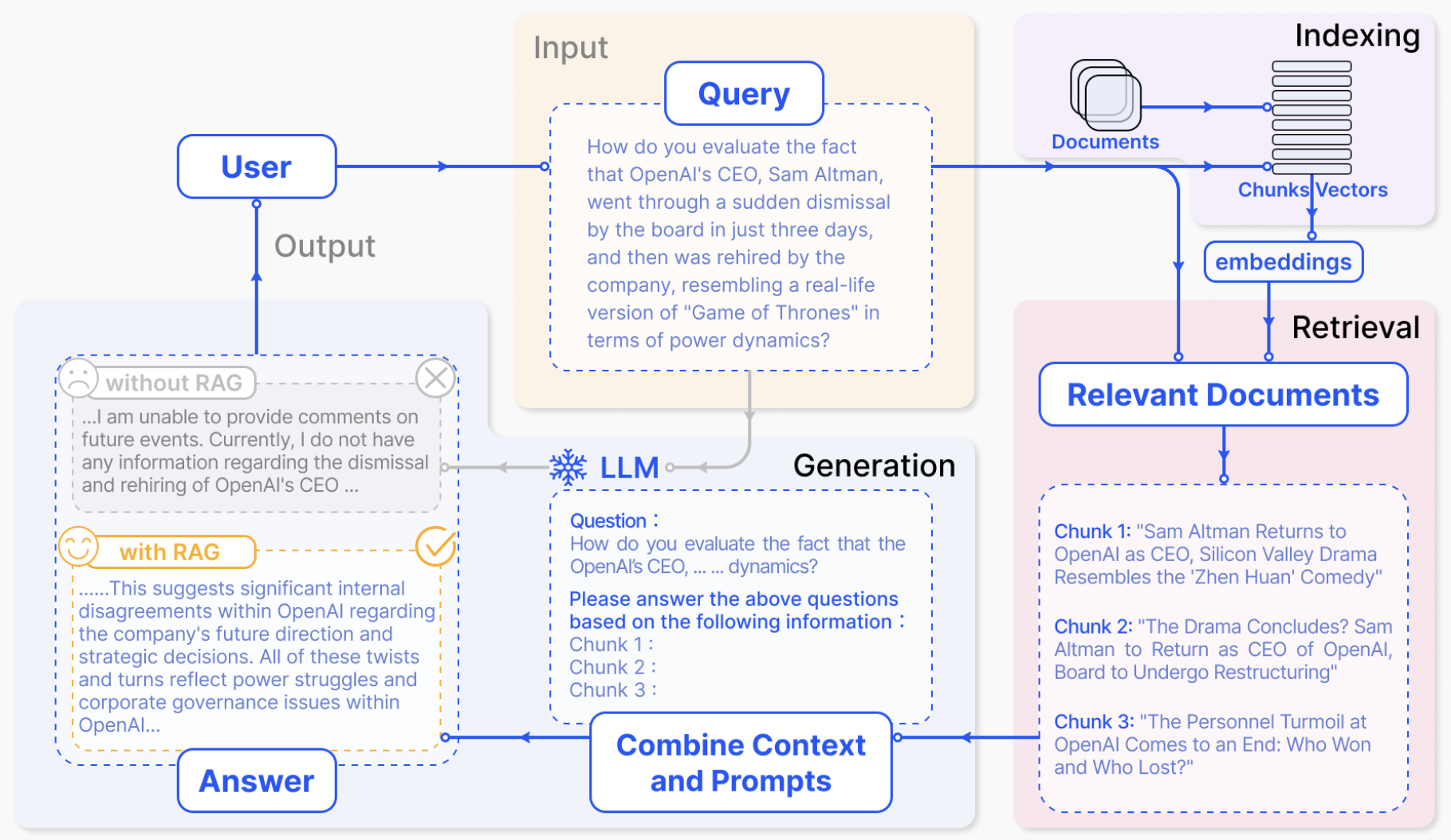

TaD+RAG-緩解大模型“幻覺”的組合新療法

阿里達摩院提出“知識鏈”框架,降低大模型幻覺

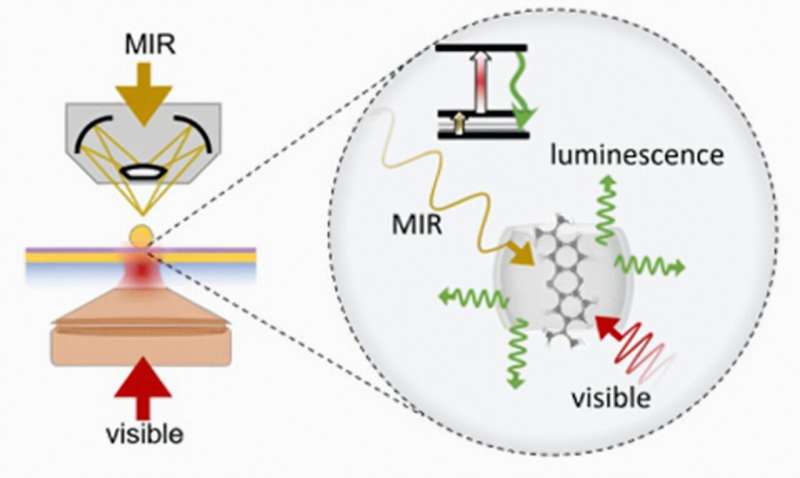

使隱形可見:新方法可在室溫下探測中紅外光

OpenAI稱找到新方法減輕大模型“幻覺”

OpenAI稱找到新方法減輕大模型“幻覺”

評論