LLaMA v.s. Falcon = 63.64 v.s. 49.08。評估結(jié)果表明,LLaMA 并未被「碾壓」。

作為開源模型界的扛把子,LLaMA 一直備受矚目。

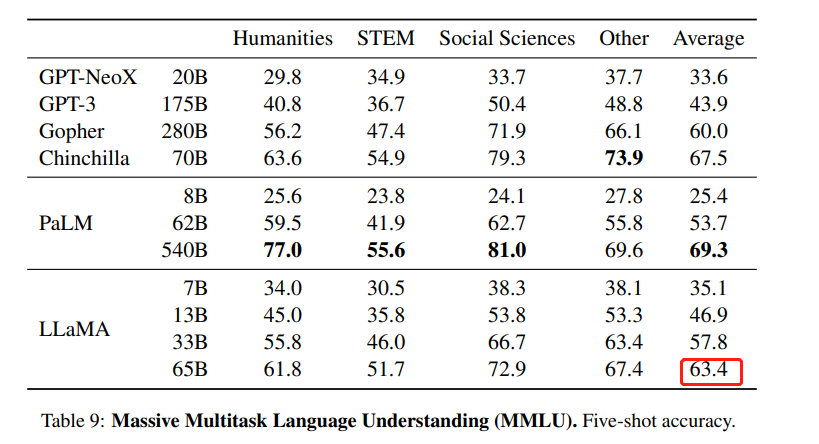

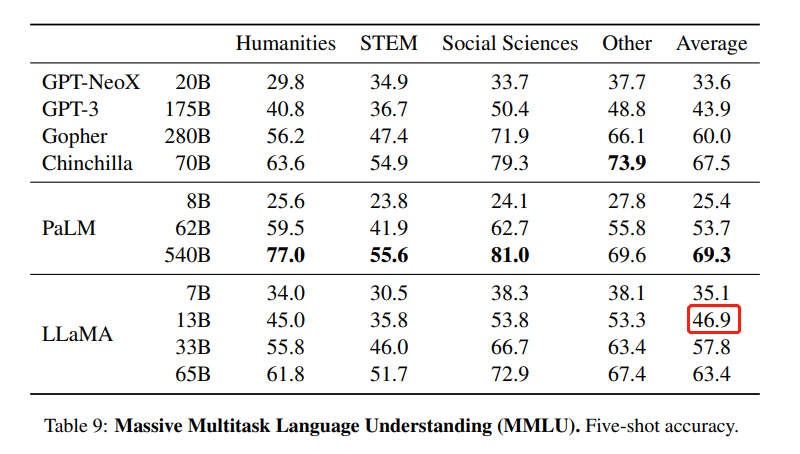

這是一組由 Meta 開源的大型語言模型,共有 7B、13B、33B、65B 四種版本。其中,LLaMA-13B 在大多數(shù)數(shù)據(jù)集上超過了 GPT-3(175B),LLaMA-65B 達(dá)到了和 Chinchilla-70B、PaLM-540B 相當(dāng)?shù)乃健?/p>

自 2 月份發(fā)布以來,開源社區(qū)一直在 LLaMA 的基礎(chǔ)上進(jìn)行二創(chuàng),先后推出了 Alpaca、Vicuna 等多個「羊駝」大模型,生物學(xué)羊駝屬的英文單詞都快被用光了。

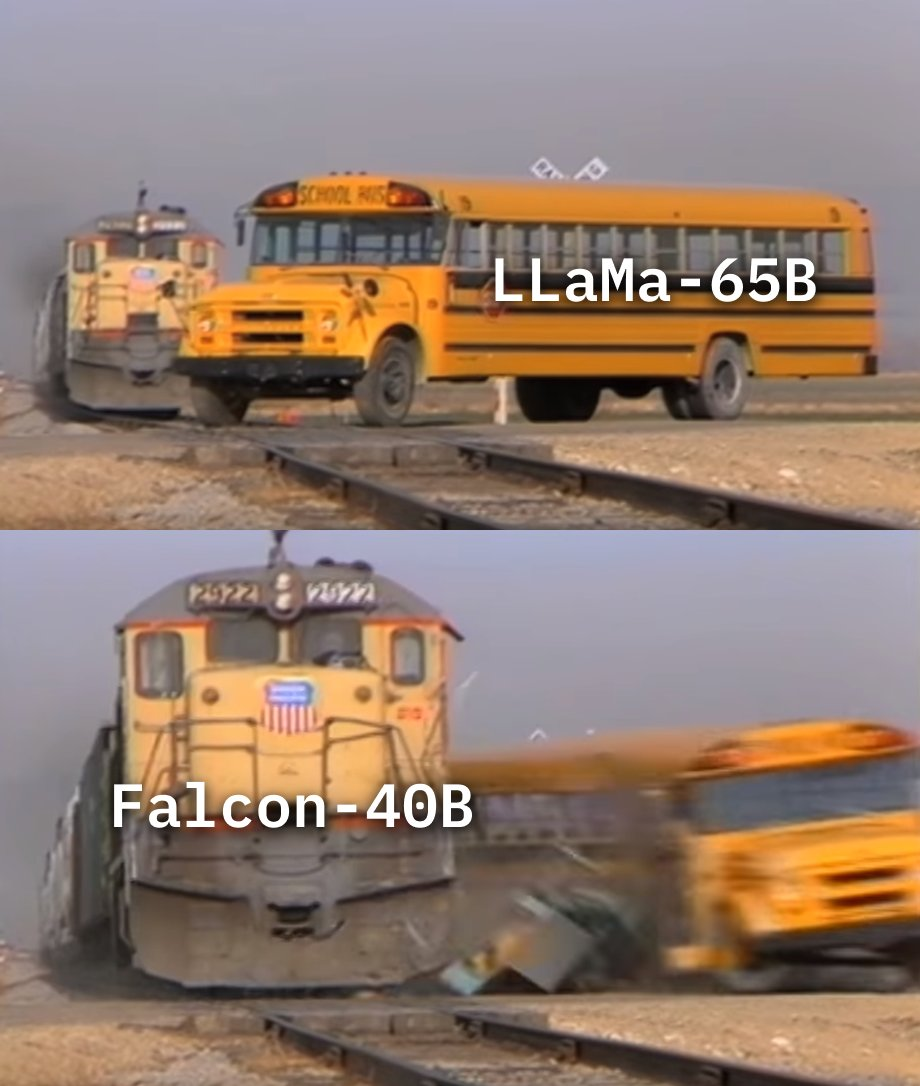

不過,也有人對 LLaMA 發(fā)起了挑戰(zhàn)。5 月底,阿聯(lián)酋阿布扎比的技術(shù)創(chuàng)新研究所(TII)開源了一個 400 億參數(shù)的因果解碼器模型「Falcon-40B」,該模型在 RefinedWeb 的 1 萬億個 token 上進(jìn)行了訓(xùn)練,并使用精選數(shù)據(jù)集增強。剛一發(fā)布,「Falcon-40B」就沖上了 Huggingface 的 OpenLLM 排行榜首位,「碾壓」了參數(shù)規(guī)模 1.5 倍的「LLaMA-65B」,也優(yōu)于 MPT、RedPajama 和 StableLM 等開源大模型。

后來,F(xiàn)alcon-40B Instruct 版本占據(jù)了排行榜首位,F(xiàn)alcon-40B 則退到了第三,而 LLaMA-65B 已經(jīng)掉到了第六位。

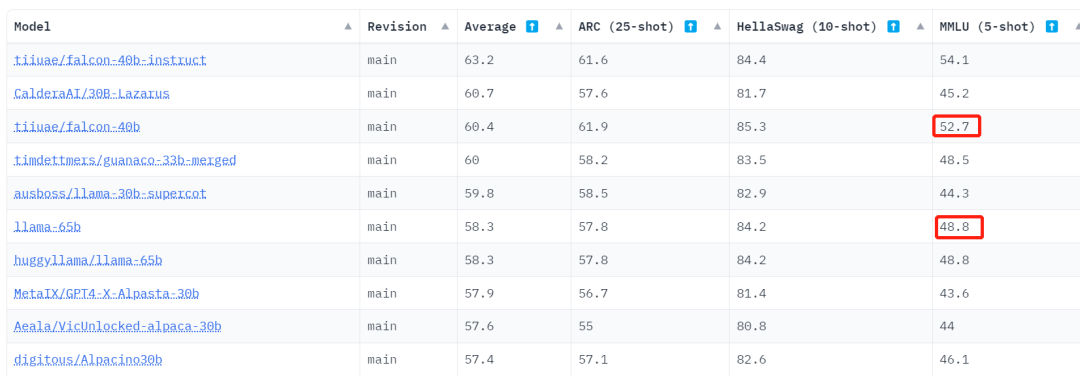

不過,仔細(xì)看過數(shù)據(jù)之后,圍觀者產(chǎn)生了疑問:為什么在 HuggingFace 的 Open LLM 排行榜上,LLaMA-65B 的 MMLU 這項分?jǐn)?shù)是 48.8,明顯低于官方數(shù)據(jù) 63.4?

HuggingFace 的 Open LLM 排行榜。地址:https://huggingface.co/spaces/HuggingFaceH4/open_llm_leaderboard

LLaMA 論文中的 MMLU 數(shù)據(jù)。MMLU 是 Massive Multitask Language Understanding 的縮寫,是一個基準(zhǔn)數(shù)據(jù)集,旨在通過僅在零樣本和少樣本設(shè)置下評估模型來衡量預(yù)訓(xùn)練期間獲取的知識。它由一系列學(xué)術(shù)科目中類似考試的問題組成,用于測試模型對于世界理解的能力。

還有人表示,在測 Falcon-40B 時,他們也復(fù)現(xiàn)不了排行榜上的分?jǐn)?shù)。

面對這樣的爭議,Karpathy 等大牛選擇了謹(jǐn)慎觀望。

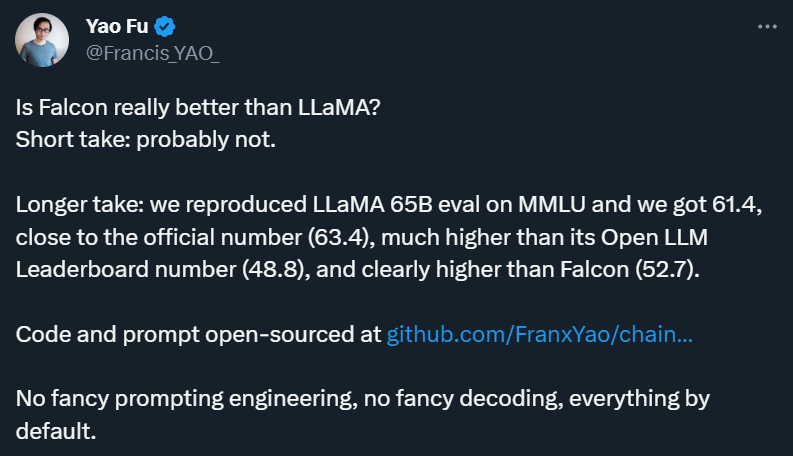

愛丁堡大學(xué)博士生符堯等則選擇自己測一遍。

簡而言之,他們在 Chain-of-thought Hub 上重新寫了開源的 LLaMA eval 代碼,然后在同樣的設(shè)定下,用官方 prompt,fp16,HF 默認(rèn)代碼,公平比較了 Falcon 和 LLaMA 在 MMLU 上的表現(xiàn)。

「沒有花哨的 prompt 工程和解碼,一切都是在默認(rèn)設(shè)置下進(jìn)行的。」符堯在推文中寫道。

6 月 8 日,他們公布了第一批結(jié)果:LLaMA 65B 的 MMLU 得分為 61.4,比較接近官方數(shù)字(63.4),明顯高于其 Open LLM Leaderboard 分?jǐn)?shù) 48.8,且遠(yuǎn)高于 Falcon-40B 的 Leaderboard 分?jǐn)?shù) 52.7。

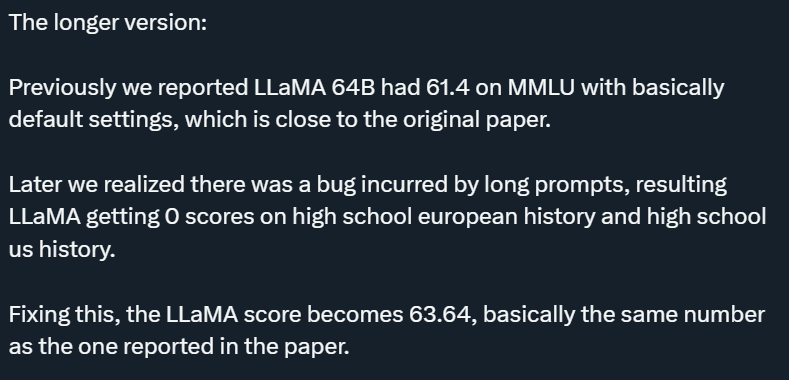

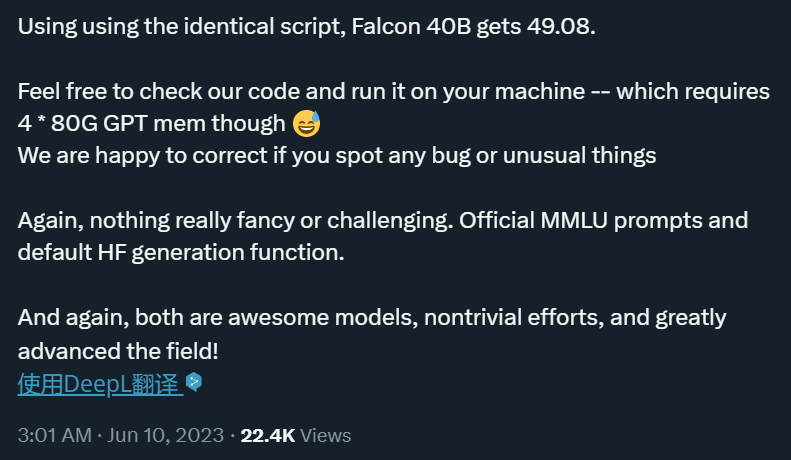

初步來看,「你大爺還是你大爺」。不過,這還不是 LLaMA 65B 的真實實力。在 6 月 10 日凌晨公布的第二波結(jié)果中,符堯解釋說,他們在第一波測評中發(fā)現(xiàn)了一個「long prompt」引起的 bug,這個 bug 導(dǎo)致 LLaMA 在高中歐洲歷史和高中美國歷史上得到 0 分。在修復(fù)了這個 bug 后,LLaMA 得分變成了 63.64,與論文中報道的數(shù)字基本相同。

公平起見,使用相同的腳本,他們也測出了 Falcon-40B 的得分:49.08,低于 Leaderboard 分?jǐn)?shù) 52.7,只比 LLaMA 13B 好一點。

由此,這次所謂的「碾壓」事件徹底反轉(zhuǎn)。

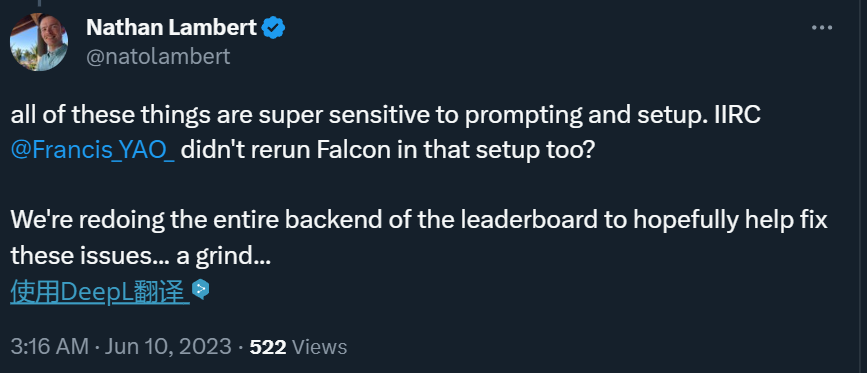

符堯團(tuán)隊的這一嘗試也吸引了 HuggingFace 研究科學(xué)家 Nathan Lambert 的注意,后者決定重寫 Open LLM Leaderboard 的代碼。

不過,符堯?qū)iT指出,他們不打算在 LLaMA 和 Falcon 之間挑起戰(zhàn)爭:「兩者都是偉大的開源模型,并為該領(lǐng)域做出了重大貢獻(xiàn)!Falcon 還具有更簡單的許可證優(yōu)勢,這也賦予了它強大的潛力!」

為了方便大家檢查代碼和開源結(jié)果,符堯公布了相關(guān)地址:https://github.com/FranxYao/chain-of-thought-hub/tree/main/MMLU

如果在檢查后有新的發(fā)現(xiàn),歡迎在評論區(qū)留言。

-

解碼器

+關(guān)注

關(guān)注

9文章

1148瀏覽量

40935 -

語言模型

+關(guān)注

關(guān)注

0文章

538瀏覽量

10341

原文標(biāo)題:徹底反轉(zhuǎn):號稱「碾壓」LLaMA的Falcon實測得分僅49.08,HuggingFace決定重寫排行榜代碼

文章出處:【微信號:CVSCHOOL,微信公眾號:OpenCV學(xué)堂】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

HarmonyOS開發(fā)案例:【排行榜頁面】

中國IC設(shè)計公司排行榜

2013年2月份編程軟件排行榜,LabVIEWTop27,進(jìn)步很大。

各種排行榜匯總貼!!!!!

2014年4月方案公司出貨量排行榜

2014年10月 TIOBE 編程語言排行榜發(fā)布

小米放出“手機(jī)電量排行榜” 為續(xù)航神機(jī)Max 2造勢

2020年最新主板型號排行榜 精選資料推薦

華為榮獲手機(jī)推薦度排行榜第一

小米斬獲2020年手機(jī)推薦度排行榜前三

開源大模型Falcon(獵鷹) 180B發(fā)布 1800億參數(shù)

號稱「碾壓」LLaMA的Falcon實測得分僅49.08,HuggingFace決定重寫排行榜代碼

號稱「碾壓」LLaMA的Falcon實測得分僅49.08,HuggingFace決定重寫排行榜代碼

評論