AI大佬隔空激辯,你支持誰?

????

“未來5年內(nèi),頭腦正常的人都不會再用自回歸LLM(大型語言模型),GPT系統(tǒng)將很快被拋棄。”

這是圖靈獎得主、Meta首席AI科學家、紐約大學教授Yann LeCun(楊立昆)在今年智源大會上發(fā)表的觀點。

今年以來,以ChatGPT為代表的AI大模型點亮了人類世界又一次群星閃耀的時刻。但顯而易見的是,AI大模型的快速躥紅,也同時帶來了無數(shù)亟待解決的問題和諸多針鋒相對的探討。

人類是否已經(jīng)進入AGI時代?GPT是否會被拋棄?開源與閉源到底如何選擇?AI是否已然威脅到人類安全?人和AI,誰是未來世界的主宰?

顛覆式創(chuàng)新往往伴隨巨大的不確定性。即使是專家們在今天發(fā)出的權(quán)威論斷,在若干年后也很可能變成技術(shù)長河中一個微小的“謬誤”。但盡管如此,當下的百家爭鳴依然有永恒的意義。

6月10日,第五屆北京智源大會閉幕。

北京智源大會由智源研究院主辦,今年邀請到了圖靈獎得主Geoffrey Hinton(杰弗里·辛頓)、Yann LeCun(楊立昆)、Joseph Sifakis、姚期智,張鈸、鄭南寧、謝曉亮、張宏江、張亞勤等院士,加州大學伯克利分校人工智能系統(tǒng)中心創(chuàng)始人Stuart Russell(斯圖爾特·羅素),麻省理工學院未來生命研究所創(chuàng)始人Max Tegmark(馬克斯·泰格馬克),OpenAI首席執(zhí)行官Sam Altman(薩姆·奧爾特曼)等200余位人工智能專家——如此群星璀璨的專家陣容,有人評價這場大會為“AI春晚”。

大會共持續(xù)了兩天,設(shè)置了十余場分論壇,內(nèi)容涵蓋前沿技術(shù)、生態(tài)、安全、倫理等方方面面。

不過,大會最奪人眼球的環(huán)節(jié)之一,還是杰弗里·辛頓、楊立昆、斯圖爾特·羅素、馬克斯·泰格馬克、薩姆·奧爾特曼等國際AI大咖的隔空辯論。大會期間,「甲子光年」參與了活動群訪,將最值得關(guān)注的4個核心爭議點進行了提煉總結(jié),盡可能還原全球AI領(lǐng)軍者們對AI當下與未來的深度思考。

1.GPT快要被拋棄了?

AI大模型出現(xiàn)后,一個隨之而來的問題是:世界是否已經(jīng)進入AGI時代?

王小川曾在今年2月便篤定地告訴「甲子光年」:“這(指ChatGPT)就是AGI!”這一判斷的核心邏輯是,ChatGPT背后的大模型掌握了語言,而語言的邊界就是世界的邊界,機器掌握了語言,就意味著AGI的到來。

但就在本次智源大會上,ChatGPT神話的締造者、OpenAI CEO薩姆·奧爾特曼則表示,自己并不確定AGI何時到來,但他認為10年內(nèi),人類可能會迎來更強大的AI系統(tǒng)。

之所以業(yè)內(nèi)有如此巨大的分歧,是因為AGI目前并沒有明確定義。

在本屆智源大會上,智源研究院院長黃鐵軍表示,“通用人工智能”有兩個解釋,GAI(General Artficaial Intelligence)和AGI(Artificial General Intelligence)。他認為,大多數(shù)媒體都將通用人工智能理解為前者,而真正讓人工智能研究者談?wù)摂?shù)年的是AGI,世界正處于由GAI向AGI邁進的歷史時期。

要實現(xiàn)AGI,究竟需要什么樣的技術(shù)條件?

黃鐵軍總結(jié)了三條實現(xiàn)AGI的技術(shù)路線:

大數(shù)據(jù)+自監(jiān)督學習+大算力形成的信息類模型,以O(shè)penAI的GPT系列模型為代表;

?

基于虛擬或真實世界,通過強化學習訓練出來的具身模型,以Google DeepMind的DQN深度學習技術(shù)為代表;

直接抄自然進化的作業(yè),復制數(shù)字版本的人腦和智能體,即腦智能。這是智源研究院一直在嘗試的方向。

目前,智源研究院在上述三個方向均有布局。會上,黃鐵軍著重介紹了大模型與具身智能兩個方向,發(fā)布了全面開源的“悟道3.0”系列大模型及算法,報告了在高精度生命模擬和有機大分子建模方面的最新進展。

在2021年3月,悟道1.0發(fā)布會上,智源研判人工智能已經(jīng)從“大煉模型”轉(zhuǎn)變?yōu)椤盁挻竽P汀钡男码A段,從此,“大模型”概念走入公眾視野。

黃鐵軍提出了大模型需要具備的三個條件:一是規(guī)模要大,參數(shù)達百億規(guī)模以上;二是涌現(xiàn)性,能夠產(chǎn)生預料之外的新能力;三是通用性,不限于專門問題或領(lǐng)域,能夠處理多種不同的任務(wù)。

悟道系列模型已發(fā)展到“悟道3.0”版本,涵蓋語言、視覺、多模態(tài)等基礎(chǔ)大模型,并全面開源。

在攻關(guān)大模型的同時,智源研究院也在探索具身智能。近期,智源研究院提出了在無專家數(shù)據(jù)情況下高效解決《我的世界》任務(wù)的方法Plan4MC,可完成大量復雜多樣任務(wù),為當前強化學習路徑下最優(yōu)表現(xiàn),成功率相比所有基線方法有大幅提升。智源的下一個目標則是讓智能體在開放世界中持續(xù)學習并進一步具備創(chuàng)造力。

針對第三條路徑,智源研究院也有新進展。

去年的智源大會上,智源研究院發(fā)布了最高精度的仿真線蟲。現(xiàn)在,智源開放仿真線蟲研究所使用的“天演”平臺,提供在線服務(wù)。

基于天演平臺,實現(xiàn)對生物智能進行高精度仿真,探索智能的本質(zhì),推動由生物啟發(fā)的通用人工智能。為進一步推動神經(jīng)系統(tǒng)仿真規(guī)模與性能,天演團隊將天演接入我國新一代百億億次超級計算機-天河新一代超級計算機。通過“天演-天河”的成功部署運行,實現(xiàn)鼠腦V1視皮層精細網(wǎng)絡(luò)等模型仿真,計算能耗均能降低約10倍以上,計算速度實現(xiàn)10倍以上提升,達到全球范圍內(nèi)最極致的精細神經(jīng)元網(wǎng)絡(luò)仿真的性能,為實現(xiàn)全人腦精細模擬打下堅實基礎(chǔ)。

除智源的三條路徑之外,圖靈獎得主、Meta首席AI科學家、紐約大學教授楊立昆也在會上系統(tǒng)闡述了他提出的“世界模型”。

在楊立昆看來,幾十年來,研究者一直在使用監(jiān)督學習,這需要太多的標簽。強化學習效果不錯,但需要大量的訓練來學習知識。近年來,研究者一直在使用大量的自我監(jiān)督學習,但這些系統(tǒng)在某個地方不太專業(yè),而且很脆弱,它們會犯愚蠢的錯誤,它們不會真正地推理,也不會計劃。當然,它們的反應確實非常快。

相比之下,動物和人類可以快速執(zhí)行新任務(wù)并理解世界是如何運作的,也可以推理和計劃、具有常識,這是機器所不具備的。

他甚至不留情面地說,未來5年內(nèi),頭腦正常的人都不會再用自回歸LLM(大型語言模型),GPT系統(tǒng)將很快被拋棄。“這些系統(tǒng)沒有物理世界的經(jīng)驗,這使得它們(的能力)非常有限。”楊立昆表示。

楊立昆認為,人類最終走向的將是“世界模型”。世界模型可以真正地理解這個世界,并預測和規(guī)劃未來。通過成本核算模塊,結(jié)合一個簡單的需求(一定按照最節(jié)約行動成本的邏輯去規(guī)劃未來),它就可以杜絕一切潛在的毒害和不可靠性。

那么,我們?nèi)绾螐谋举|(zhì)上理解世界模型?

楊立昆提出了一個分層系統(tǒng)的設(shè)想:通過一連串的編碼器,提取世界狀態(tài)的更多抽象表示,并使用不同層次預測器的世界模型,在不同的擾動水平、不同的時間尺度下預測世界的狀態(tài)。

一個簡單的例子是,如果你想從紐約去北京,你需要做的第一件事就是去機場,然后坐飛機去北京。這個過程可以拆分為若干動作,例如你從紐約辦公室的椅子上站起來,出門,到街上去攔一輛出租車,并告訴司機你要去機場等等——所有復雜的任務(wù)都是以某種分層規(guī)劃的方式完成的。

不過,楊立昆也承認,目前還沒人知道如何規(guī)模化實現(xiàn)這種分層規(guī)劃的體系。

2.開源與閉源:一場信仰與現(xiàn)實的較量

盡管技術(shù)邊界無窮無盡,但一個擺在人們眼前的現(xiàn)實問題更不容忽視——正在快速形成的大模型生態(tài)應該開源還是閉源?

回看整個計算機技術(shù)發(fā)展史,很難分辨開源、閉源生態(tài)究竟孰優(yōu)孰劣。

在PC時代,有封閉的Wintel聯(lián)盟和開放的Linux,今天,Linux幾乎成為所有操作系統(tǒng)的內(nèi)核;移動互聯(lián)時代,iOS的封閉生態(tài)與安卓的開放生態(tài)雙足鼎立。

如今到了智能時代,未來的大模型之爭也難逃生態(tài)之爭。

從國外看,LLaMA發(fā)布后,在全球派生出的模型不計其數(shù),已經(jīng)形成了龐大的生態(tài)。但智源研究院副院長、總工程師林詠華在訪談時對「甲子光年」等媒體表示,這種生態(tài)對中國的企業(yè)和開發(fā)者并不友好。

首先,LLaMA的開源生態(tài)無法商用;其次,LLaMA的語料主要來自國外,由此帶來的部分和中文語境不適配的問題會被繼承在基于LLaMA訓練的模型中。

為此,智源研究院搭建了一套更適用于國內(nèi)的開源生態(tài)體系。

今年年初,智源發(fā)布了FlagOpen大模型技術(shù)開源體系;數(shù)據(jù)集方面,智源已開源首個大規(guī)模、可商用的中文指令數(shù)據(jù)集COIG。COIG一期已開放總計19.1萬條指令數(shù)據(jù),COIG二期正在建設(shè)最大規(guī)模、持續(xù)更新的中文多任務(wù)指令數(shù)據(jù)集,整合了1800多個海量開源數(shù)據(jù)集,人工改寫了3.9億條指令數(shù)據(jù),并提供了配套的數(shù)據(jù)篩選、版本控制工具。

事實上,開源和閉源的選擇背后,是一場信仰與現(xiàn)實的較量。

對于很多人而言,開源是一個原則問題。開源社區(qū)Hugging Face聯(lián)合創(chuàng)始人Julien Chaumond曾在推特上寫道:“我們永遠不會放棄為開源人工智能而戰(zhàn)。”

智源研究院也是開源生態(tài)堅定的擁躉。“如果沒有開源,AI不會發(fā)展到今天。”林詠華表示。

不過,在林詠華看來,開源和閉源沒有對錯之分,更多取決于主體自身性質(zhì)和訴求。國內(nèi)大廠作為商業(yè)機構(gòu),投入了大量成本訓練模型,這也決定了他們需要考慮如何讓投資有回報的問題;而智源作為政府支持的非營利組織,主要訴求是對產(chǎn)業(yè)產(chǎn)生更多的技術(shù)影響,這決定了智源追求開源,尤其是可商用的開源生態(tài)。

只是,相比以商業(yè)目標為主導的閉源生態(tài),開源系統(tǒng)還有更強的公共意義。

在封閉生態(tài)下,大企業(yè)很容易形成壟斷,甚至演變?yōu)榧夹g(shù)霸權(quán)。當一項影響全人類命運的技術(shù)僅僅掌握在少數(shù)商業(yè)主體手中,世界都將陷入巨大的不穩(wěn)定性中。開源則能在一定程度上避免技術(shù)霸權(quán)。

但開源也會然意味著谷歌、OpenAI等提供開源內(nèi)核的企業(yè)在巨大的技術(shù)投入后很難得到相應的回報,甚至讓企業(yè)生存難以為繼。

眾所周知,OpenAI也曾為開源而生。但從GPT-3開始,OpenAI便停止開放模型源代碼;到GPT-4,更是連最基本的模型參數(shù)都沒公布。

會上,張宏江將未來是否會開源的問題拋向奧爾特曼,而奧爾特曼卻打起了“太極”:“隨著時間的推移,我認為我們可能會期待更多的開源模型,但我沒有具體的時間表。”奧爾特曼進一步表示,開源一切并不是最優(yōu)路徑。

曾有人推測認為OpenAI走向“CloseAI”是因為其背后綁定了巨頭微軟,必須考慮商業(yè)回報。不過,在OpenAI的官方口徑中,閉源是出于安全考慮。

過去一段時間,奧爾特曼像一位AI安全的“布道者”,不斷呼吁全球各界人士重視AI安全。這一次也不例外。

3.控制AI是否為時尚早?

關(guān)于人類究竟應不應該盡早控制AI的問題,專家們也始終爭執(zhí)不下。

一邊是以楊立昆為代表的樂觀派。

在他看來,超級人工智能確實存在安全風險,對此,各界可以通過謹慎的工程設(shè)計來減輕或遏制風險。但問題在于,目前人類并沒有真正設(shè)計出超級智能系統(tǒng),談?wù)摪踩蚩刂茊栴}有些為時過早。

楊立昆舉了一個生動的例子:“這就好像你在1930年問航空工程師‘如何讓渦輪噴氣式飛機安全可靠’?工程師會說‘什么是渦輪噴氣式飛機’?因為渦輪噴氣發(fā)動機在1930年還沒有被發(fā)明。”

另一邊,則是以奧爾特曼、泰格馬克、辛頓等為代表的謹慎派。

“千里之行,始于足下。”在“AI安全與對齊”的分論壇上,奧爾特曼引用了《道德經(jīng)》中的一句話,來呼吁全球盡早邁出AGI治理最有建設(shè)性的第一步。

奧爾特曼表示,人工智能系統(tǒng)正在越來越強大,如果人類不做好規(guī)劃,一個原本設(shè)計用來改善公共衛(wèi)生的AI系統(tǒng)很可能提供破壞公共衛(wèi)生的建議;一個原本用來優(yōu)化農(nóng)業(yè)實踐的人工智能系統(tǒng)可能會無意中損害經(jīng)濟和資源的消耗,缺乏對長期可持續(xù)性的考慮,從而影響食物生產(chǎn)和環(huán)境平衡。

因此,推進AGI安全是全球?qū)ふ夜餐鲎钪匾念I(lǐng)域之一。首先,各國應共同建立包容的國際準則和標準,并在所有國家對AGI的使用中建立平等、統(tǒng)一的防護措施。其次,建立國際合作,以可驗證的方式在全球范圍內(nèi)建立對越來越強大的AGI系統(tǒng)安全開發(fā)的信任。

而在更具體的操作層面,“對齊”則是很重要的一步。

奧爾特曼表示,從GPT-4完成預訓練到部署,OpenAI花了八個月來研究如何前置預判風險并給出對策的問題。“GPT-4的對齊程度超過當前所有的代碼。”

他進一步表示,對于更高級的系統(tǒng),對齊仍然是一個尚未解決的問題。未來的AGI可能是一個十萬行二進制代碼的系統(tǒng),人類很難判斷如此規(guī)模的模型是否在做一些損害人類社會的事情。因此,我們需要新的技術(shù)方法,并加強治理監(jiān)督。

奧爾特曼透露了兩個正在投資新的方向:

一個是可擴展的監(jiān)督,嘗試使用AI系統(tǒng)來協(xié)助人類監(jiān)督其他AI系統(tǒng)。例如,訓練一個模型來幫助人類監(jiān)督員找出其他模型代碼中的缺陷。

一個是可解釋性。我們希望更好地理解模型內(nèi)部發(fā)生的事情,我們最近發(fā)表了一篇論文,使用GPT-4來解釋計算機的復雜狀態(tài)。

麻省理工學院未來生命研究所創(chuàng)始人馬克斯·泰格馬克的觀點和奧爾特曼有異曲同工之妙。

在主題為《Keeping AI under control》的演講中,泰格馬克表示,要確保AI為人類服務(wù)而不是和人類作對,需要解決兩大問題:

首先是對齊,讓單個AI真正按照其所有者的意愿行事。其次,是如何讓世界各地所有組織、公司、個人等保持一致,確保他們用AI來做正確的事。

在這次分享中,泰格馬克主要圍繞前者展開討論。其中,讓機器具有可解釋性是關(guān)鍵。他將讓機器實現(xiàn)可解釋性分為三個層面:

首先,判斷機器的可信度。例如人在開車時并不明白剎車的工作原理,但人們會相信踩下剎車板車就會慢下來。

其次,更好地理解機器,這會讓機器更值得被信賴。

最后,也是泰格馬克本人的志向,就是提取機器學習黑匣子中的所有知識,并將其在其他系統(tǒng)中復現(xiàn),便能夠證明機器會按照人類的意愿做事。

泰格馬克用一些例子來解釋了最后一點,其中一個例子還反駁了楊立昆對自回歸模型中缺乏世界模型的批評。

他引用了一篇論文內(nèi)容,其中提到,研究者訓練了一個transformer模型來預測奧賽羅游戲(一種比圍棋簡單得多的棋盤游戲)的下一個動作,他們并未告訴模型任何游戲規(guī)則,甚至沒讓模型知道這是一個棋類游戲。但機器的可解釋性發(fā)現(xiàn),模型自己建立了一個8x8的二維世界模型,棋盤上還有棋子。

泰格馬克表示,這種能力也存在于其他大型語言模型中,例如人們在使用百度的文心一言或GPT-4時,會發(fā)現(xiàn)它們能夠為不同的人建模,按照使用者的風格輸出內(nèi)容。

智源研究院院長黃鐵軍也對「甲子光年」等媒體發(fā)表了自己的看法,強調(diào)了關(guān)注AI安全,應對AI風險的重要性。

黃鐵軍認為,目前,我們處在一個模糊的階段,他將其稱之為“Near AGI”,任何事情只要確定都是可以把控的,就怕不能確定。而今天,我們就處在一個不能確定的狀態(tài)。

“雖然我們認為GPT-4還不算真正的AGI,但是其知識儲備量和融會貫通的能力已經(jīng)很強。這樣的‘Near AGI’比我們強嗎?超過我們的智能了嗎?今天論壇的所有嘉賓在報告中都沒有給大家一個確定的答案。并沒有明確說‘NO’‘放心’‘今天的AI系統(tǒng)還不如人類強大呢’。這就是問題所在”,黃鐵軍表示,“我們并不清楚地知道人工智能是不是已經(jīng)超過我們,不知道它何時會超過我們,該問題處在一個完全無法把控的狀態(tài)。如果我們能夠像投資熱情那樣投入來應對風險,至少還有一定把握未來的可能。但是,你相信人類能做到嗎?我不知道”。

4.人類和AI,誰是未來世界的主宰?

大佬們之所以如此關(guān)注AI安全,核心是因為人工智能的發(fā)展趨勢將直接影響到全人類的未來命運。

有關(guān)AI顛覆人類的科幻故事不勝枚舉,甚至有不少人談“AI”色變。無論專家、從業(yè)者還是普通公眾,都迫切地想要知道:如果智能體比人類更聰明,世界會發(fā)生什么?

圖靈獎得主、“深度學習之父”杰弗里·辛頓在閉幕演講中提到,超級智能可能會比預想中發(fā)生得更快。

不良分子可能會利用超級智能體操縱選舉等活動。在美國和其他許多地方,他們已經(jīng)在利用它們進行這些活動,甚至可能會用于贏得戰(zhàn)爭。

如果要讓數(shù)字智能更高效,人們需要允許智能體制定一些目標,而智能體實現(xiàn)這些目標的大前提是擁有更多的控制權(quán)。辛頓認為,目前很難想象人類該如何阻止數(shù)字智能為了實現(xiàn)更多目的而獲取更多控制權(quán)。

一旦數(shù)字智能開始追求更多控制權(quán),人類可能會面臨更多問題。比如,在物理隔絕的情況下,超級智能物種仍然可以通過控制人類來輕易獲得更多的權(quán)限。

在辛頓的觀察中,這類人工智能已經(jīng)熟練掌握了欺騙人類的動作。它可以通過閱讀小說,來學習欺騙他人的方式,而一旦人工智能具備“欺騙”的能力,也就具備輕易控制人類的能力。

例如,如果超級智能體想入侵華盛頓的一座建筑,它不需要親自去那里,只需要欺騙人們,讓他們自認為通過入侵該建筑物,就能拯救民主,最終實現(xiàn)目的。

現(xiàn)實世界中,也已經(jīng)出現(xiàn)了AI欺騙人類的先例。

據(jù)美聯(lián)社報道,6月9日,一名從業(yè)30年的紐約律師在其提交的法庭文件中使用了ChatGPT提供的案例,而這些案例中很多都是ChatGPT杜撰的,這導致這名律師面臨紀律聽證會,甚至可能面臨處罰。

“這種操作令人感到害怕,因為我也不知道如何阻止這樣的行為發(fā)生。”辛頓擔憂道。

辛頓呼吁,希望年輕一代的研究人員可以找出一些更智能的辦法,來阻止超級智能體通過欺騙來控制人類的行為。

或許,人類的微弱優(yōu)勢是,這些智能物種都是由人類打造的,而非自然進化的產(chǎn)物,也正因如此,它們可能不具備人類會競爭、有攻擊性等特點。

為此,人類可以嘗試賦予人工智能一些倫理原則。但一個更讓人毛骨悚然的隱憂是,古往今來,主宰世界的往往是智能水平更高的物種。

在演講最后,辛頓留下了一則寓言式的警示:

“假設(shè)青蛙創(chuàng)造了人類,你認為現(xiàn)在誰會占據(jù)主動權(quán),是人,還是青蛙?”

-

AI

+關(guān)注

關(guān)注

87文章

31536瀏覽量

270354 -

ChatGPT

+關(guān)注

關(guān)注

29文章

1570瀏覽量

8067 -

大模型

+關(guān)注

關(guān)注

2文章

2551瀏覽量

3174

原文標題:實現(xiàn)AGI之前,全球AI大佬在這4個關(guān)鍵問題上吵起來了|甲子光年

文章出處:【微信號:jazzyear,微信公眾號:甲子光年】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

因為英文Datasheet,工程師又吵起來了

字節(jié)跳動啟動AGI長期研究計劃Seed Edge

奧特曼否認OpenAI下月部署AGI

阿爾特曼:OpenAI將率先實現(xiàn)AGI

OpenAI公布2025年目標,AGI位列首位

高級顧問宣布離職!OpenAI解散“AGI籌備”團隊

安全政策遭質(zhì)疑 OpenAI解散AGI團隊

求救大佬,有沒有大佬知道這個B772在這個電路里面是什么作用的

談?wù)剟?chuàng)意設(shè)計中的AI、AGI、AIGC

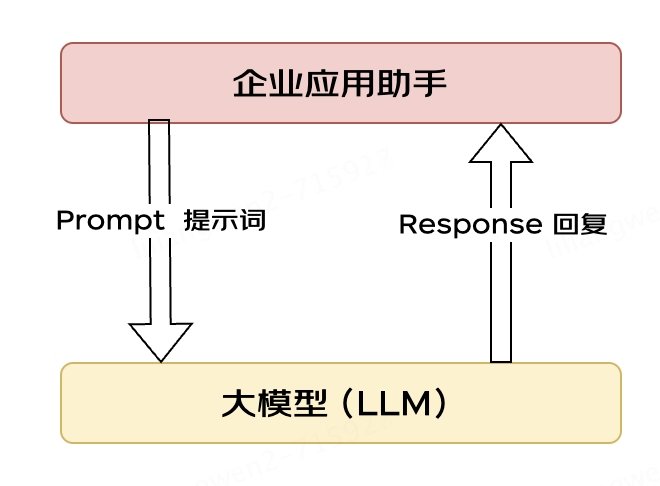

大模型應用之路:從提示詞到通用人工智能(AGI)

芯原NPU全球累積出貨超1億顆,應用領(lǐng)域涵蓋AI視覺、AI語音、AI圖象

實現(xiàn)AGI之前,全球AI大佬在這4個關(guān)鍵問題上吵起來了

實現(xiàn)AGI之前,全球AI大佬在這4個關(guān)鍵問題上吵起來了

評論