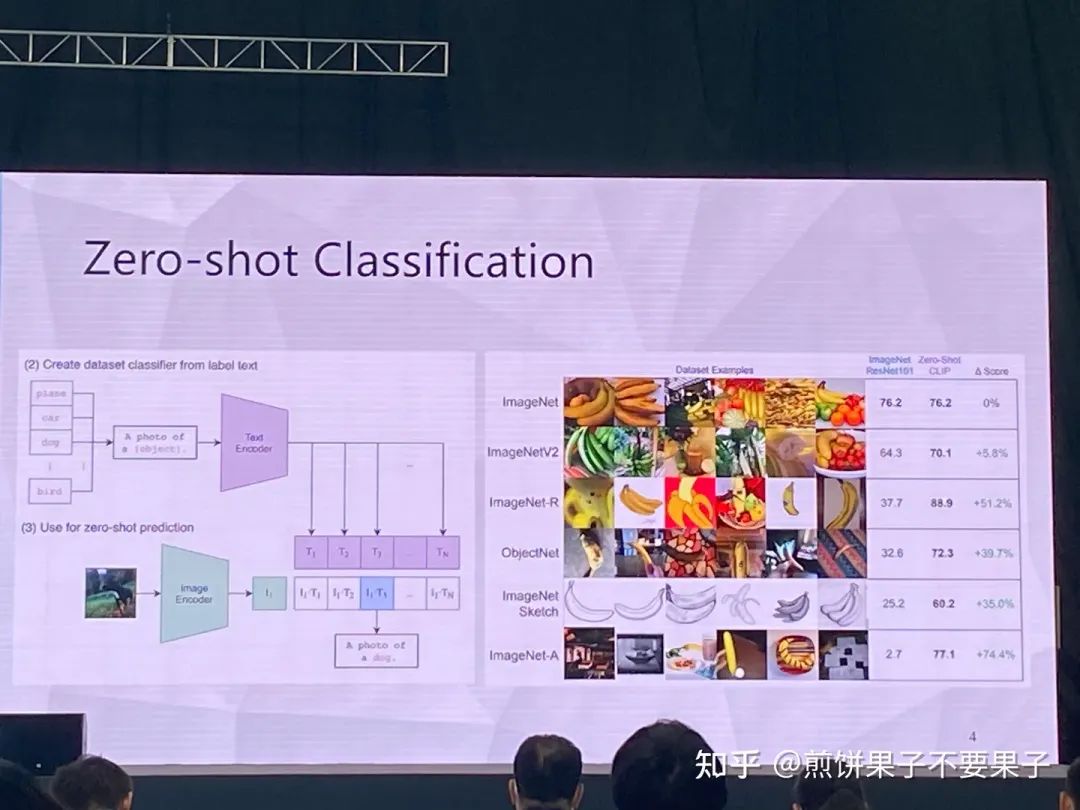

在一些非自然圖像中要比傳統(tǒng)模型表現(xiàn)更好

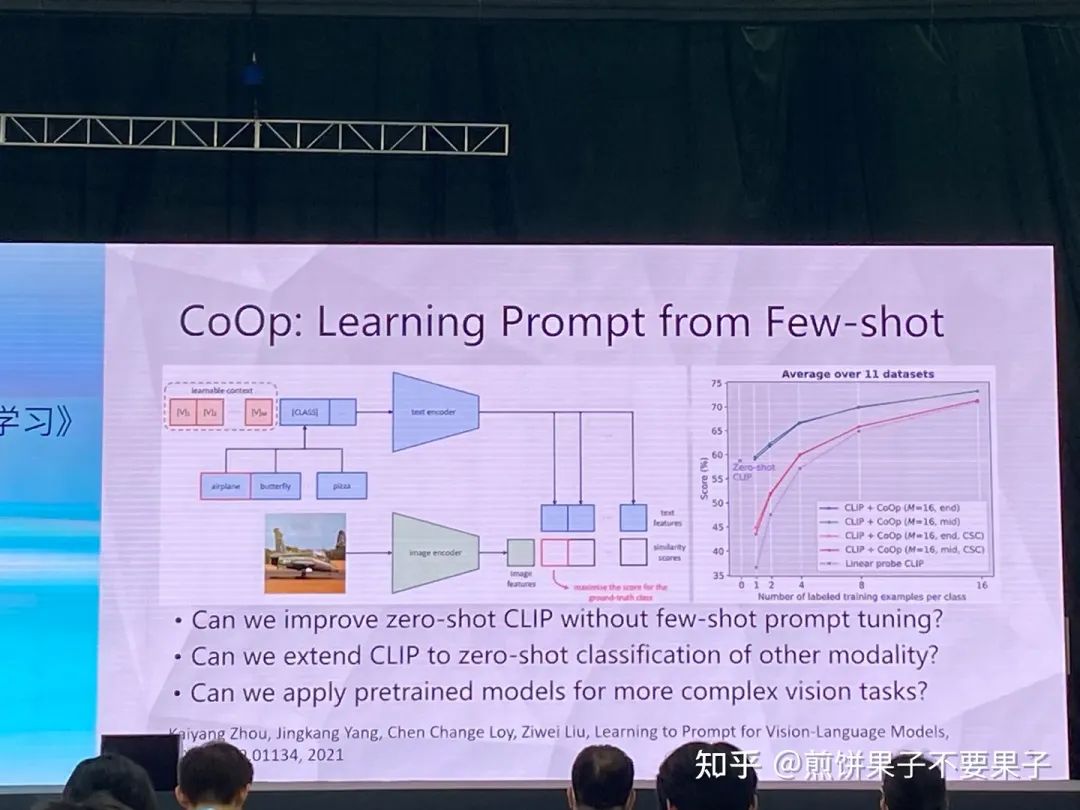

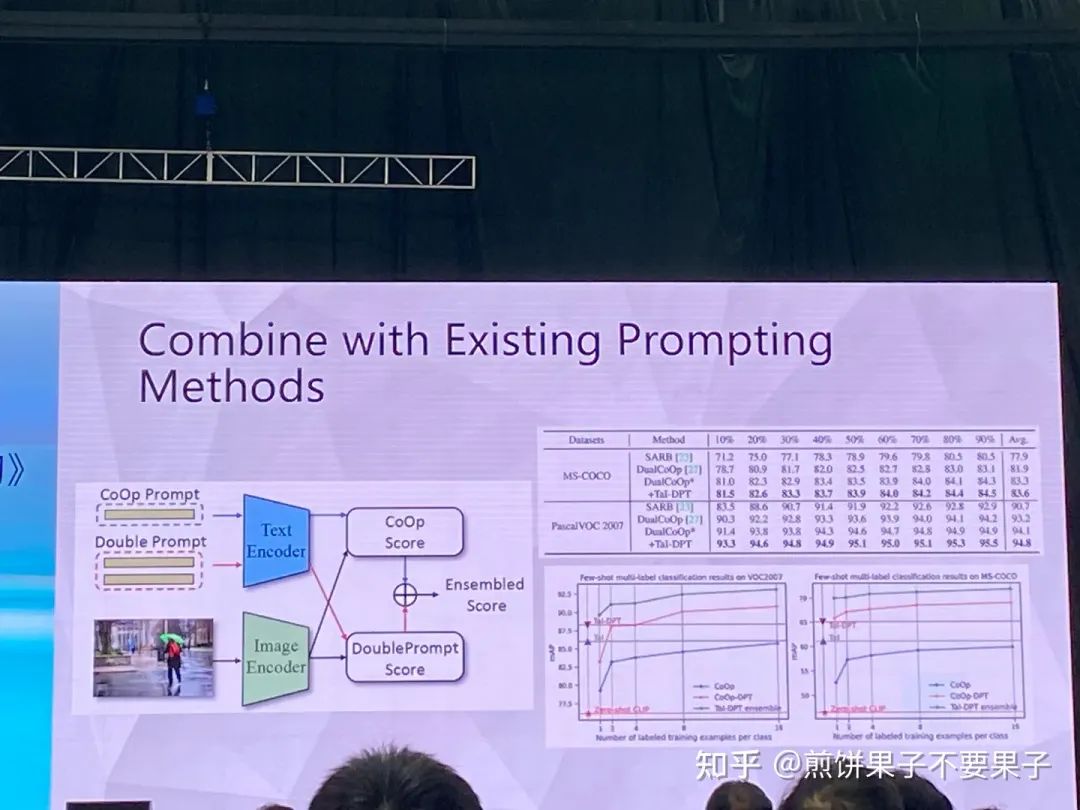

CoOp 增加一些 prompt 會(huì)讓模型能力進(jìn)一步提升

怎么讓能力更好?可以引入其他知識(shí),即其他的預(yù)訓(xùn)練模型,包括大語(yǔ)言模型、多模態(tài)模型

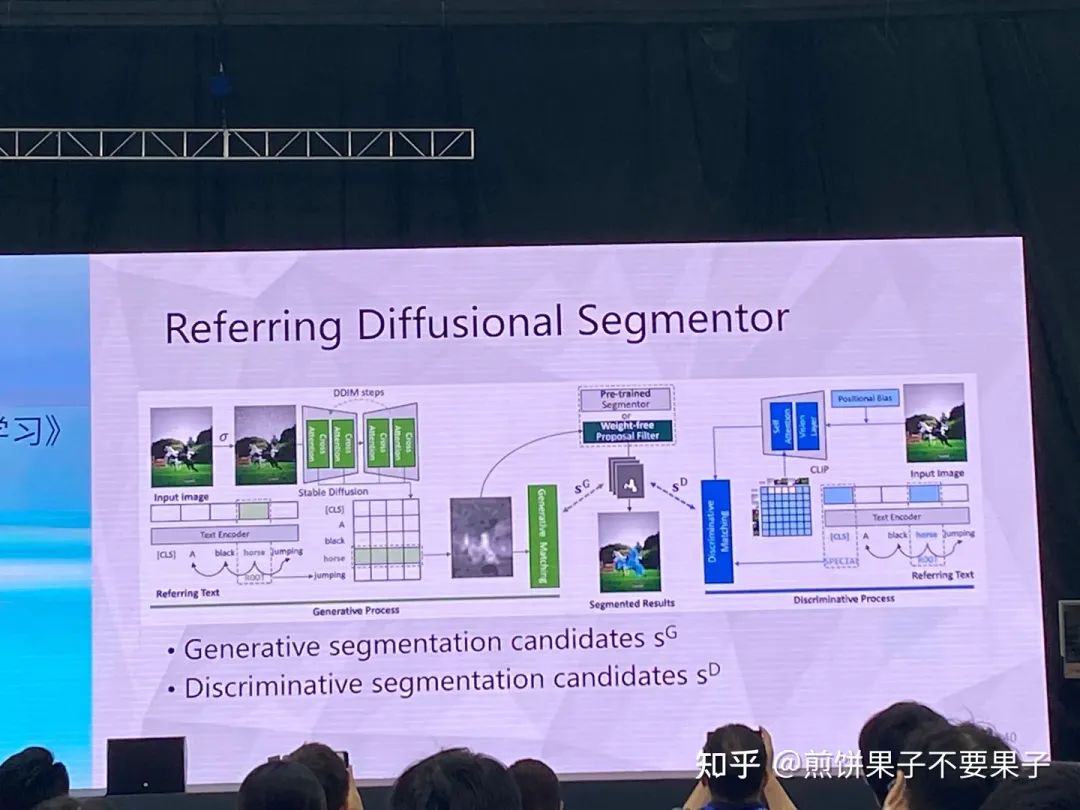

也包括 Stable Diffusion 多模態(tài)預(yù)訓(xùn)練模型

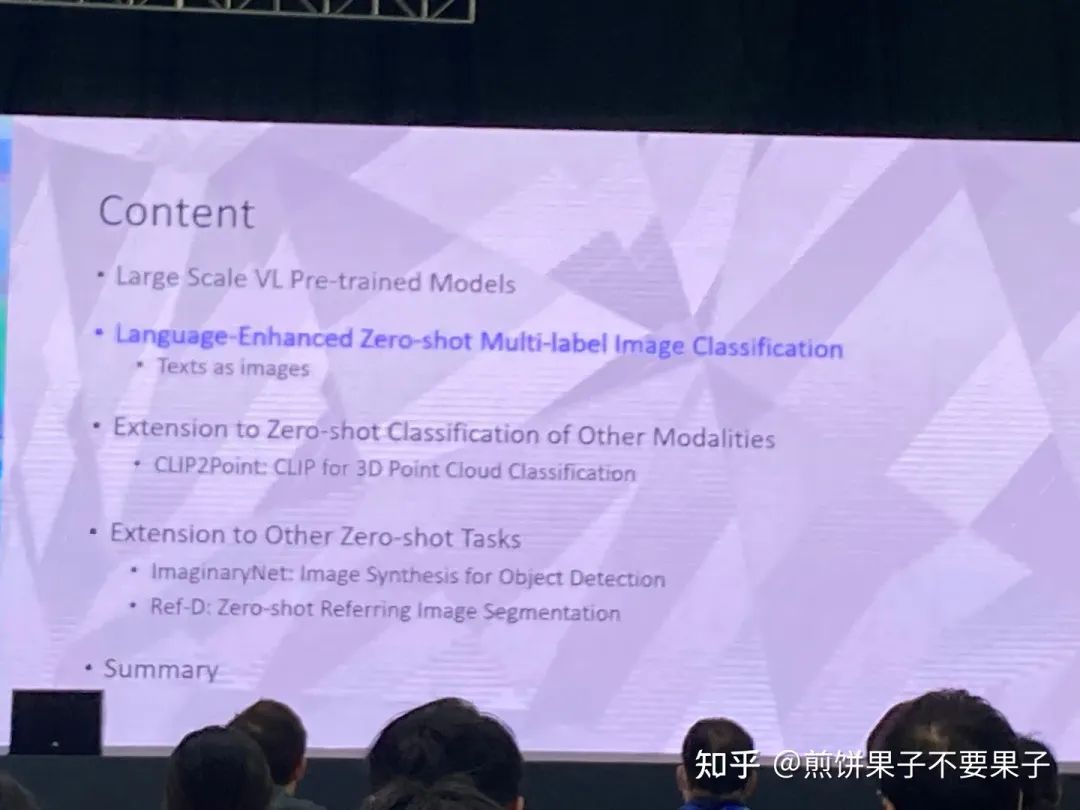

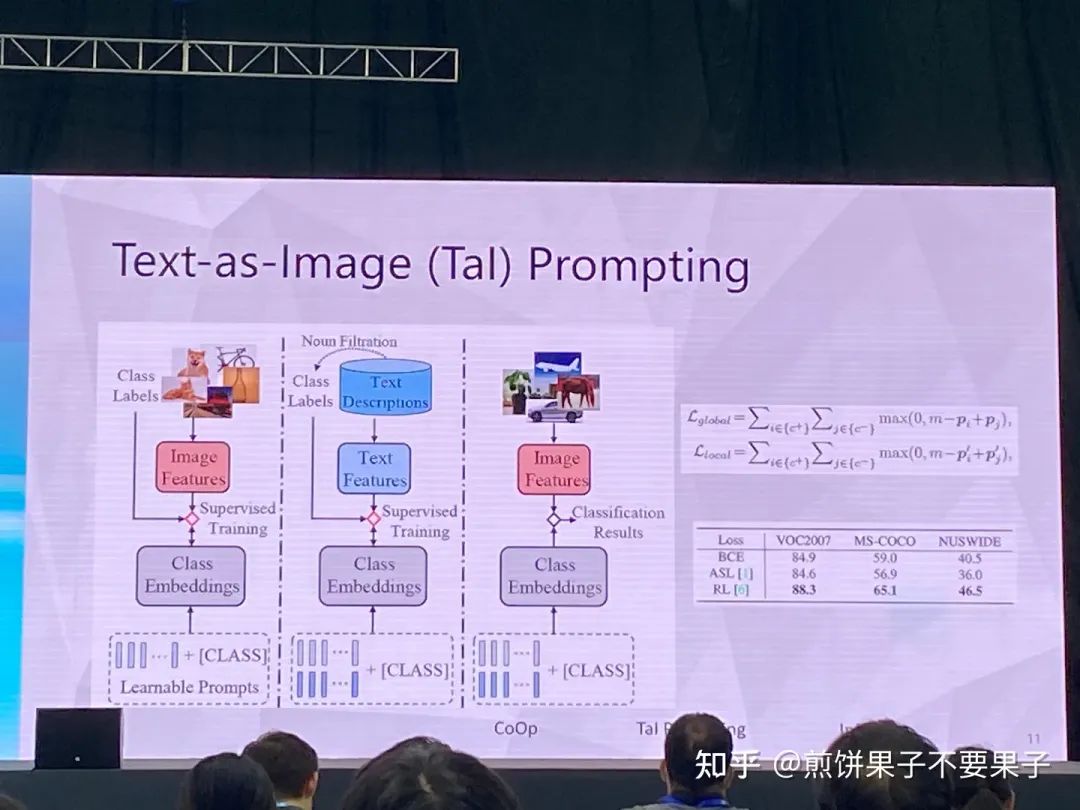

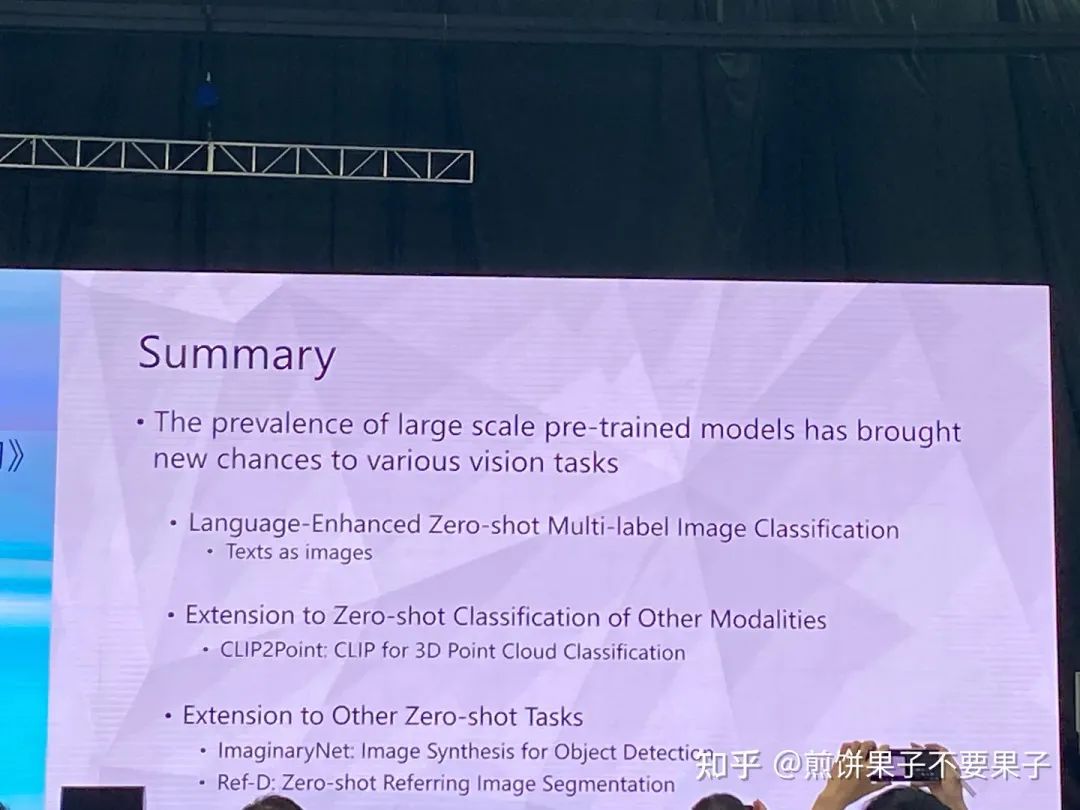

考慮多標(biāo)簽圖像分類任務(wù)——每幅圖像大于一個(gè)類別

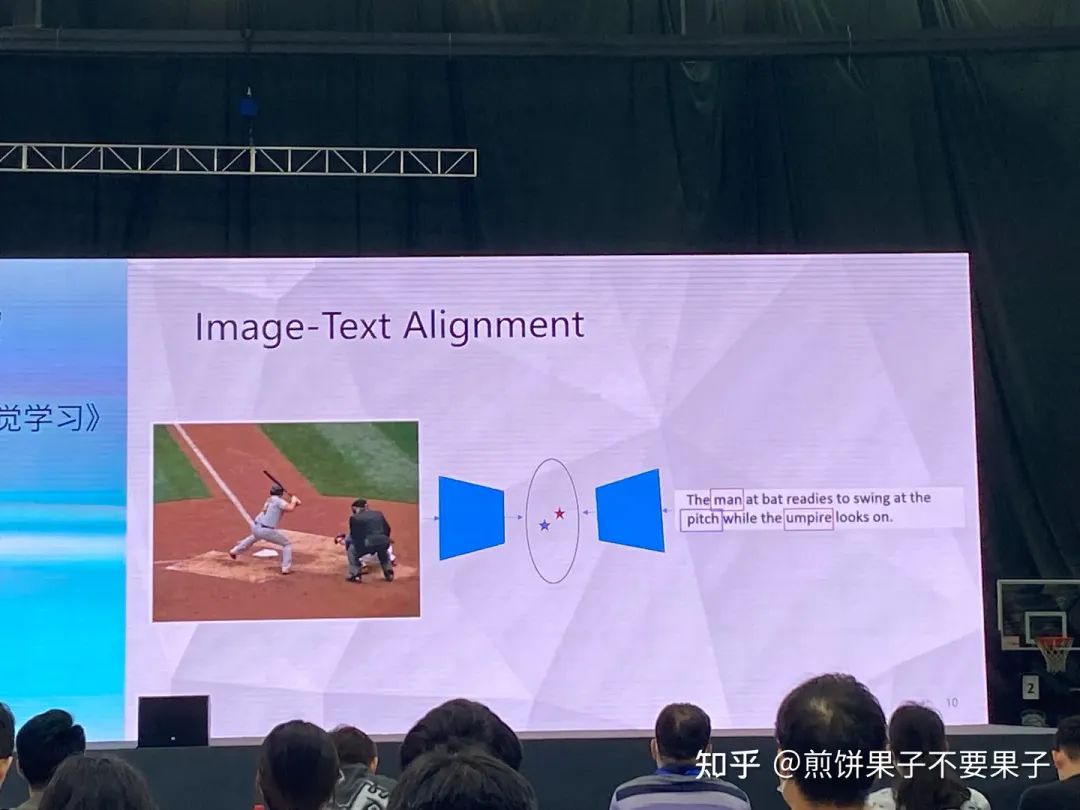

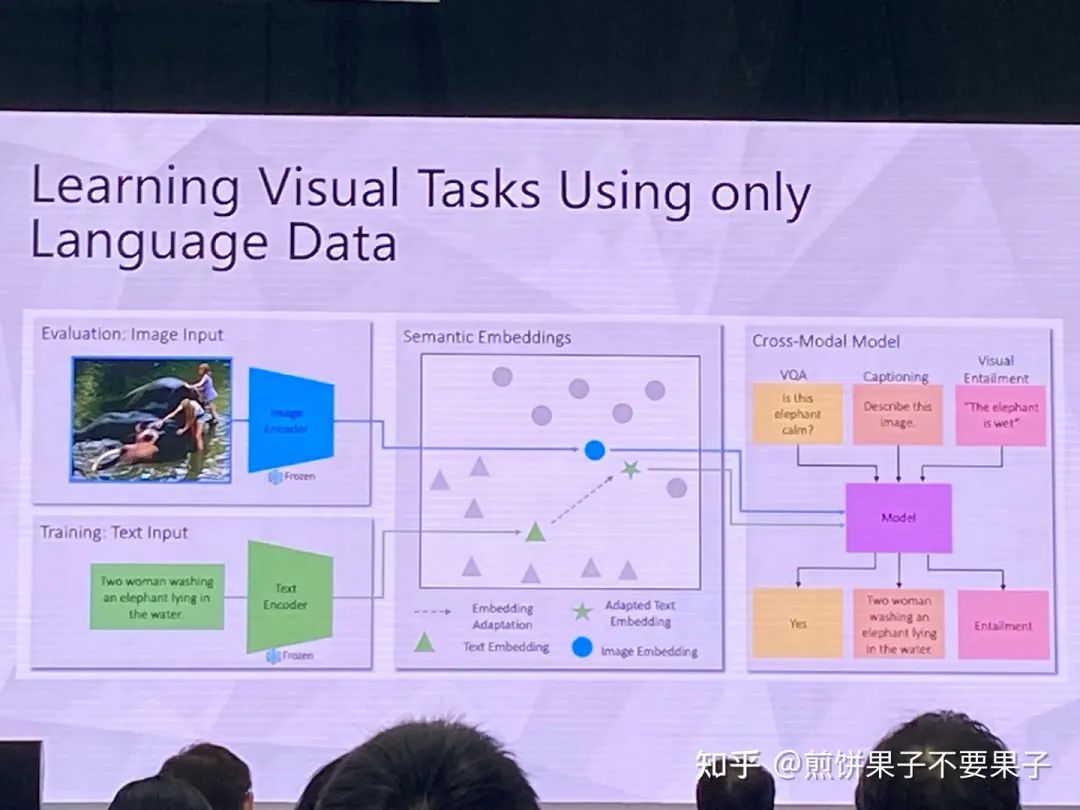

如果已有圖文對(duì)齊模型——能否用文本特征代替圖像特征

訓(xùn)練的時(shí)候使用文本組成的句子

對(duì)齊總會(huì)有 gap,選 loss 的時(shí)候使用 rank loss,對(duì)模態(tài) gap 更穩(wěn)定

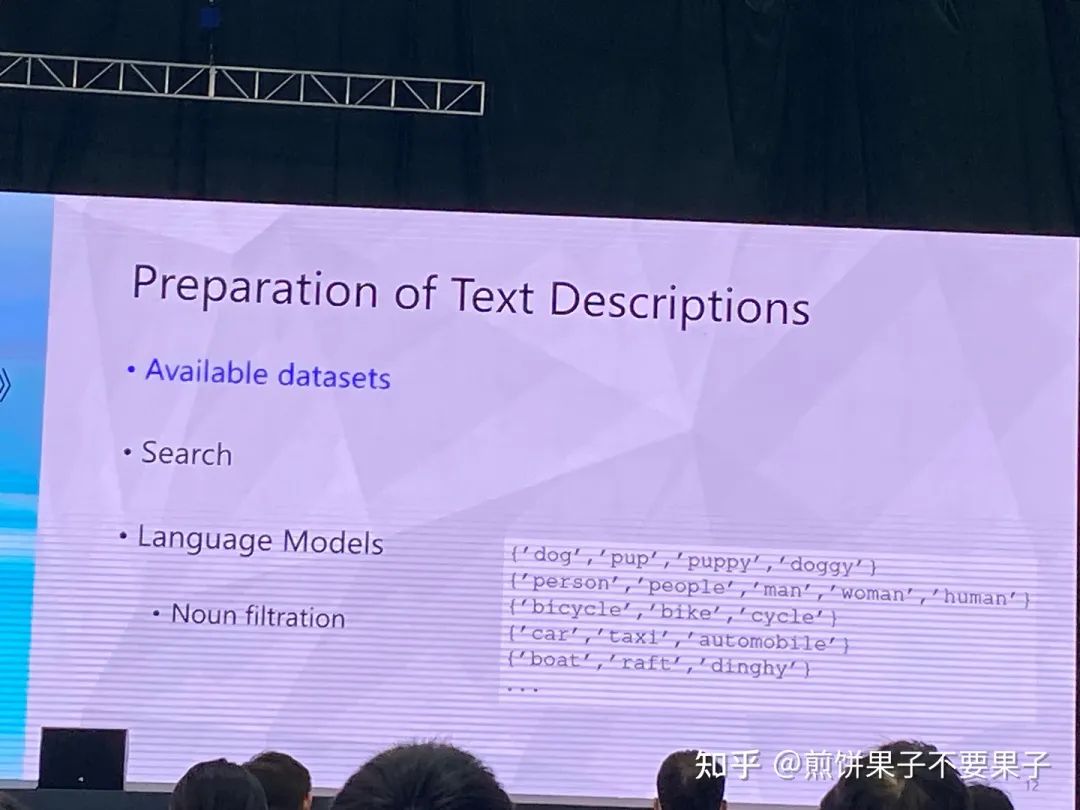

拿到文本后有幾種選擇,比如 Coco 只要其中的 caption 不要圖像,或是 Google 搜句子,抑或是語(yǔ)言模型生成

最后選擇第一種,因?yàn)榉€(wěn)定性和效果更好,能夠保證同樣數(shù)據(jù)集(同分布?)

可以建一個(gè)同義詞表

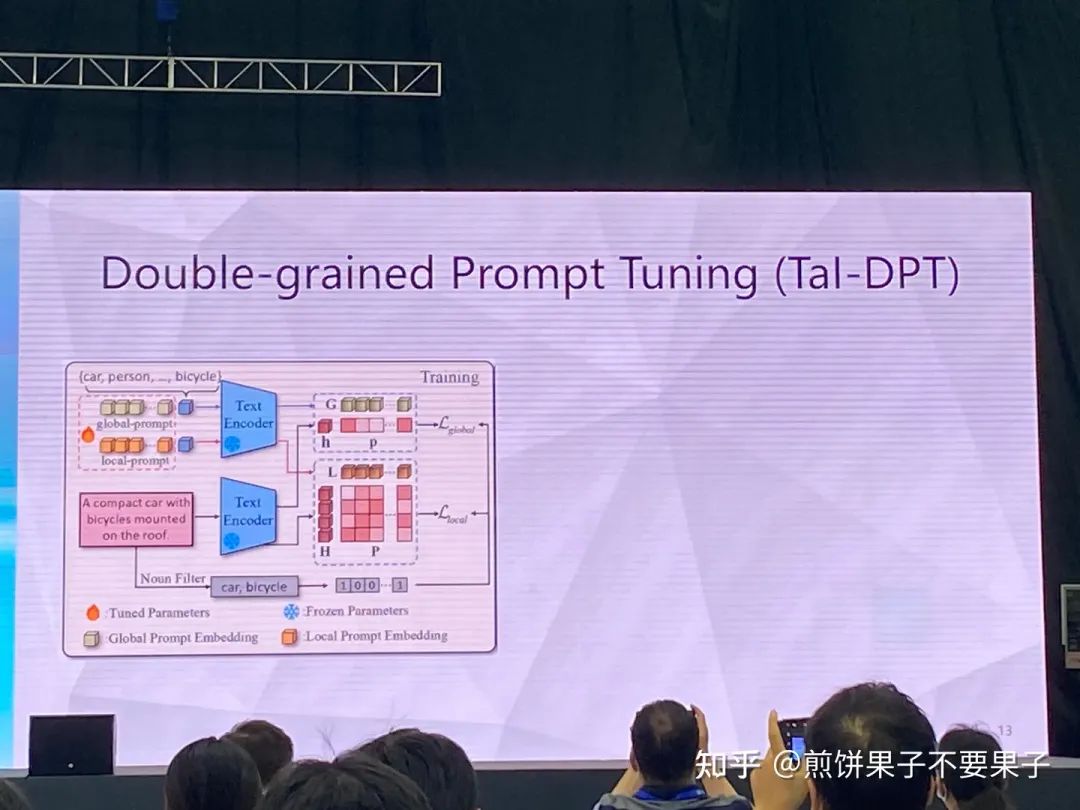

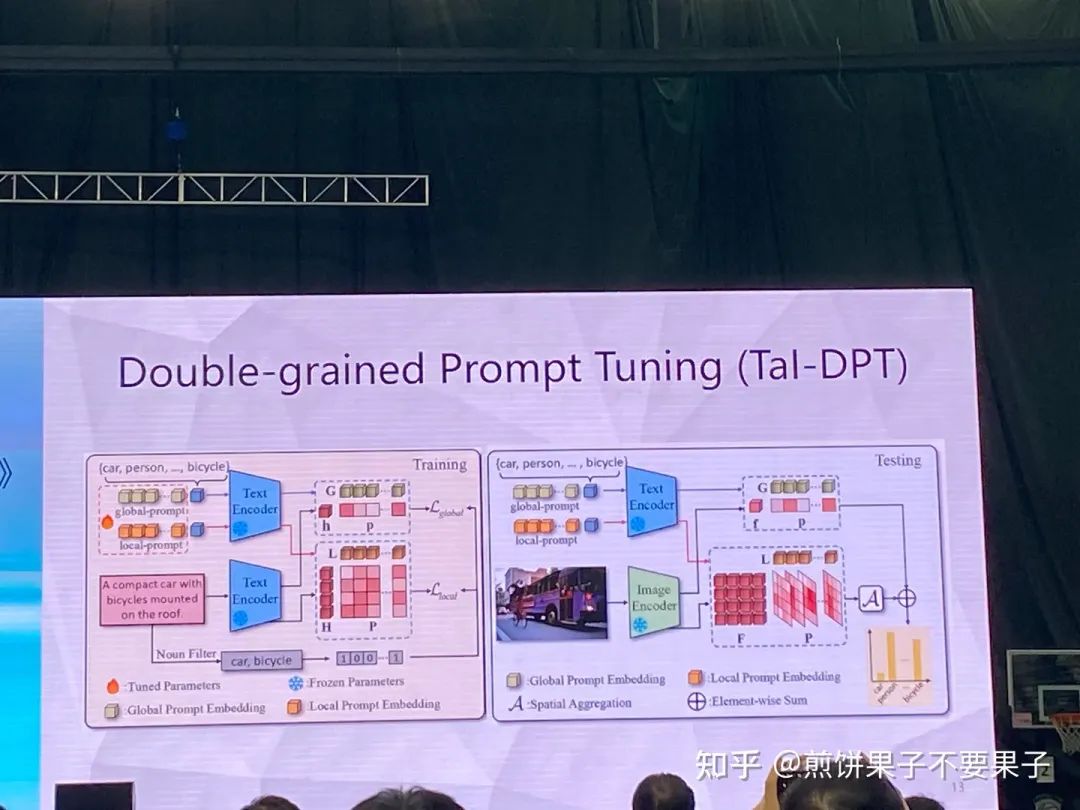

兩種 prompt,global 關(guān)注句子里有沒(méi)有貓,local 關(guān)心這個(gè)詞是不是跟貓有關(guān)系

測(cè)試的時(shí)候就將句子變成圖像,global 不變,local 變成了跟圖像里的 token 做比較

如果再加上少量文本(大量句子和少量文本)性能會(huì)進(jìn)一步提升

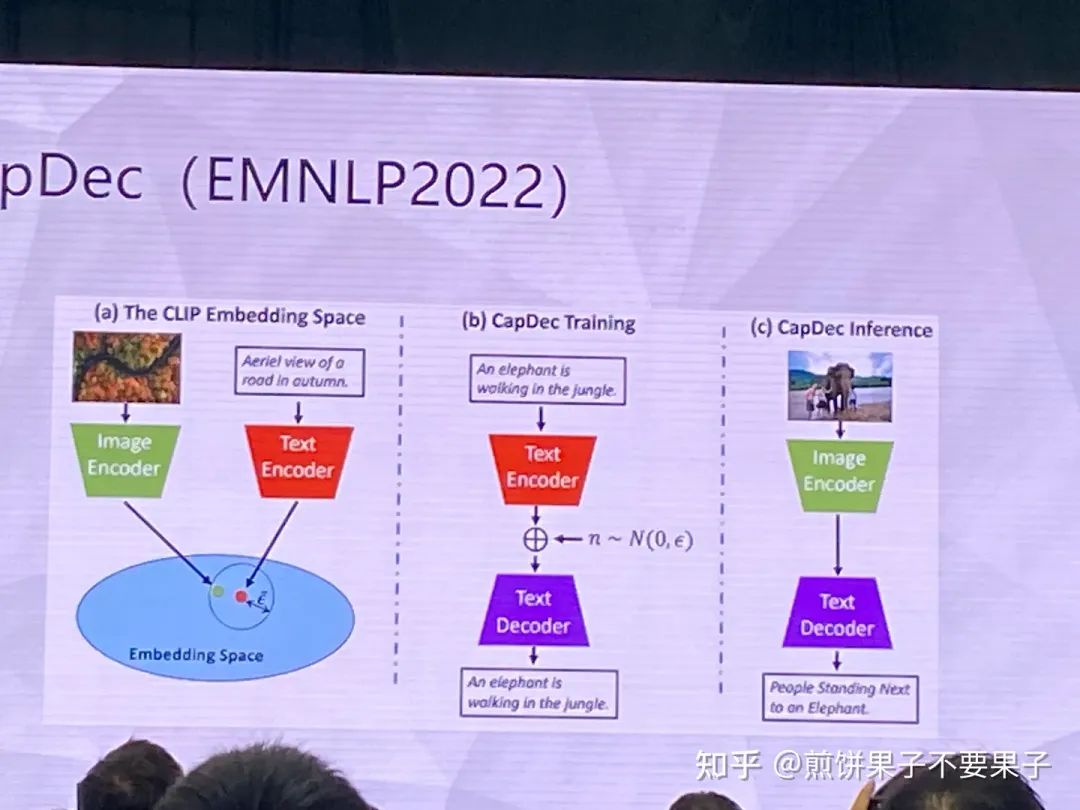

一些相關(guān)工作,提完文本特征加一些噪聲提高魯棒性,消解圖文 gap

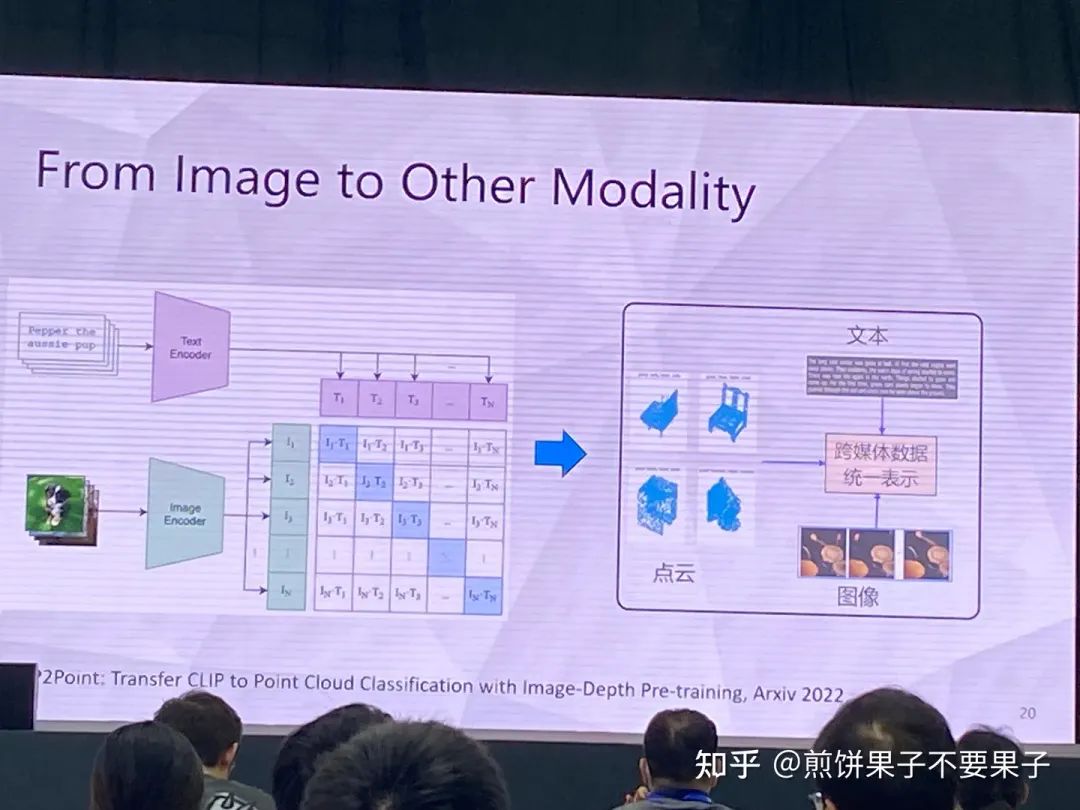

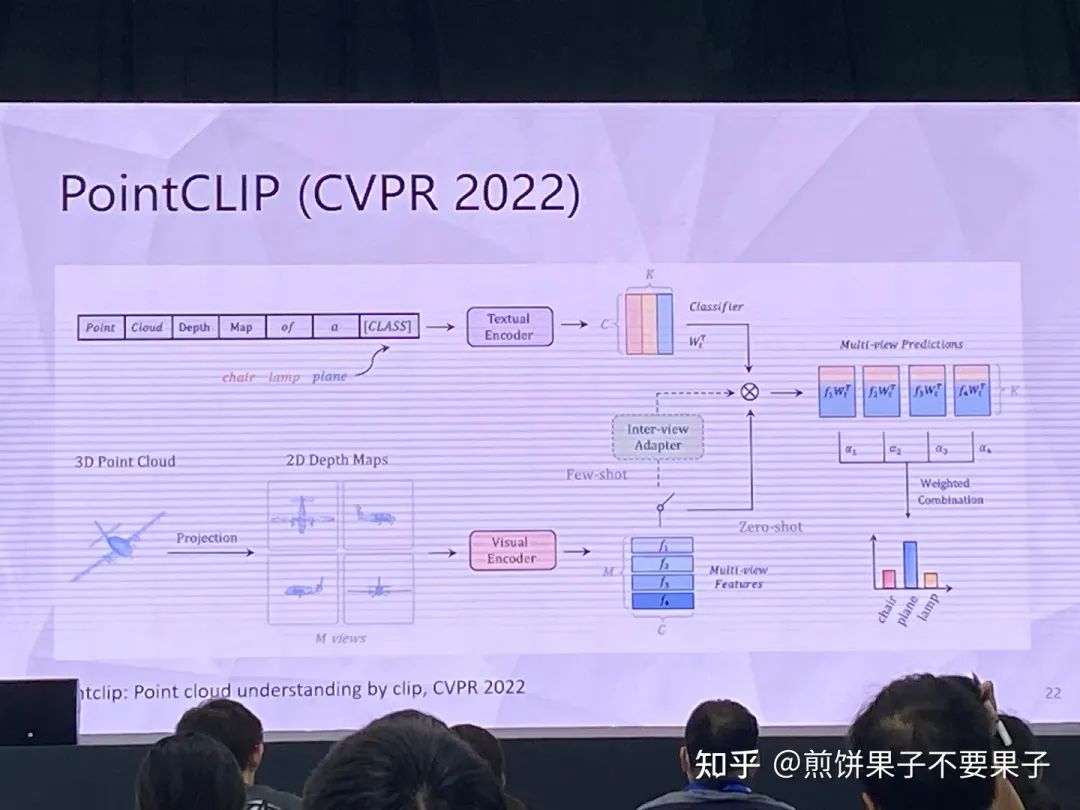

3d 樣本較難,因?yàn)辄c(diǎn)云-文本對(duì)較少,很難獲取

投影后的 3d 點(diǎn)云可以被視作 2d 圖像處理,使用圖像 encoder

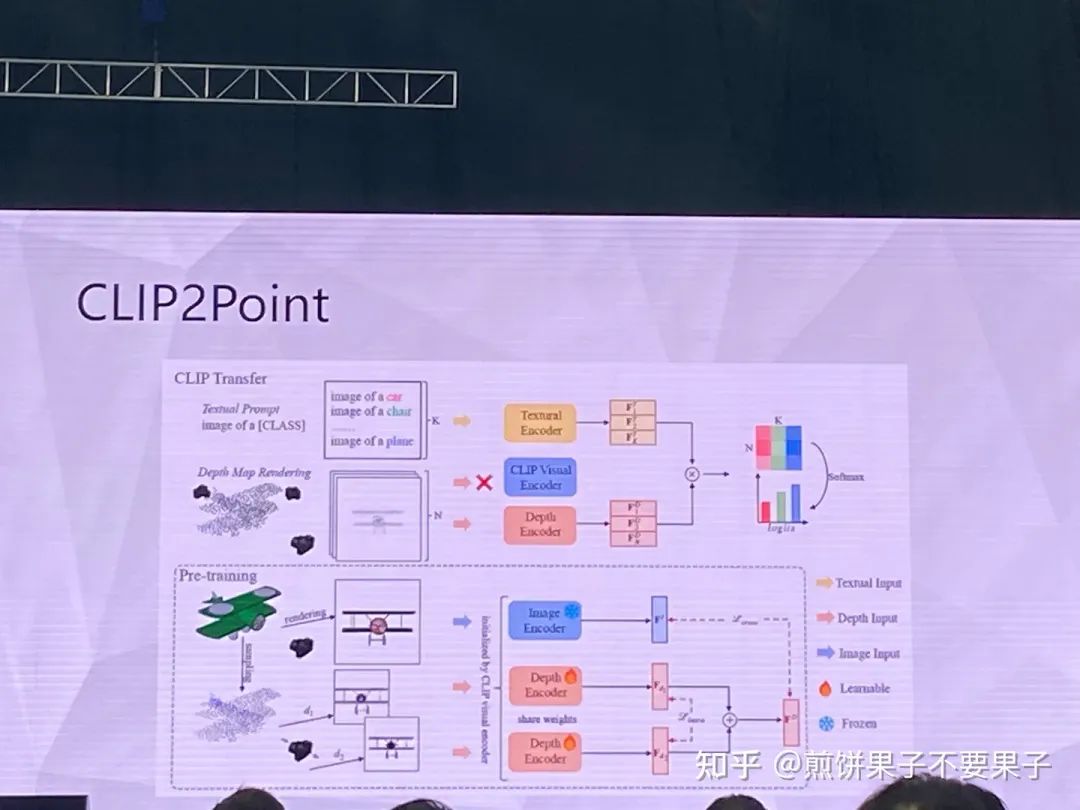

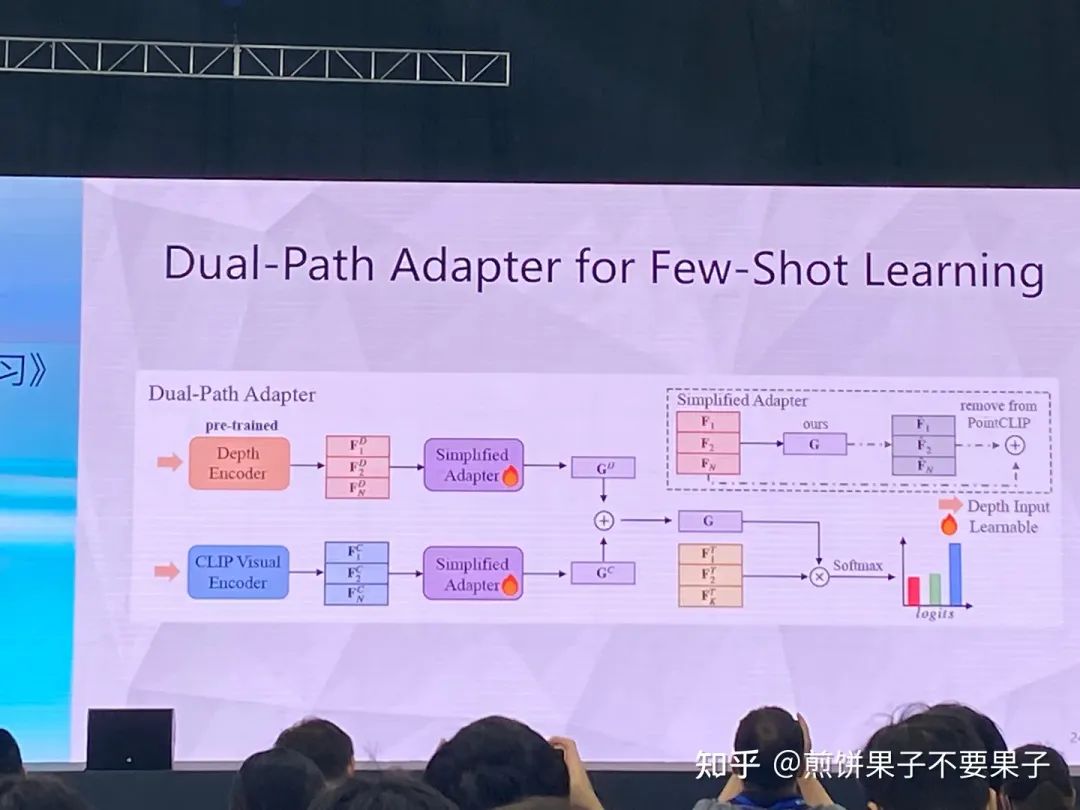

但投影點(diǎn)云依然與圖像存在 gap,于是采取另一種思路

投影的確與圖像相關(guān),但依然有調(diào)整空間,所以轉(zhuǎn)換成某個(gè)方向的圖像和該方向點(diǎn)云的投影圖像做匹配

投影和圖像對(duì)齊,圖像和文本對(duì)齊,因此就可以實(shí)現(xiàn)零樣本學(xué)習(xí)

如果有一些少量的有標(biāo)簽監(jiān)督,相當(dāng)于 few-shot,效果也相當(dāng)好

全監(jiān)督效果也很好

當(dāng)時(shí)覺(jué)得圖像可以做中介,那么紅外、熱成像等其他模態(tài)都可以

ImageBind 以圖像為中介將六種模態(tài)對(duì)齊到一起,重新訓(xùn)練

但大家依然可以做自己領(lǐng)域相關(guān)的方向,以圖像作為中介對(duì)比,還有很大的空間

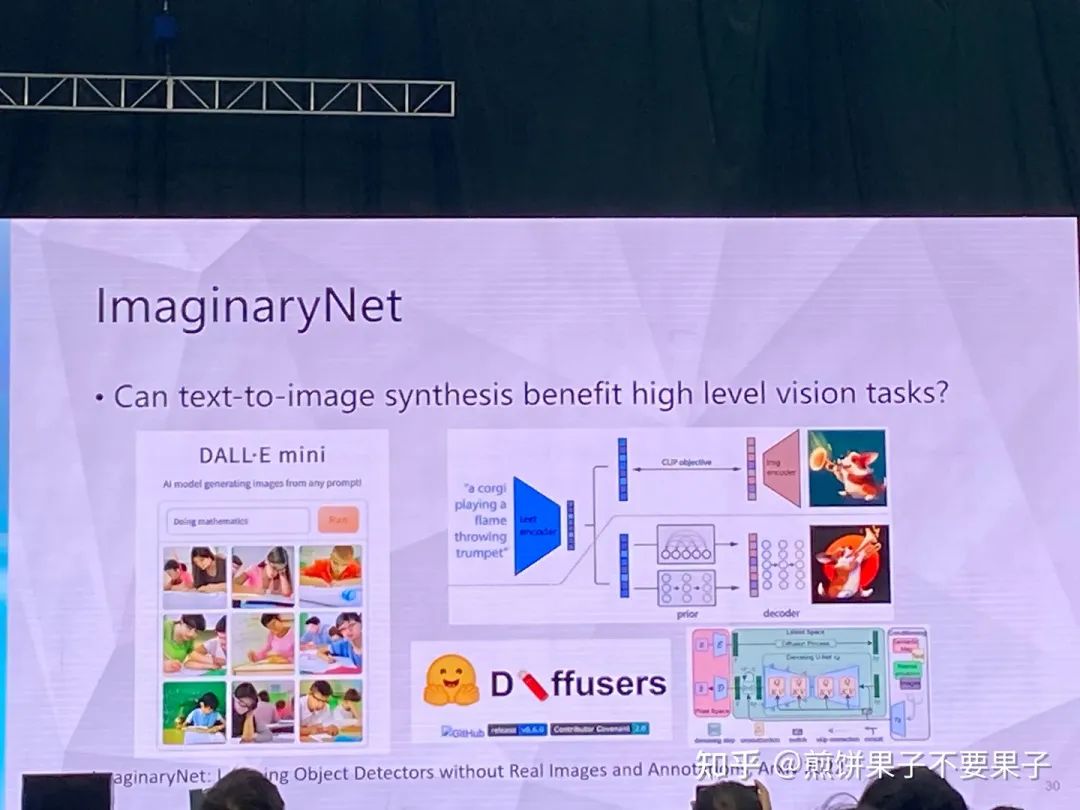

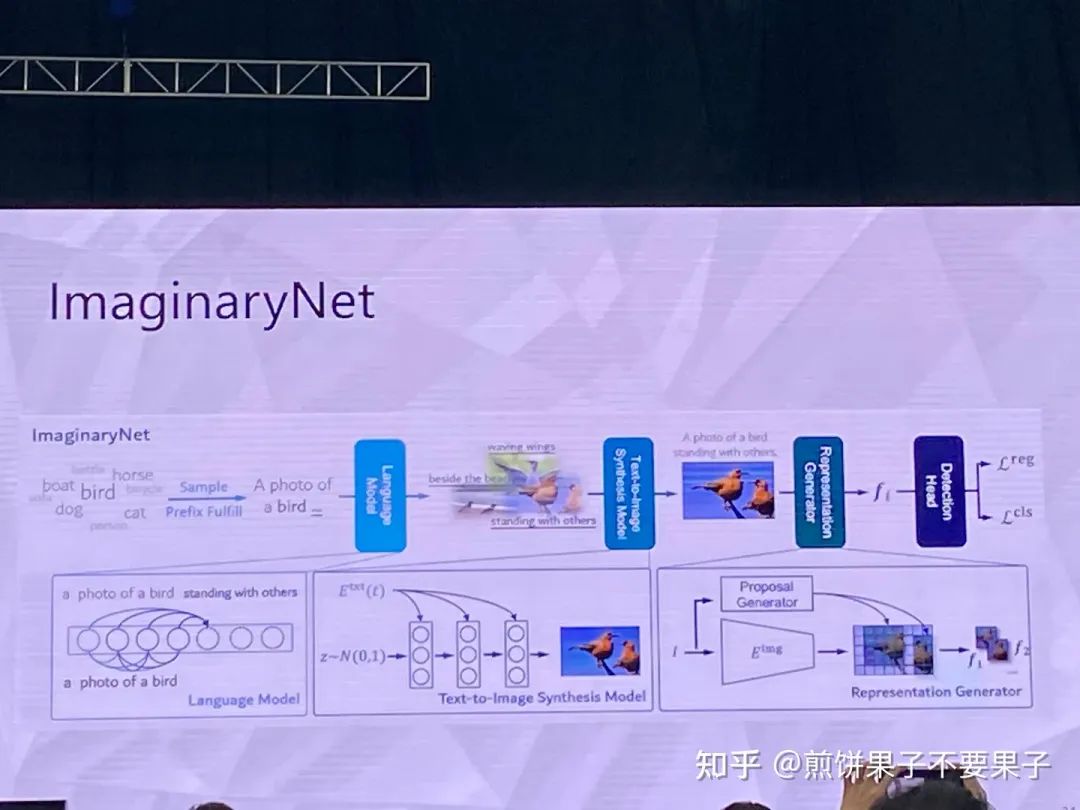

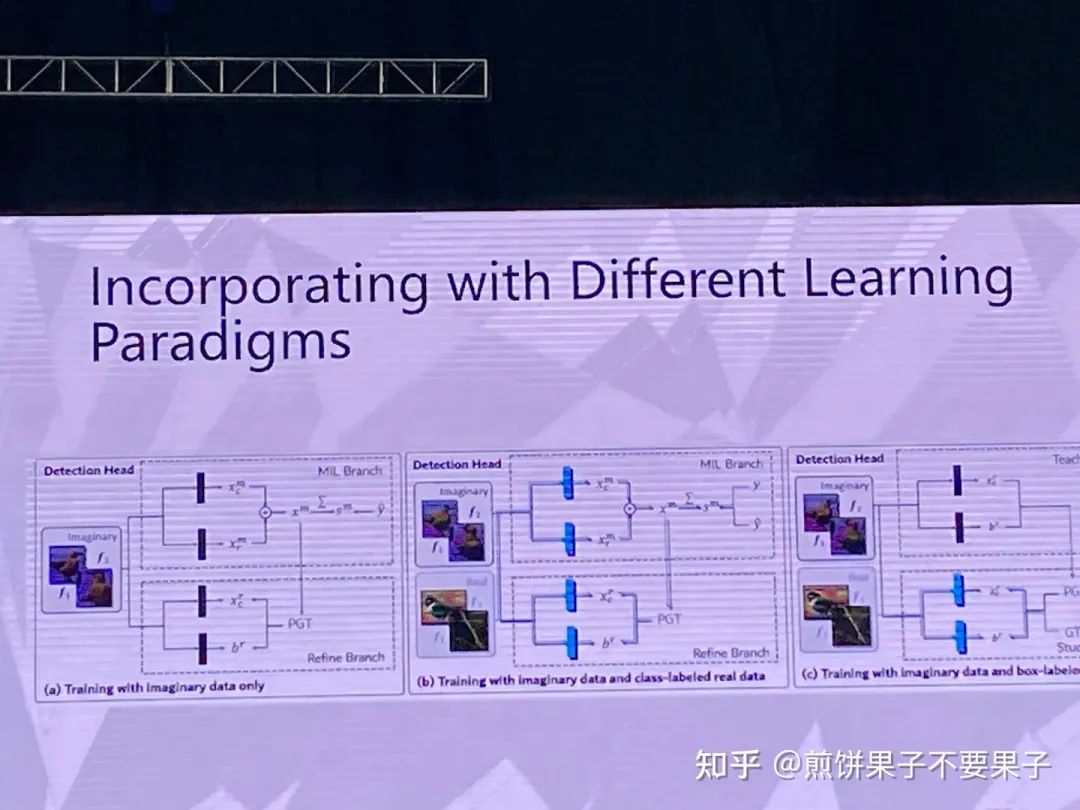

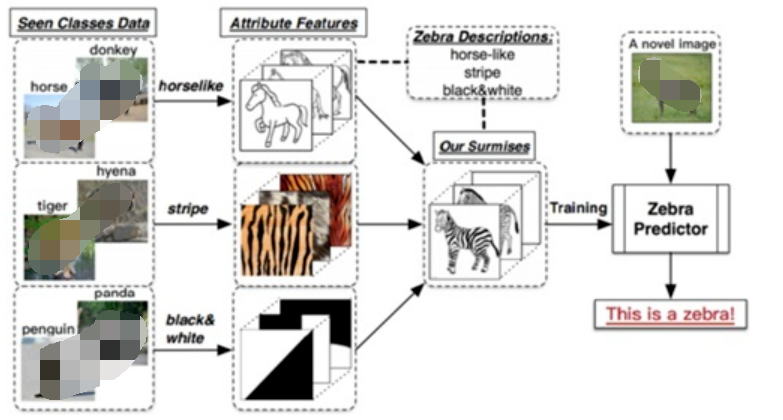

用想象的方式開(kāi)展學(xué)習(xí)

假設(shè)有一些類別,使用語(yǔ)言模型生成一些句子,再根據(jù)句子使用生成模型生成圖像

因此有了圖像和類別匹配對(duì)(弱監(jiān)督目標(biāo)檢測(cè))

希望即使使用合成圖像,模型在真實(shí)圖像上也可以比較好

因?yàn)轭悇e本身和圖像會(huì)比較簡(jiǎn)單,但如果使用語(yǔ)言模型,比如貓變成趴著的貓,這樣圖像多樣性會(huì)很高

考慮 SAM 和 Stable diffusion 特定完成分割任務(wù)

通過(guò) SAM 得到的 proposal 提取特征

責(zé)任編輯:彭菁

-

語(yǔ)言模型

+關(guān)注

關(guān)注

0文章

538瀏覽量

10341 -

訓(xùn)練模型

+關(guān)注

關(guān)注

1文章

36瀏覽量

3887

原文標(biāo)題:VALSE 2023 | 左旺孟教授:預(yù)訓(xùn)練模型和語(yǔ)言增強(qiáng)的零樣本視覺(jué)學(xué)習(xí)

文章出處:【微信號(hào):CVer,微信公眾號(hào):CVer】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

一文詳解知識(shí)增強(qiáng)的語(yǔ)言預(yù)訓(xùn)練模型

【大語(yǔ)言模型:原理與工程實(shí)踐】大語(yǔ)言模型的預(yù)訓(xùn)練

【大語(yǔ)言模型:原理與工程實(shí)踐】大語(yǔ)言模型的應(yīng)用

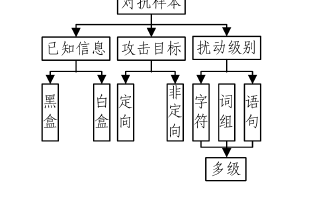

基于深度學(xué)習(xí)的自然語(yǔ)言處理對(duì)抗樣本模型

融合零樣本學(xué)習(xí)和小樣本學(xué)習(xí)的弱監(jiān)督學(xué)習(xí)方法綜述

如何更高效地使用預(yù)訓(xùn)練語(yǔ)言模型

利用視覺(jué)語(yǔ)言模型對(duì)檢測(cè)器進(jìn)行預(yù)訓(xùn)練

預(yù)訓(xùn)練語(yǔ)言模型的字典描述

如何充分挖掘預(yù)訓(xùn)練視覺(jué)-語(yǔ)言基礎(chǔ)大模型的更好零樣本學(xué)習(xí)能力

使用BLIP-2 零樣本“圖生文”

預(yù)訓(xùn)練數(shù)據(jù)大小對(duì)于預(yù)訓(xùn)練模型的影響

形狀感知零樣本語(yǔ)義分割

什么是零樣本學(xué)習(xí)?為什么要搞零樣本學(xué)習(xí)?

基于預(yù)訓(xùn)練模型和語(yǔ)言增強(qiáng)的零樣本視覺(jué)學(xué)習(xí)

基于預(yù)訓(xùn)練模型和語(yǔ)言增強(qiáng)的零樣本視覺(jué)學(xué)習(xí)

評(píng)論