近年來,大規(guī)模深度神經(jīng)網(wǎng)絡(luò)的顯著成就徹底改變了人工智能領(lǐng)域,在各種任務(wù)和領(lǐng)域展示了前所未有的性能。這些高度復(fù)雜的模型,通常具有數(shù)百萬甚至數(shù)十億個(gè)參數(shù),在計(jì)算機(jī)視覺、自然語言理解和語音識(shí)別等領(lǐng)域表現(xiàn)出了卓越的能力。

本文提出了廣義LoRA(GLoRA),一種通用參數(shù)高效微調(diào)任務(wù)的先進(jìn)方法。增強(qiáng)低秩適應(yīng)(LoRA),GLoRA采用廣義提示模塊優(yōu)化預(yù)訓(xùn)練模型權(quán)重并調(diào)整中間層激活函數(shù),為不同的任務(wù)和數(shù)據(jù)集提供更大的靈活性和能力。

GLoRA源于統(tǒng)一的數(shù)學(xué)公式,具有較強(qiáng)的transfer learning、few-shot learning和domain generalization能力,其通過權(quán)值和激活的附加維度調(diào)整到新任務(wù)。

實(shí)驗(yàn)表明,GLoRA在自然、專業(yè)和結(jié)構(gòu)化基準(zhǔn)測(cè)試中優(yōu)于所有以前的方法,在各種數(shù)據(jù)集上以更少的參數(shù)和計(jì)算實(shí)現(xiàn)了更高的準(zhǔn)確性。此外,結(jié)構(gòu)重新參數(shù)化設(shè)計(jì)確保GLoRA不需要額外的推理成本,使其成為資源有限應(yīng)用程序的實(shí)用解決方案。

GLoRA

簡(jiǎn)介

本文首先對(duì)現(xiàn)有最先進(jìn)的PEFT方法進(jìn)行數(shù)學(xué)概述,分析了它們的優(yōu)缺點(diǎn)。然后,引入了一個(gè)整合所有現(xiàn)有SOTA PEFT方法的統(tǒng)一公式,并根據(jù)統(tǒng)一公式的觀點(diǎn)詳細(xì)闡述了所提出的廣義LoRA。然后,提出了一種結(jié)構(gòu)重新參數(shù)化設(shè)計(jì),以在不增加額外成本的情況下顯示推理效率。為了實(shí)現(xiàn)廣義LoRA的目標(biāo),還引入了最優(yōu)分層配置的進(jìn)化搜索,進(jìn)一步對(duì)所提出的方法的更高性能進(jìn)行了理論分析和討論。

已有方法及其局限性

Visual Prompt Tuning(VPT) :VPT將少量特定于任務(wù)的可學(xué)習(xí)參數(shù)引入輸入空間,同時(shí)在下游微調(diào)期間凍結(jié)整個(gè)預(yù)先訓(xùn)練的Transformer主干。VPT提出了兩種策略:VPT-Shallow和VPT-Deep。

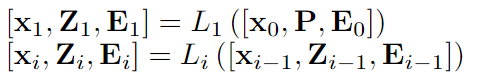

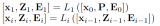

VPT-Shallow策略如下:其中P是可訓(xùn)練的提示。x是[CLS]token,E是圖像paches。 VPT-Deep策略如下:VTP-Deep在大多數(shù)視覺任務(wù)上都優(yōu)于完全微調(diào),在低數(shù)據(jù)狀態(tài)下也有更好的準(zhǔn)確性。

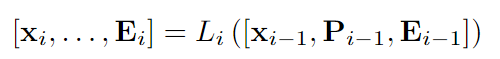

VPT-Deep策略如下:VTP-Deep在大多數(shù)視覺任務(wù)上都優(yōu)于完全微調(diào),在低數(shù)據(jù)狀態(tài)下也有更好的準(zhǔn)確性。

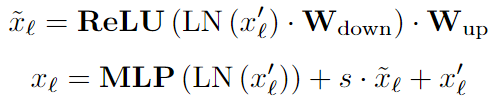

AdaptFormer:AdaptFormer在MLP塊上引入了兩個(gè)線性層的并行可學(xué)習(xí)分支和ReLU,并在暫停其他部分的同時(shí)僅學(xué)習(xí)該路徑。

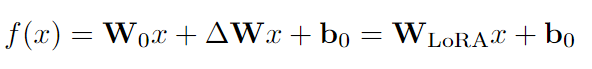

LoRa:LoRA方法凍結(jié)預(yù)訓(xùn)練模型權(quán)重并將可訓(xùn)練的低秩分解矩陣注入每一層。只從預(yù)訓(xùn)練的權(quán)重中學(xué)習(xí)殘差。在GPT-2模型家族上與prompt learning、adapters等相比,實(shí)現(xiàn)了SOTA性能。

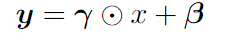

Scaling & Shifting Features (SSF) :SSF模塊在訓(xùn)練過程中對(duì)所有的MLP、MHSA、Layernorm模塊進(jìn)行特征縮放和移位,并在推理過程中進(jìn)行重新參數(shù)化,其是一個(gè)線性結(jié)構(gòu)。

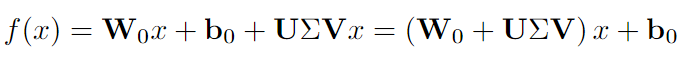

FacT:FacT提出使用張量分解方法來存儲(chǔ)額外的權(quán)重,將模型的權(quán)重張量化為單個(gè)3D張量,然后將其相加分解為輕量級(jí)因子。在微調(diào)中,只有因子會(huì)被更新和存儲(chǔ)。FacT有兩種方式: 其中LoRA中的ΔW被分解為U、V和Σ。

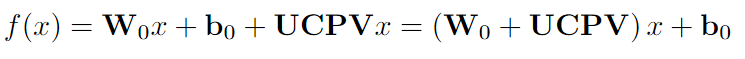

其中LoRA中的ΔW被分解為U、V和Σ。 其中LoRA中的ΔW被分解為U、C、P和V。

其中LoRA中的ΔW被分解為U、C、P和V。

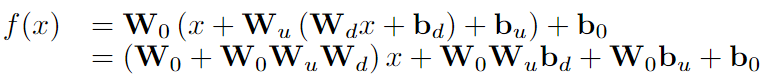

RepAdapter:RepAdapter將輕量級(jí)網(wǎng)絡(luò)插入到預(yù)先訓(xùn)練的模型中,并且在訓(xùn)練后,額外的參數(shù)將被重新參數(shù)化為附近的投影權(quán)重。將順序適配器添加到MHA和MLP中,適配器是線性的,因此可以重新參數(shù)化,并且有兩層:下采樣密集FC層以下采樣輸入;對(duì)劃分為組的下采樣特征進(jìn)行上采樣,并且每個(gè)組都具有上采樣層。上采樣層組可以合并為單個(gè)稀疏上采樣層,并且可以直接重新參數(shù)化為原始MLP或MHSA。

局限性:許多現(xiàn)有的PETL方法,例如(VPT, Adapter)會(huì)增加推理時(shí)間,因其提出的結(jié)構(gòu)無法重新參數(shù)化。直接提示調(diào)優(yōu)也很難設(shè)計(jì),帶來了計(jì)算負(fù)擔(dān),并且需要超參數(shù)調(diào)整,即如何以及在哪里放置提示。LoRA在推理時(shí)可以重新參數(shù)化,但它不能擴(kuò)展到更大的矩陣,并且適應(yīng)能力受到權(quán)重空間的限制。SSF/RepAdaptor無法學(xué)習(xí)到權(quán)重的變化,即權(quán)重空間中的ΔW,而LoRA/FacT不能有效地學(xué)習(xí)特征變化的縮放和移動(dòng),即特征空間中的ΔH。在從大型模型執(zhí)行遷移學(xué)習(xí)時(shí),特征空間和權(quán)重空間都需要靈活性。因此本文在這項(xiàng)工作中提出的的改進(jìn)想法為:ΔW調(diào)整、ΔH調(diào)整以及W和H縮放和移位學(xué)習(xí)。

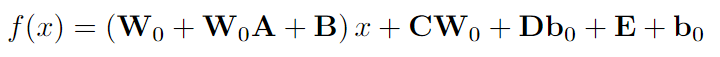

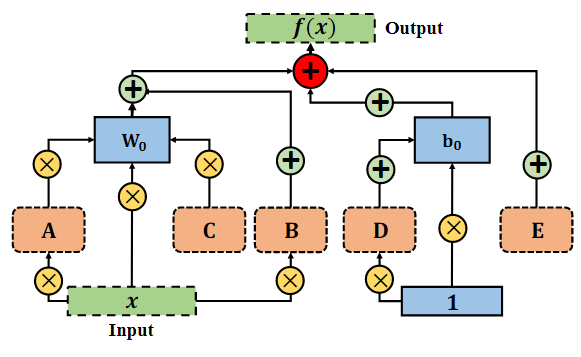

One-for-All unified formulation

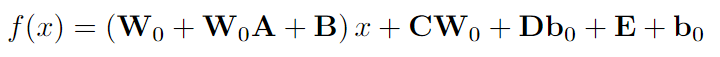

對(duì)于模型微調(diào),本文提出了一個(gè)統(tǒng)一的公式,包含所有可調(diào)維度,包括但不限于權(quán)重空間和特征空間。此外,們采用重新參數(shù)化策略在推理階段將輔助參數(shù)合并到相鄰?fù)队皺?quán)重中。從廣義上講,本文提出的方法是所有先前解決方案的超集,即一次性機(jī)制。通過將不同的支持張量設(shè)置為零,GLoRA可以簡(jiǎn)化為這些先前方法中的任何一種。GLoRA體系結(jié)構(gòu)可以簡(jiǎn)潔地表述為統(tǒng)一的數(shù)學(xué)方程。 其中 A、B、C、D、E 是GLoRA中下游任務(wù)的可訓(xùn)練張量,W0和b0在整個(gè)微調(diào)過程中被凍結(jié)。A用于縮放權(quán)重,B的作用是縮放輸入并移動(dòng)權(quán)重,C服務(wù)于VPT-Deep、D和E表示逐層提示,分別用于縮放和移動(dòng)偏差。具體流程如下圖所示:

其中 A、B、C、D、E 是GLoRA中下游任務(wù)的可訓(xùn)練張量,W0和b0在整個(gè)微調(diào)過程中被凍結(jié)。A用于縮放權(quán)重,B的作用是縮放輸入并移動(dòng)權(quán)重,C服務(wù)于VPT-Deep、D和E表示逐層提示,分別用于縮放和移動(dòng)偏差。具體流程如下圖所示:

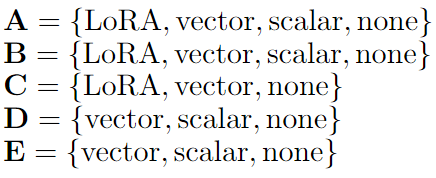

Prompt Modules-提示模塊

prompt modules描述了為 A、B、C、D、E 設(shè)計(jì)分層適配器或提示模塊的方法。從某種意義上說,這些可以采用scalars, vectors,low-rank decompositions, or none形式。基于這些可訓(xùn)練支持張量的作用,可分為以下幾類: 這種權(quán)重糾纏策略有助于在不增加參數(shù)數(shù)量的情況下增加搜索空間,并且由于不同子網(wǎng)中的權(quán)重共享,也顯示出更快的收斂

這種權(quán)重糾纏策略有助于在不增加參數(shù)數(shù)量的情況下增加搜索空間,并且由于不同子網(wǎng)中的權(quán)重共享,也顯示出更快的收斂

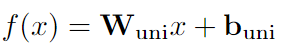

結(jié)構(gòu)重新參數(shù)化設(shè)計(jì)與推理效率分析

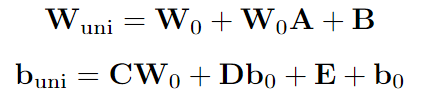

實(shí)現(xiàn)重新參數(shù)化的基本方面是消除相鄰變換中的非線性,從而允許將補(bǔ)充參數(shù)吸收到前面的參數(shù)中。去除這種非線性層不會(huì)對(duì)網(wǎng)絡(luò)的性能產(chǎn)生不利影響。GLoRA重新參數(shù)化策略如下: 在GLoRA中最終統(tǒng)一訓(xùn)練的權(quán)重和偏差。根據(jù)等式

在GLoRA中最終統(tǒng)一訓(xùn)練的權(quán)重和偏差。根據(jù)等式 對(duì)它們進(jìn)行重新參數(shù)化:

對(duì)它們進(jìn)行重新參數(shù)化: 因此,重新參數(shù)化策略將可學(xué)習(xí)參數(shù)集成到相鄰?fù)队皺?quán)重中,其可能是有利的,因?yàn)樵谕评黼A段不會(huì)產(chǎn)生額外的計(jì)算成本。

因此,重新參數(shù)化策略將可學(xué)習(xí)參數(shù)集成到相鄰?fù)队皺?quán)重中,其可能是有利的,因?yàn)樵谕评黼A段不會(huì)產(chǎn)生額外的計(jì)算成本。

最優(yōu)分層配置的進(jìn)化搜索

對(duì)統(tǒng)一適配器的設(shè)計(jì)是在每層的基礎(chǔ)上實(shí)現(xiàn)的,其允許跨不同層的異構(gòu)性。為了確定每一層的最佳配置,采用了進(jìn)化搜索方法,它提供了效率和有效性的平衡。盡管這種搜索過程會(huì)導(dǎo)致訓(xùn)練時(shí)間的增加,但值得注意的是,現(xiàn)有工作需要進(jìn)行廣泛的超參數(shù)搜索。此外,本文使用權(quán)重共享策略,其中為每個(gè)支持張量定義單個(gè)矩陣,并且根據(jù)分量,對(duì)子矩陣進(jìn)行索引并應(yīng)用于當(dāng)前訓(xùn)練迭代,這允許更好的參數(shù)效率,因?yàn)樽畲蟮臋?quán)重共享是在子網(wǎng)中完成的。

具有更高容量的GLoRA

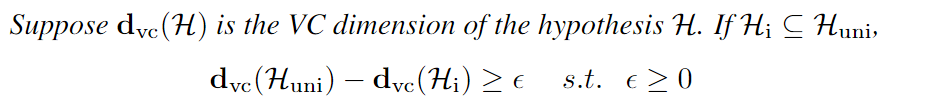

模型能力是指模型近似各種函數(shù)的能力。調(diào)節(jié)學(xué)習(xí)算法的能力的方法包括選擇一個(gè)適當(dāng)?shù)募僭O(shè)空間,本質(zhì)上是一組函數(shù),學(xué)習(xí)算法被允許考慮作為潛在的解決方案。本文使用Vapnik-Chervonenkis維數(shù)(VC維數(shù))進(jìn)行統(tǒng)計(jì)算法的容量和復(fù)雜性的度量。其定義如下所示

實(shí)驗(yàn)

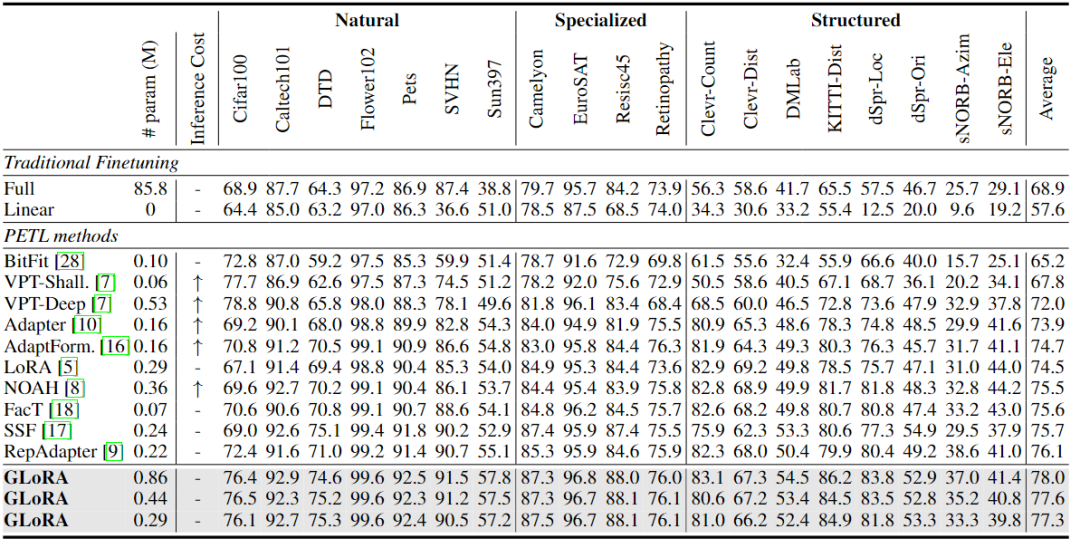

本文在VTAB-1K基準(zhǔn)上對(duì)不同參數(shù)計(jì)數(shù)的GLoRA進(jìn)行了全面評(píng)估。VTAB-1K包括19個(gè)圖像分類任務(wù)。任務(wù)分為三個(gè)領(lǐng)域:自然圖像;由遙感和醫(yī)學(xué)數(shù)據(jù)集組成的專門任務(wù);以及專注于場(chǎng)景結(jié)構(gòu)理解的結(jié)構(gòu)化任務(wù),如深度預(yù)測(cè)和方向預(yù)測(cè)等。為了測(cè)試少鏡頭微調(diào)性能,在五個(gè)細(xì)粒度視覺識(shí)別少鏡頭數(shù)據(jù)集上評(píng)估了GLoRA:Food101、OxfordFlowers102、StandfordCars、OxfordPets和FGVCAircraft。根據(jù)之前的工作,本文評(píng)估了shot為1、2、4、8和16下的結(jié)果。最后,為了展示GLoRA的領(lǐng)域泛化能力,在ImageNet上在shot為16設(shè)置下訓(xùn)練GLoRA,并在ImageNetV2、ImageNet Sketch、ImageNet-a和ImageNet-R上進(jìn)行測(cè)試。

VTAB-1K Dataset

通過訓(xùn)練三種不同的GLoRA超網(wǎng)配置,以改變可訓(xùn)練參數(shù)的數(shù)量。它們之間的區(qū)別僅在于搜索空間中的LoRA維度,該維度在最大模型中為8和4,在中間模型中為4和2,在最小模型中為2。本文方法中增加的參數(shù)靈活性允許在最終模型中進(jìn)行用戶定義的可訓(xùn)練參數(shù)計(jì)數(shù)。VTAB-1k基準(zhǔn)測(cè)試的結(jié)果如下表所示。將最先進(jìn)的參數(shù)有效遷移學(xué)習(xí)提高了2.9%,即使是最小的模型也大大優(yōu)于所有現(xiàn)有方法。值得注意的是,在與至少一個(gè)數(shù)據(jù)集上失敗的所有現(xiàn)有工作相比,GLoRA在數(shù)據(jù)集上表現(xiàn)有競(jìng)爭(zhēng)力,證明了GLoRA的高泛化能力。GLoRA在VTAB-1k基準(zhǔn)測(cè)試中的19個(gè)數(shù)據(jù)集中的14個(gè)數(shù)據(jù)集中顯現(xiàn)出了最優(yōu)的性能,同時(shí)在其余數(shù)據(jù)集上也表現(xiàn)得很有競(jìng)爭(zhēng)力。

Few-shot Learning

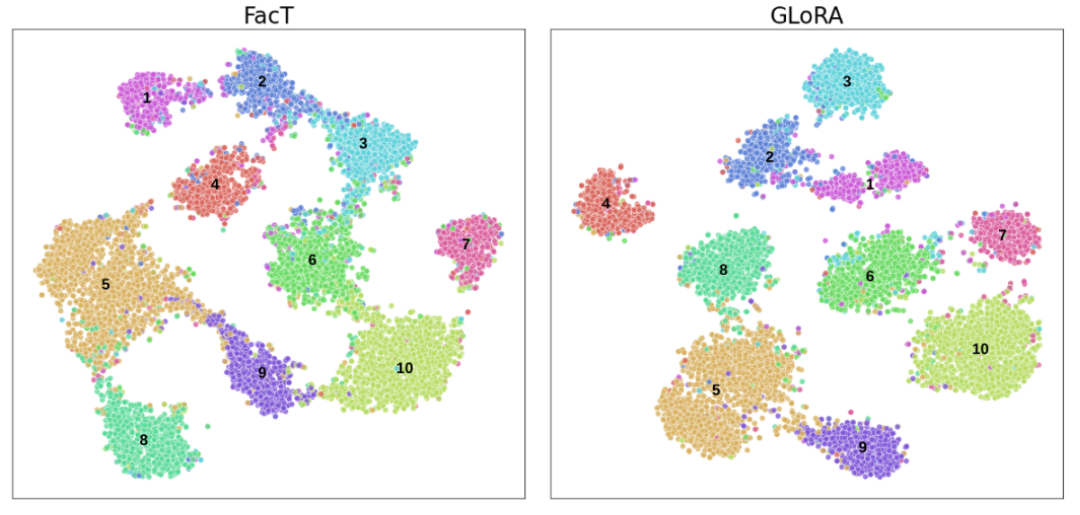

為了在數(shù)據(jù)可用性有限的情況下擴(kuò)展GLoRA的評(píng)估,將GLoRA在細(xì)粒度視覺識(shí)別數(shù)據(jù)集上的性能作為few-shot Learning,并將其與LoRA、Adapter、VPT和NOAH進(jìn)行比較。1、2、4、8和16的shot結(jié)果如下圖所示。GLoRA在大多數(shù)few-shot learning數(shù)據(jù)集中表現(xiàn)出卓越的功效,在參數(shù)計(jì)數(shù)相似的情況下,其性能始終大大優(yōu)于現(xiàn)有方法。有趣的是,在Flowers102數(shù)據(jù)集上,由于已經(jīng)非常出色的整體性能,所有方法都產(chǎn)生了相似的準(zhǔn)確度水平。在Food101數(shù)據(jù)集上,GLoRA的平均準(zhǔn)確度與NOAH相當(dāng)。可以觀察到的第一個(gè)子假設(shè)來看,在較高的shot場(chǎng)景下,平均性能提升變得更加明顯,然而,即使在較低的shot設(shè)置下,效果仍然顯著。

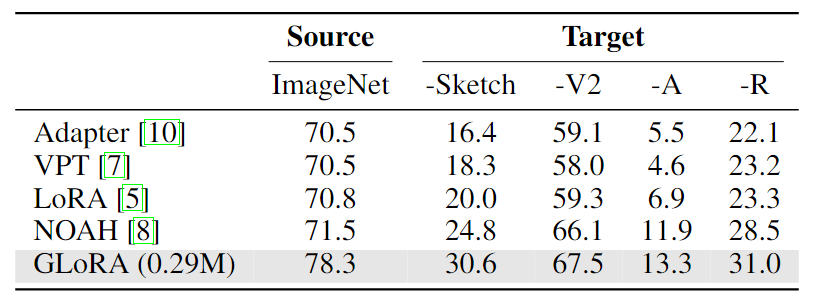

Domain Generalization

域外泛化能力對(duì)于大規(guī)模神經(jīng)網(wǎng)絡(luò)具有重要的價(jià)值。通過PETL方法微調(diào)的模型應(yīng)該表現(xiàn)出增強(qiáng)的域泛化能力,從而使它們更適用于現(xiàn)實(shí)場(chǎng)景。下表展示了GLoRA的域外泛化能力,其中單個(gè)ImageNet-1K微調(diào)的GLoRA模型經(jīng)過域外數(shù)據(jù)集的測(cè)試。與以前的研究對(duì)齊,與現(xiàn)有方法相比,域外性能顯著提高。與LoRA相比,GLoRA提高了100% (ImageNet-A)和50%(ImageNet-Sketch)的域外性能。

總結(jié)

本文提出了GLoRA,這是一種廣義參數(shù)高效的微調(diào)方法,它成功地證明了增強(qiáng)大規(guī)模預(yù)訓(xùn)練模型的微調(diào)和遷移學(xué)習(xí)能力的有效性。通過采用廣義低秩自適應(yīng)和重新參數(shù)化框架,GLoRA減少了微調(diào)所需的參數(shù)數(shù)量和計(jì)算量,使其成為實(shí)際應(yīng)用的資源高效和實(shí)用的方法。在各種任務(wù)和數(shù)據(jù)集上進(jìn)行的實(shí)驗(yàn)證實(shí)了GLoRA優(yōu)于現(xiàn)有的PEFT技術(shù),展示了其可擴(kuò)展性和適應(yīng)性。這項(xiàng)工作不僅有助于改進(jìn)大規(guī)模預(yù)訓(xùn)練模型的微調(diào)過程,而且還為未來的工作開辟了新的途徑,包括進(jìn)一步探索廣義低秩適應(yīng)技術(shù)、混合方法的開發(fā)以及搜索和優(yōu)化算法的改進(jìn)。這些領(lǐng)域的研究可能會(huì)繼續(xù)擴(kuò)大遷移學(xué)習(xí)在更廣泛的應(yīng)用中的可訪問性和效率。

-

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4779瀏覽量

101166 -

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1209瀏覽量

24831 -

自然語言

+關(guān)注

關(guān)注

1文章

291瀏覽量

13398

原文標(biāo)題:GLoRA—高效微調(diào)模型參數(shù)!

文章出處:【微信號(hào):zenRRan,微信公眾號(hào):深度學(xué)習(xí)自然語言處理】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

一種修正的近場(chǎng)聲源定位時(shí)延估計(jì)方法

有沒有一種方法可以在電機(jī)工作臺(tái)中微調(diào)電機(jī)參數(shù)呢?

一種改進(jìn)的LPCC參數(shù)提取方法

一種線性調(diào)頻信號(hào)參數(shù)分析的綜合方法

一種開關(guān)磁阻電機(jī)模型參數(shù)的LS-SVM辨識(shí)方法

PID調(diào)節(jié)器參數(shù)優(yōu)化設(shè)計(jì)的一種改進(jìn)方法

一種廣義運(yùn)動(dòng)模糊模型

一種新的基于電穿孔的皮膚高效核酸遞送方法

介紹一種高效的線云重建算法ELSR

GLoRA—高效微調(diào)模型參數(shù)

一種高效、靈巧的多通信信號(hào)產(chǎn)生方法

四種微調(diào)大模型的方法介紹

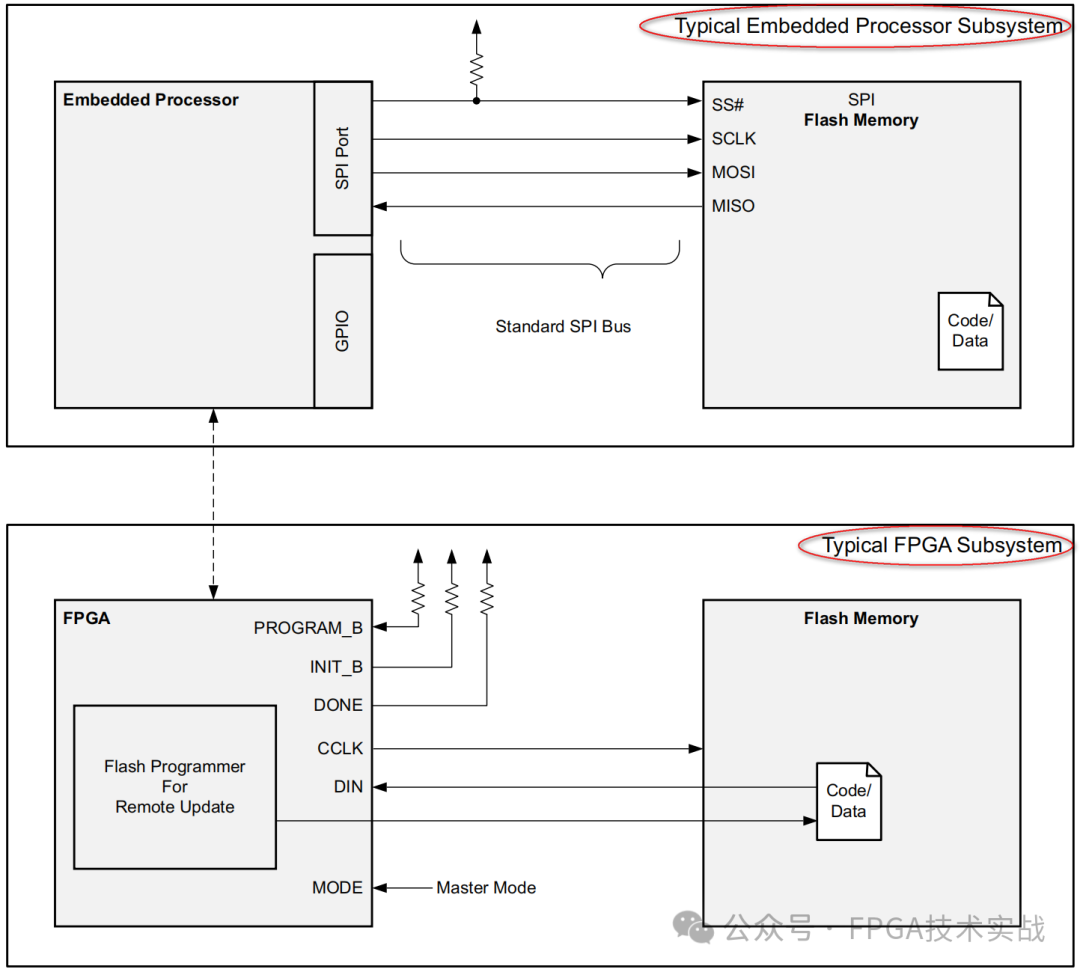

一種簡(jiǎn)單高效配置FPGA的方法

一種信息引導(dǎo)的量化后LLM微調(diào)新算法IR-QLoRA

GLoRA:一種廣義參數(shù)高效的微調(diào)方法

GLoRA:一種廣義參數(shù)高效的微調(diào)方法

評(píng)論