作為 AI 市場(chǎng)中的重要組成,以 GPU、FPGA 等為主的 AI 加速器市場(chǎng)發(fā)展也隨之水漲船高。GPU 資源池化技術(shù)從初期的簡(jiǎn)單虛擬化,到資源池化,經(jīng)歷了四個(gè)技術(shù)演進(jìn)階段。

?簡(jiǎn)單虛擬化。將物理 GPU 按照 2 的 N 次方,切分成多個(gè)固定大小的 vGPU(Virtual GPU,虛擬 GPU),每個(gè) vGPU 的算力和顯存相等。實(shí)踐證明,不同的 AI 模型對(duì)于算力、顯存資源的需求是不同的。所以,這樣的切分方式,并不能滿足 AI 模型多樣化的需求。

?任意虛擬化。將物理 GPU 按照算力和顯存兩個(gè)維度,自定義切分,獲得滿足 AI 應(yīng)用個(gè)性化需求的 vGPU。

?遠(yuǎn)程調(diào)用。AI 應(yīng)用與物理 GPU 服務(wù)器分離部署,允許通過高性能網(wǎng)絡(luò)遠(yuǎn)程調(diào)用 GPU資源。這樣可以實(shí)現(xiàn) AI 應(yīng)用與物理 GPU 資源剝離,AI 應(yīng)用可以部署在私有云的任意位置,只需要網(wǎng)絡(luò)可達(dá),即可調(diào)用 GPU 資源。

?資源池化。形成 GPU 資源池后,需要統(tǒng)一的管理面來實(shí)現(xiàn)管理、監(jiān)控、資源調(diào)度和資源回收等功能。同時(shí),也需要提供北向 API,與數(shù)據(jù)中心級(jí)的資源調(diào)度平臺(tái)對(duì)接,讓用戶在單一界面,就可以調(diào)度包括 vGPU 在內(nèi)的數(shù)據(jù)中心內(nèi)的各類資源。

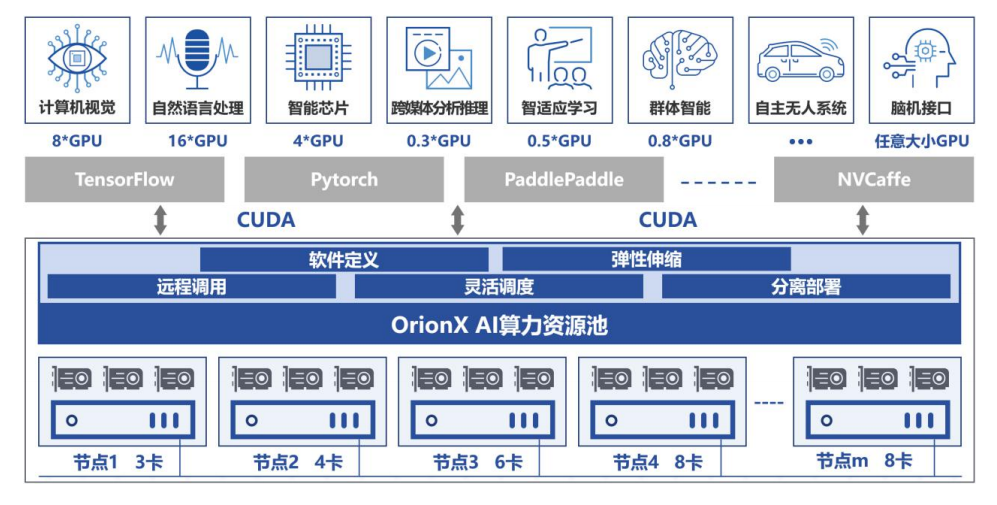

OrionX 通過軟件定義 AI 算力,顛覆了原有的 AI 應(yīng)用直接調(diào)用物理 GPU 的架構(gòu),增加軟件層,將 AI 應(yīng)用與物理 GPU 解耦合。AI 應(yīng)用調(diào)用邏輯的 vGPU,再由 OrionX 將 vGPU需求匹配到具體的物理 GPU。OrionX 架構(gòu)實(shí)現(xiàn)了 GPU 資源池化,讓用戶高效、智能、靈活地使用 GPU 資源,達(dá)到了降本增效的目的。

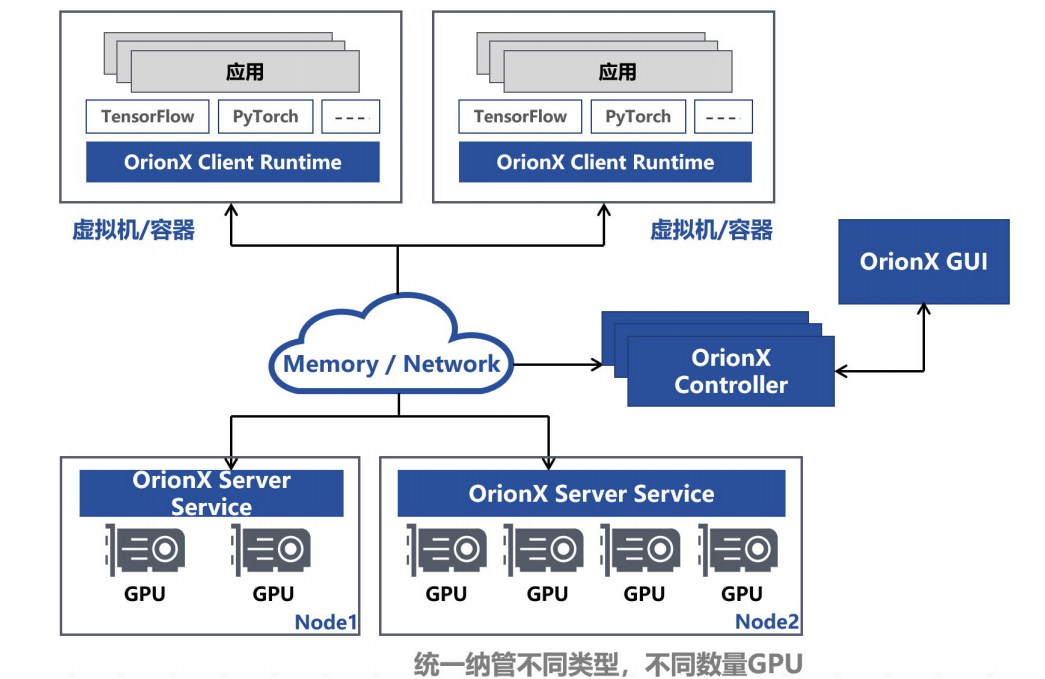

一個(gè)典型的 OrionX GPU 資源池的邏輯架構(gòu)中包含了 OrionX Controller(OC)、OrionX Server Service(OSS)、OrionX Client Runtime(OCRT)、和 OrionX GUI(OG)等功能組件。

OrionX 的各功能組件可以根據(jù)用戶環(huán)境需求被部署在單服務(wù)器上,也可以被分布式地部署在數(shù)據(jù)中心的多個(gè)物理機(jī)、虛擬機(jī)或者容器環(huán)境中。在分布式的部署環(huán)境中,各功能組件可以通過多種類型的網(wǎng)絡(luò)建立連接,從而把數(shù)據(jù)中心的 GPU 資源管理起來,形成一種可以被全局共享的計(jì)算資源,對(duì) AI 應(yīng)用提供可遠(yuǎn)程訪問的、可靈活切分的、可聚合的彈性 GPU算力。OrionX 的邏輯架構(gòu)如下圖所示。

CUDA是由 Nvidia 公司定義且公開推廣、維護(hù)的一種 GPU 編程接口。從 2007 年推出之后,經(jīng)過十幾年生態(tài)培育,已經(jīng)成為 GPU 編程的一個(gè)事實(shí)標(biāo)準(zhǔn)。大部分流行的 AI 框架,例如 TensorFlow、PyTorch、MXNet 和 PaddlePaddle都是基于 CUDA 編程接口開發(fā)。

OrionX 在管理物理 GPU 之后,通過模擬 CUDA 標(biāo)準(zhǔn)接口,為各種 AI 應(yīng)用提供一個(gè)與 Nvidia CUDA SDK 接口功能一致的運(yùn)行環(huán)境,從而使得 AI 應(yīng)用透明無感知地運(yùn)行在 OrionX GPU資源池之上。OrionX 不僅在單服務(wù)器上模擬了 CUDA 標(biāo)準(zhǔn)接口,并且通過分布式部署各功能組件,能夠提供分布式的 CUDA 運(yùn)行環(huán)境。

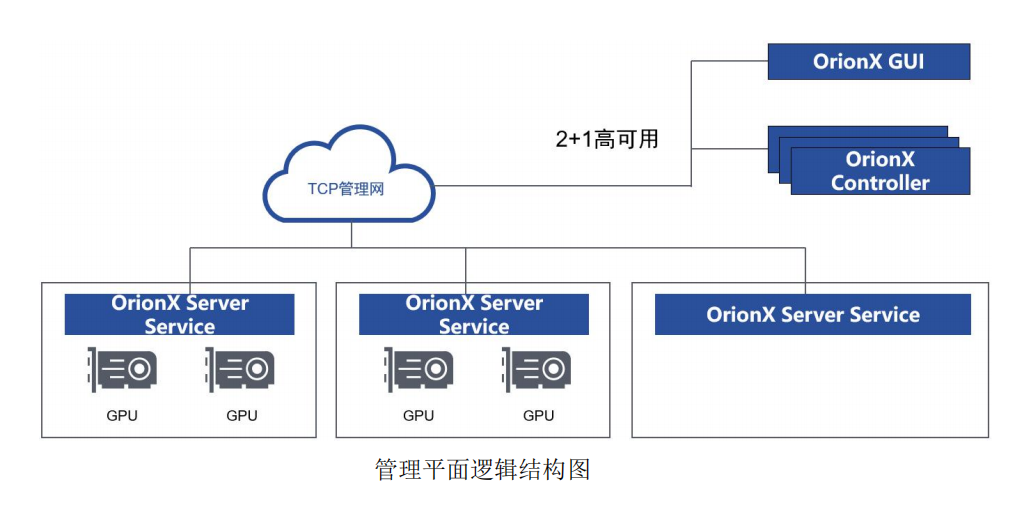

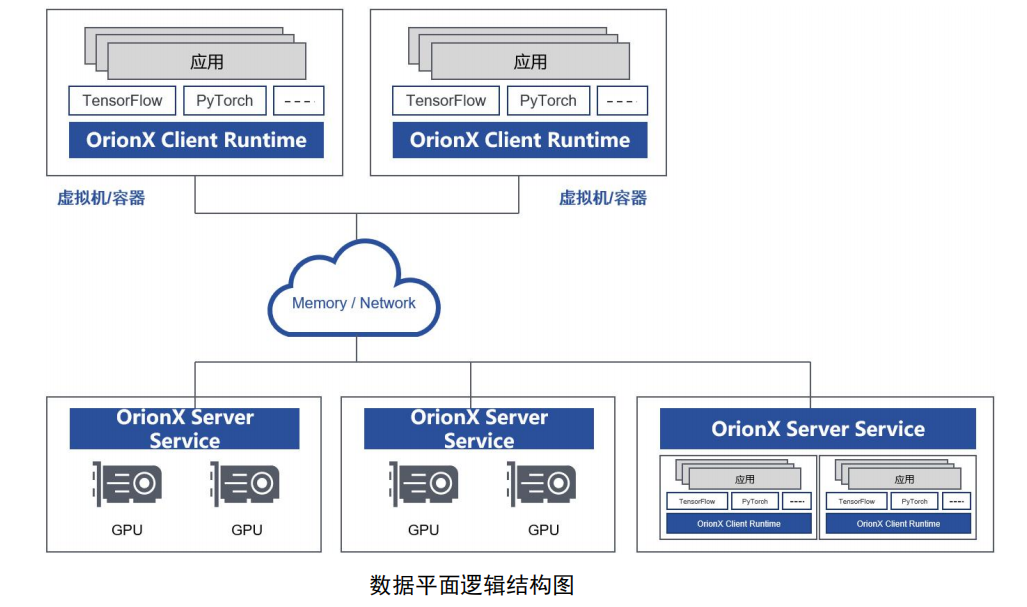

OrionX 的各個(gè)功能組件通過管理平面網(wǎng)絡(luò)和數(shù)據(jù)平面網(wǎng)絡(luò)進(jìn)行通信,共同完成 GPU 資源池的管理以及 GPU 資源的調(diào)度等功能。

在部署 OrionX 時(shí),使用基于 TCP/IP 網(wǎng)絡(luò)的管理平面,來承載整個(gè)系統(tǒng)的管理工作。通過管理網(wǎng)絡(luò),分布在各個(gè)節(jié)點(diǎn)的功能組件都保持和 OrionX Controller 同步。管理平面邏輯結(jié)構(gòu)如下圖所示。

在應(yīng)用運(yùn)行的過程中,應(yīng)用所在環(huán)境和 GPU 物理節(jié)點(diǎn)之間的數(shù)據(jù)傳輸使用的是 OrionX 的數(shù)據(jù)面。該數(shù)據(jù)面支持多種后端數(shù)據(jù)傳輸載體,包括 TCP/IP 以太網(wǎng)絡(luò)、RoCE RDMA、Infiniband RDMA、Share Memory 等。具備高帶寬、低延遲。同時(shí)支持多種傳輸協(xié)議,根據(jù)優(yōu)先級(jí)自動(dòng)使用高性能的傳輸方式。支持虛擬機(jī)、容器和宿主機(jī)之間的 TCP/IP 網(wǎng)絡(luò)隔離。

OrionX 的各個(gè)組件,支持直接部署在裸金屬服務(wù)器上,即安裝操作系統(tǒng)后,直接以 Binary形式部署,也支持容器化部署。OrionX 具備適配多種 Linux 操作系統(tǒng)和云平臺(tái)的能力,因此,OrionX 具有多樣化的部署形式。

OrionX 支持 CentOS、Ubuntu、Debian 等 Linux 發(fā)行版本,同時(shí)支持基于 KVM 的虛擬機(jī)云平臺(tái)和基于 Docker 的容器云平臺(tái)。尤其是支持原生容器,并實(shí)現(xiàn)了和 Kubernetes 的平滑對(duì)接。

-

FPGA

+關(guān)注

關(guān)注

1630文章

21797瀏覽量

606019 -

服務(wù)器

+關(guān)注

關(guān)注

12文章

9304瀏覽量

86066 -

AI芯片

+關(guān)注

關(guān)注

17文章

1906瀏覽量

35216

原文標(biāo)題:OrionX AI芯片計(jì)算資源池化技術(shù)

文章出處:【微信號(hào):AI_Architect,微信公眾號(hào):智能計(jì)算芯世界】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

NanoEdge AI的技術(shù)原理、應(yīng)用場(chǎng)景及優(yōu)勢(shì)

AI發(fā)展對(duì)芯片技術(shù)有什么影響?

平頭哥劍池CDK 更新重磅來襲!三大亮點(diǎn)速看!

OpenHarmony3.1 Release版本特性解析——OpenHarmony硬件資源池化架構(gòu)介紹

電力云資源池的建立

華為視頻云平臺(tái)通過云技術(shù)實(shí)現(xiàn)計(jì)算、網(wǎng)絡(luò)、存儲(chǔ)資源池化

OpenHarmony硬件資源池化模型

內(nèi)存池主要解決的問題

池化技術(shù)的應(yīng)用實(shí)踐

優(yōu)刻得與聯(lián)想AI實(shí)驗(yàn)室攜手共建高效AI資源池

打造異構(gòu)計(jì)算新標(biāo)桿!國數(shù)集聯(lián)發(fā)布首款CXL混合資源池參考設(shè)計(jì)

OrionX AI芯片計(jì)算資源池化技術(shù)

OrionX AI芯片計(jì)算資源池化技術(shù)

評(píng)論