這是我最近才看到的一篇論文,它提出了動(dòng)態(tài)ReLU (Dynamic ReLU, DY-ReLU),可以將全局上下文編碼為超函數(shù),并相應(yīng)地調(diào)整分段線(xiàn)性激活函數(shù)。

與傳統(tǒng)的ReLU相比,DY-ReLU的額外計(jì)算成本可以忽略不計(jì),但表示能力明顯增強(qiáng),并且實(shí)現(xiàn)簡(jiǎn)單,所以可以非常簡(jiǎn)單的對(duì)我們現(xiàn)有的模型進(jìn)行修改。

Dynamic ReLU (DY-ReLU)

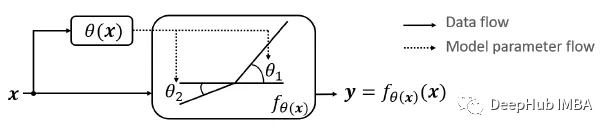

對(duì)于給定的輸入向量(或張量)x,DY-ReLU被定義為具有可學(xué)習(xí)參數(shù)θ(x)的函數(shù)fθ(x)(x),該參數(shù)適應(yīng)于輸入x,它包括兩個(gè)功能:

超函數(shù)θ(x):用于計(jì)算激活函數(shù)的參數(shù)。

激活函數(shù)fθ(x)(x):使用參數(shù)θ(x)生成所有通道的激活。

1、函數(shù)定義

設(shè)傳統(tǒng)的或靜態(tài)的ReLU為y = max(x, 0)。ReLU可以推廣為每個(gè)通道c的參數(shù)分段線(xiàn)性函數(shù)。

其中coeffcients ( akc , bkc )是超函數(shù)(x)的輸出,如下:

其中K是函數(shù)的個(gè)數(shù),C是通道的個(gè)數(shù)。論文中K=2。

2、超函數(shù)θ(x)的實(shí)現(xiàn)

使用輕量級(jí)網(wǎng)絡(luò)對(duì)超函數(shù)進(jìn)行建模,這個(gè)超函數(shù)類(lèi)似于SENet中的SE模塊(稍后會(huì)介紹)。

輸出有2KC個(gè)元素,對(duì)應(yīng)于a和b的殘差。2σ(x)-1用于對(duì)-1到1之間的殘差進(jìn)行歸一化,其中σ(x)表示s型函數(shù)。最終輸出計(jì)算為初始化和殘差之和,如下所示:

其中λ是標(biāo)量,這個(gè)公式也就是我們上面的圖

3、與先前研究的關(guān)系

可以看到DY-ReLU的三種特殊情況相當(dāng)于ReLU、Leaky ReLU和PReLU。

4、DY-ReLU的變體

DY-ReLU-A:激活函數(shù)是空間和通道共享的。

DY-ReLU-B:激活函數(shù)是空間共享和通道相關(guān)的。

DY-ReLU-C:激活的是空間和通道分開(kāi)的。

結(jié)果展示

1、消融研究

所有三種變化都比基線(xiàn)有所改善,但通道分開(kāi)的DY-ReLU(變化B和C)明顯優(yōu)于通道共享的DY-ReLU(變化A)。

所以根據(jù)上面結(jié)果,使用DY-ReLU-B進(jìn)行ImageNet分類(lèi),使用DY-ReLU-C進(jìn)行COCO關(guān)鍵點(diǎn)檢測(cè)。

2、ImageNet分類(lèi)

使用MobileNetV2 (×0.35和×1.0), 用不同的激活函數(shù)代替ReLU。所提出的方法明顯優(yōu)于所有先前的工作,包括具有更多計(jì)算成本的Maxout。這表明DY-ReLU不僅具有更強(qiáng)的表示能力,而且計(jì)算效率高。

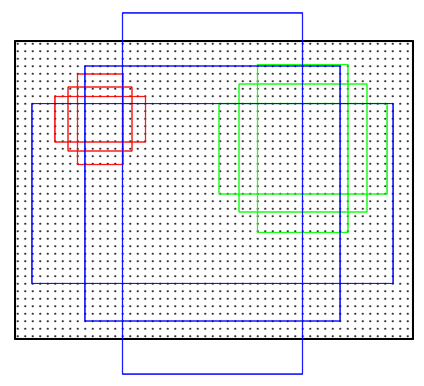

上圖繪制了5萬(wàn)張驗(yàn)證圖像在不同區(qū)塊(從低到高)的DY-ReLU輸入輸出值。可以看到學(xué)習(xí)到的DY-ReLU在特征上是動(dòng)態(tài)的,因?yàn)閷?duì)于給定的輸入x,激活值(y)在一個(gè)范圍內(nèi)(藍(lán)點(diǎn)覆蓋的范圍)變化。

下圖分析DY-ReLU中兩段之間的夾角(即斜率差|a1c-a2c|)。激活函數(shù)在較高水平上具有較低的彎曲。

3、COCO關(guān)鍵點(diǎn)估計(jì)

當(dāng)使用MobileNetV3作為骨干時(shí),刪除SENet模塊,使用DY-ReLU替代ReLU和h-Swish后,結(jié)果也有提高。

總結(jié)

可以看到,只是使用DY-ReLU替換現(xiàn)有的激活函數(shù),模型的表現(xiàn)明顯優(yōu)于基線(xiàn)模型。

-

編碼器

+關(guān)注

關(guān)注

45文章

3668瀏覽量

135245

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

AI模型部署邊緣設(shè)備的奇妙之旅:目標(biāo)檢測(cè)模型

【NanoPi K1 Plus試用體驗(yàn)】深度學(xué)習(xí)---快速開(kāi)始序貫(Sequential)模型

Keras可視化神經(jīng)網(wǎng)絡(luò)架構(gòu)的4種方法

bottom-up多層規(guī)約圖融合策略資料介紹

深度學(xué)習(xí)在醫(yī)學(xué)圖像分割與病變識(shí)別中的應(yīng)用實(shí)戰(zhàn)

【KV260視覺(jué)入門(mén)套件試用體驗(yàn)】Vitis AI 通過(guò)遷移學(xué)習(xí)訓(xùn)練自定義模型

技嘉 主板Dynamic Energy Saver動(dòng)態(tài)節(jié)能工

一種基于對(duì)抗訓(xùn)練的圖像翻譯技術(shù),為裸女們自動(dòng)“穿”上比基尼

深度ReLU網(wǎng)絡(luò)的訓(xùn)練動(dòng)態(tài)過(guò)程及其對(duì)泛化能力的影響

在PyTorch中使用ReLU激活函數(shù)的例子

RPN:Region Proposal Networks (區(qū)域候選網(wǎng)絡(luò))

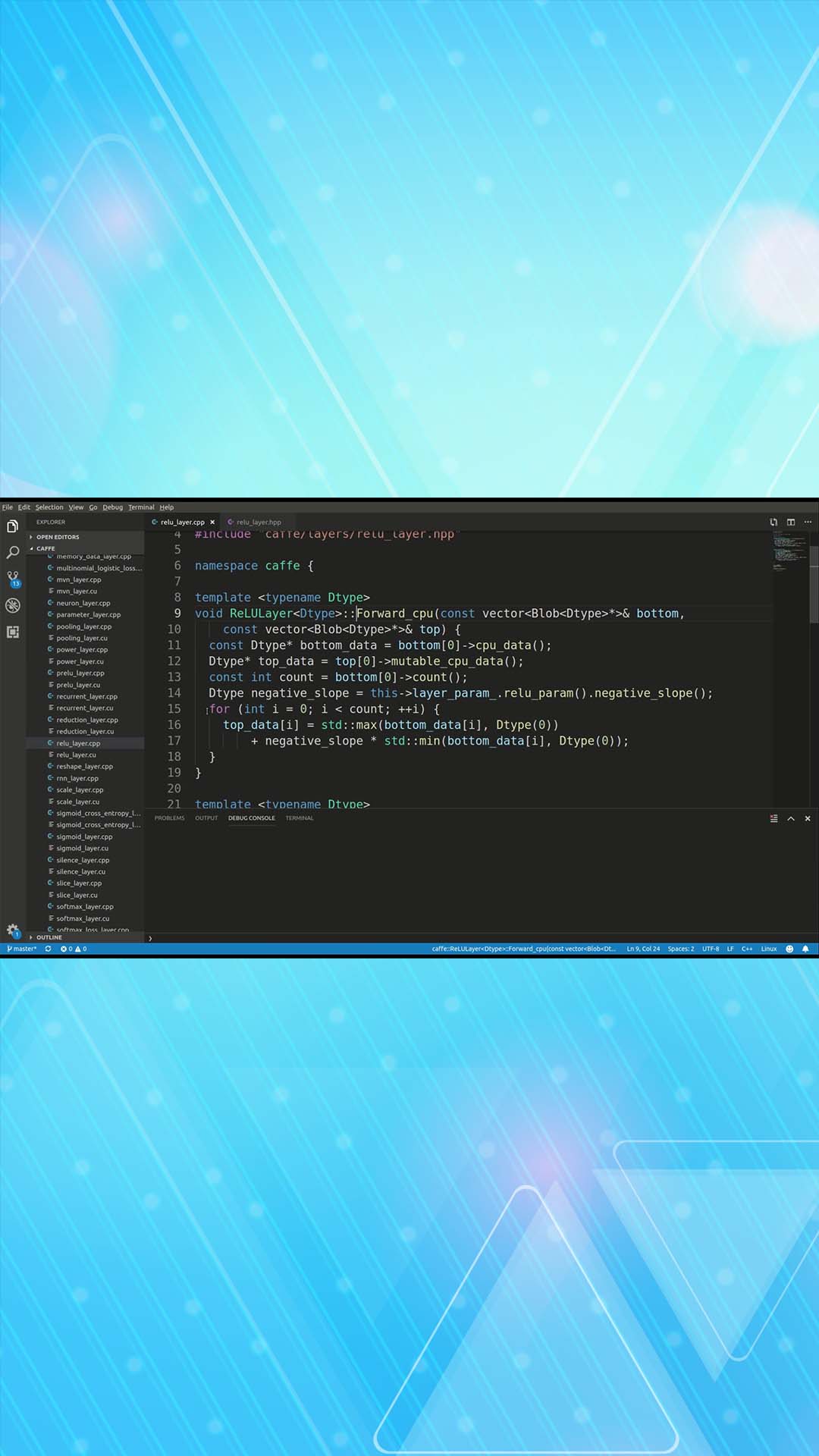

Relu算子的介紹

結(jié)合卷積層來(lái)創(chuàng)建一個(gè)完整的推理函數(shù)

深度ReLU網(wǎng)絡(luò)的對(duì)應(yīng)淺層網(wǎng)絡(luò)

Dynamic ReLU:根據(jù)輸入動(dòng)態(tài)確定的ReLU

Dynamic ReLU:根據(jù)輸入動(dòng)態(tài)確定的ReLU

評(píng)論