大語言模型(LLM)在諸多領域都取得了矚目的成就,然而,也存在兩個主要的挑戰:

- 訓練成本極高,通常只有少數幾家大公司才能負擔得起。

- 現行的評估基準主要依賴知識評估(如MMLU和C-Eval)以及NLP任務評估,但這種方式存在局限性,并且容易受到數據污染的影響。

近期,一支來自中國的研究團隊正是針對這些問題提出了解決方案,他們推出了FLM-101B模型及其配套的訓練策略。FLM-101B不僅大幅降低了訓練成本,而且其性能表現仍然非常出色,它是目前訓練成本最低的100B+ LLM。

下面我們就來深入探討他們是如何實現這一目標的吧!

Paper: FLM-101B: An Open LLM and How to Train It with $100K Budgets

Link: https://arxiv.org/pdf/2309.03852.pdf

Model: https://huggingface.co/CofeAI/FLM-101B進NLP群—>加入NLP交流群

摘要

本篇研究的兩大核心亮點為:

- 增長策略:該策略賦予了LLM一個獨特的訓練方式,它可以從較小規模動態增長到較大規模,而不僅僅是在一開始就確定其大小。這不僅能夠保持在初期階段已學到的知識,更重要的是,它大大降低了整體的計算成本。

- IQ評估基準:該團隊還提出了一個新的評估標準IQ benchmark,包含了符號映射、規則理解、模式挖掘和抗干擾能力這四個關鍵維度,從多方面對LLM的能力進行了全面深入的評估。

增長策略詳解

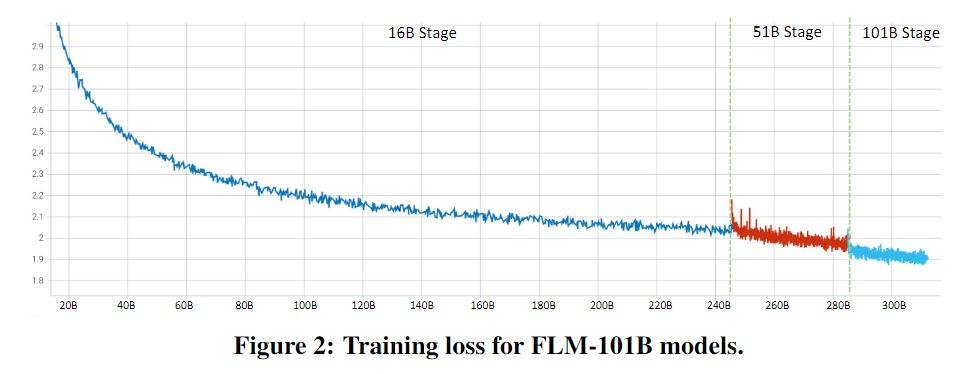

與獨立訓練不同規模的模型的常規做法不同,在FLM-101B的訓練過程中該項目團隊按照16B、51B和101B參數的順序連續訓練了三個模型,每個模型都從其較小的前身那里繼承了知識。

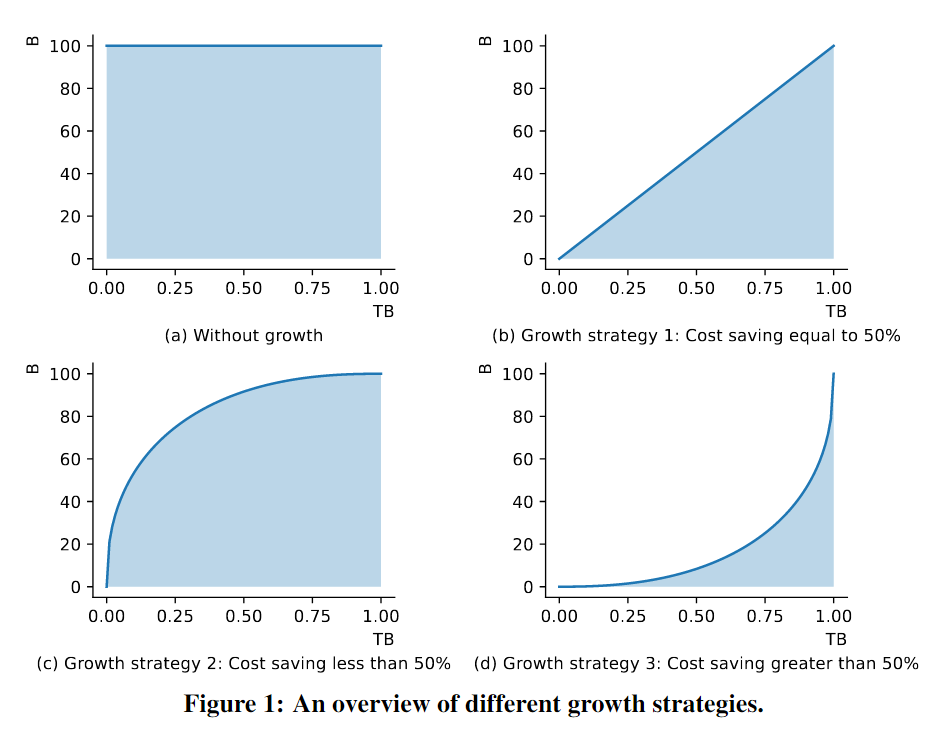

下圖揭示了利用增長策略在三種典型場景中實施LLM訓練的計算成本變化。在這里,我們依據一個基本原則:LLM的FLOPs與參數數量近似成正比,使我們可以通過觀察模型參數變化曲線下的面積來估算訓練的計算成本。

- 圖(a) 一個標準的訓練策略,其中沒有實施模型的動態增長,從而導致訓練計算成本相對較高。

- 圖(b) 一個線性增長策略的應用,其結果是計算成本得以減少近50%。

- 圖(c) 一個適度的增長策略,雖然它未能將成本降低到50%,但仍然實現了可觀的成本節約。

- 圖(d) 一種更為積極的增長策略,它成功地將計算成本降低了超過50%,揭示了這種策略在減少訓練成本方面的巨大潛力。

在LLM增長前后,模型始終給出任意輸入的一致輸出。這個屬性對于知識繼承和訓練穩定性都是有利的。為了適應多節點3D并行框架,團隊通過離線擴展模型結構,并在下一個階段開始時重新加載檢查點來實現這一點。

增長策略具體設置

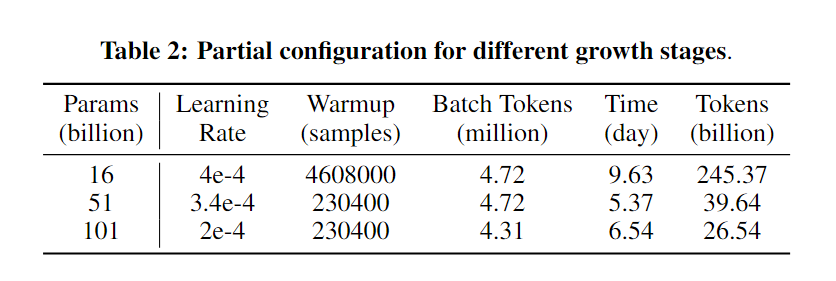

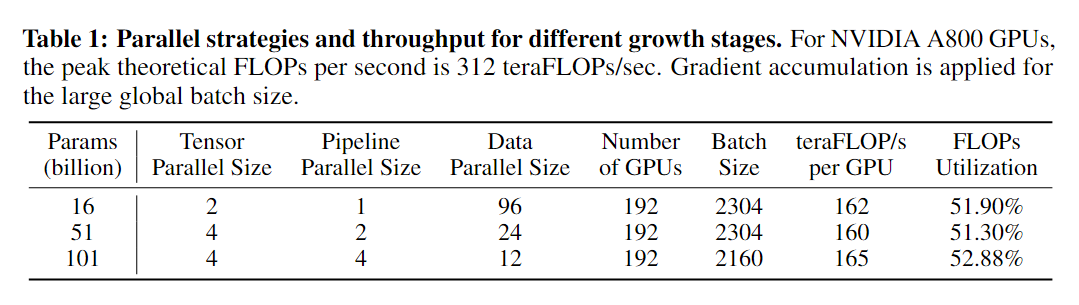

規劃模型增長是一個需要權衡不同大小模型固有優缺點的過程:較小的模型在計算每個訓練步驟時更快,能夠更快地消耗訓練數據來獲取更廣泛的常識知識;反之,較大的模型更擅長于減少每步的損失,顯示出對細微的語言模式有更深的理解,該團隊使用245.37B個令牌來訓練16B模型,39.64B個令牌來訓練51B模型,以及26.54B個令牌來訓練101B模型。不同大小的每天數十億令牌的使用情況詳見下表。

在這種增長時間表下,101B模型的總時間成本是21.54天,這比從頭開始訓練一個101B模型(需要47.64天)節省了54.8%的時間,相當于2.2倍的加速。

不同階段的性能評估

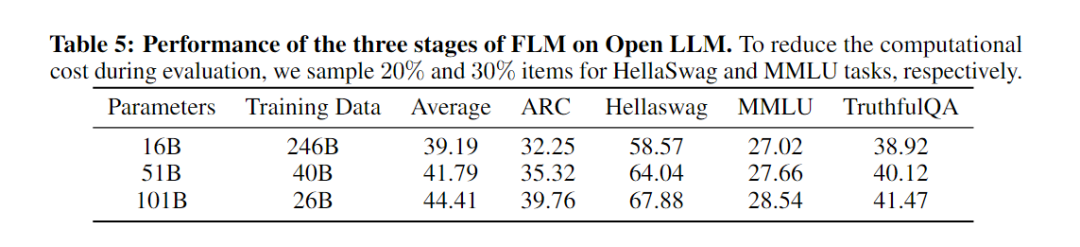

研究成員對FLM在所有階段(包括16B、51B和101B)的性能進行了評估。每個階段的訓練數據分別是0.246TB、0.04TB和0.026TB。下表呈現了各階段FLM模型的表現。

結果顯示,FLM的性能確實隨著模型大小的增加而提高,這符合預期。FLM-101B在幾乎所有任務上都實現了最佳性能,這意味著模型能夠在每次增長后從先前的階段繼承知識。他們還發現101B模型在使用較少樣本的情況下比51B模型有更顯著的性能提升。這表明模型在增長后的訓練中成功地加入了新的權重,并在損失較低時利用了模型大小的優勢。有趣的是,ARC和HellaSwag的表現也持續并顯著增加。因此,可以預見,隨著處理更多的訓練數據,FLM-101B在開放LLM上的性能將大大提高,除了在MMLU上,因為它與特定的領域有關。

FLM主要結構和其他技術細節

Backbone

選擇FreeLM作為基礎架構主要是為了實現高效的長序列建模,此中采用了可外推的位置嵌入(xPos)來增強模型的長度外推能力。該技術受到了RoPE原理的啟發,并在旋轉矩陣中引入了指數衰減來實現目標。同時,模型保留了GPT和FreeLM的變換器塊設計,并采用了來自GPT-4的分詞器,以支持更大的詞匯量。

預訓練

FLM-101B延續了FreeLM的訓練策略,結合了受語言信號指導的語言建模目標和受教師信號指導的二元分類目標。但是當模型規模擴大超過16B時,它開始展示出訓練不穩定的問題。為了克服這一問題,研究團隊采用了一個統一的目標,它通過使用一種掩碼策略和兩個專用令牌來同時處理教師和語言信號。這些令牌協助將二元分類目標轉化為一個語言建模格式。

在大規模的無監督文本語料庫中,該模型遵循GPT系列的訓練目標,即最大化token預測的可能性。FLM-101B是一個英漢雙語模型,它在語言建模中將英語和漢語語料庫按約53.5:46.5的比例混合。在預訓練階段,作者整合了OIG和COIG多任務教育提示數據。

在命題判斷任務中,原始的FreeLM教師目標旨在最小化二元分類的交叉熵。在FLM-101B的訓練過程中,這一二元分類已轉化為自回歸語言模型形式。具體來說,它利用兩個emoji和來代替原來的1和0二進制標簽,通過對命題中的令牌應用零掩蔽來計算損失,并在每個命題的結尾預測這兩個特殊令牌中的一個。這種方法成功地統一了教師目標和語言建模目標。此外,該模型摒棄了FreeLM的迭代訓練方法,轉而在每批數據中完全混合兩種信號的樣本,從而增強了數據采樣分布的一致性,并提高了訓練的穩定性。

需要注意的是,由于計算資源的限制,教師信號僅應用于eFLM-16B版本。

實驗配置

FLM-101B 在 24 個 DGX-A800 GPU (8×80G) 服務器的集群上進行訓練,持續不到 26 天。基于增長策略依次完成了該集群上大小為 16B、51B 和 101B 的模型訓練。

數據并行和張量模型并行已成為訓練十億規模模型的標準方法。然而,過多的張量并行可能會加劇GPU通信開銷,影響訓練效率。為了解決這個問題,研究整合了管道模型并行,并采用了3D并行策略來實現最優的吞吐量。此外,通過采用序列并行,沿著序列長度維度切分了輸入到Transformer核心的LayerNorm和Dropout層,從而進一步節省了GPU計算資源和內存利用率。Megetron-LM 4牙杯用來實現分布式優化器來進一步減少GPU內存消耗,這是一種可以在數據并行排名中均勻分配優化器狀態的技術。

訓練的穩定性

超過100B參數的模型在訓練過程中通常會遇到一系列穩定性問題,這包括損失發散、梯度爆炸和數值的溢出或下溢。這不僅大大增加了尋找合適的超參數(例如最優學習率)的難度,還增加了訓練過程中需要持續監控和維護的需求,如問題解決、數據調整和重啟等,使項目預算變得不可預測。不過,研究團隊找到了一個有前途的解決方案來減輕這些問題。

他們基于Tensor Programs理論來預測損失,該理論揭示了一系列與模型訓練動態相關的通用關系,尤其是在模型寬度趨向于無限的情況下。這產生了一個參數化的映射,可以用于找到小模型及其更大對應模型之間某些超參數的最優值,這被稱為μP。這個理論提供了兩個重要見解:

- “更寬更好”的原則表明,在μP指導下,更寬的模型在處理相同的數據時會產生比其更窄的版本更低的損失。這意味著如果一個窄模型可以收斂,那么其更寬的版本也將會收斂。

- 他們還指出可以使用小模型的損失來預測大模型的損失值,這一點在GPT-4技術報告中得到了表述,并且在開源社區也有μScaling項目驗證了這一點,它結合μP和修改后的縮放規則來實現損失預測。

為了實現訓練穩定性,研究團隊在FLM-16B訓練開始前確定了數據分布,然后對三個超參數(學習率、初始化標準偏差和輸出層的softmax溫度)進行了網格搜索。這個搜索是通過運行一個有40M代理模型完成的,該模型具有較小的隱藏狀態維度和頭部數量。網格搜索找到了最優的超參數組合,而這些參數隨后被應用到更大的16B模型上,確保了一個無不穩定的順利訓練體驗。

借助μP和特定的增長策略,他們成功地避免了在FLM-51B和FLM-101B中的增長后分歧問題,從而實現了一個有效且穩定的訓練過程。

模型初步評估

與開源模型的對比

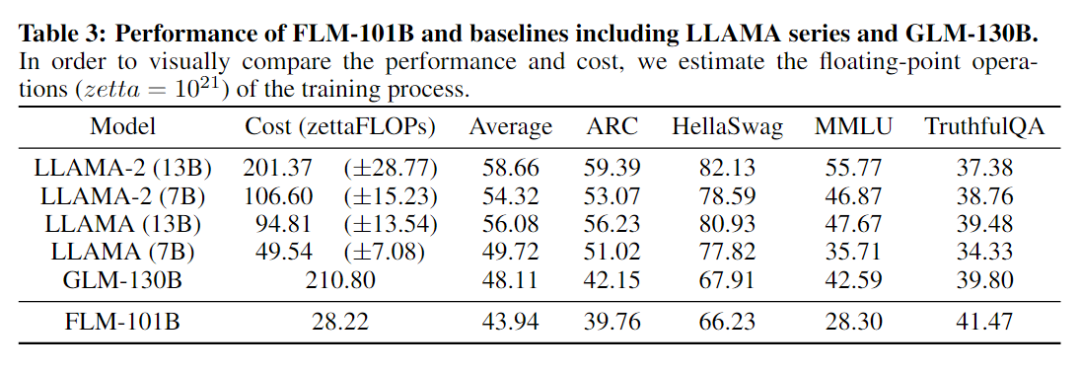

考慮了ARC-Challenge, HellaSwag, MMLU, and TruthfulQA四個數據集,和目前的開源模型進行了對比,性能如下:

在所有基線模型中,FLM-101B的平均得分為43.94,排名最低。然而,深入探究這些任務的本質可以發現,這并不表明模型的表現較差。

MMLU任務通常需要特定領域的知識來解答。考慮到FLM-101B的訓練數據中并沒有特意加入任何教科書或考試題目,所以其取得的分數是合理的。一個直接證明是,在一個結合了FreeLM目標并包含這種知識的FLM變體(eFLM-16B,見第4.3節)中,即使是一個16B的模型也能超越GLM-130B的表現。

TruthfulQA、ARC和HellaSwag更強調常識和維基級別的知識,它們的表現隨著數據量和訓練損失的增加而提高。盡管FLM-101B只使用了不到0.16TB的英文數據(大約是LLAMA-2的1/10),但它仍然在所有基線中獲得了最高的41.47的準確度。在ARC和HellaSwag上,FLM-101B與GLM-130B有相似的英文數據量(約0.2TB)并且表現相當。此外,GLM-130B的訓練數據包括ARC和Hellaswag。

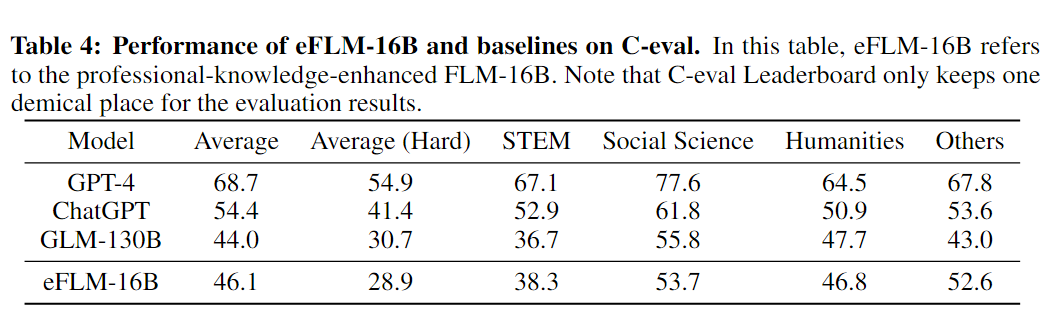

引入專業知識后的再評估

研究團隊決定在FLM訓練過程中引入專業知識數據來增強其效果,通過將FreeLM目標和專業數據相結合,以加強FLM-16B的效能。這種增強的數據源包括部分MMLU輔助訓練集,一些與C-Eval測試有相似域和格式的考試題目,以及其他領域的知識數據。通過這種方式創建的模型被命名為eFLM-16B。

一個明顯的發現是,引入相關領域的專業知識數據可以顯著提升MMLU和C-Eval的分數。具體來說,在這兩項任務中,eFLM-16B的表現都超過了GLM-130B,提高了約2個百分點。

這個結果驗證了一個重要的觀點:僅僅依靠數據集的分數是不能全面反映語言模型的智能水平的,因為特定訓練數據的影響可能是巨大的,而不是反映模型的綜合能力。這表明,在評估語言模型的智能時,不能只依賴于特定的數據集得分來判斷,而應該考慮一個更全面的評估方法來確保模型的智能是全面和多元的。

在IQ基準上的評估

符號映射

最新的研究表明,在處理特定類別的文本分類任務時(比如將文檔或情感進行分類),現有方法常常難以泛化。這主要是因為很多可以公開獲取的網站包含了大量用于訓練的、帶有標簽的原始語言文本數據集,如SemEval、IMDB和Yelp 6。這導致了模型傾向于過度擬合標簽的語義,而非從全新的上下文中推斷它們的含義。

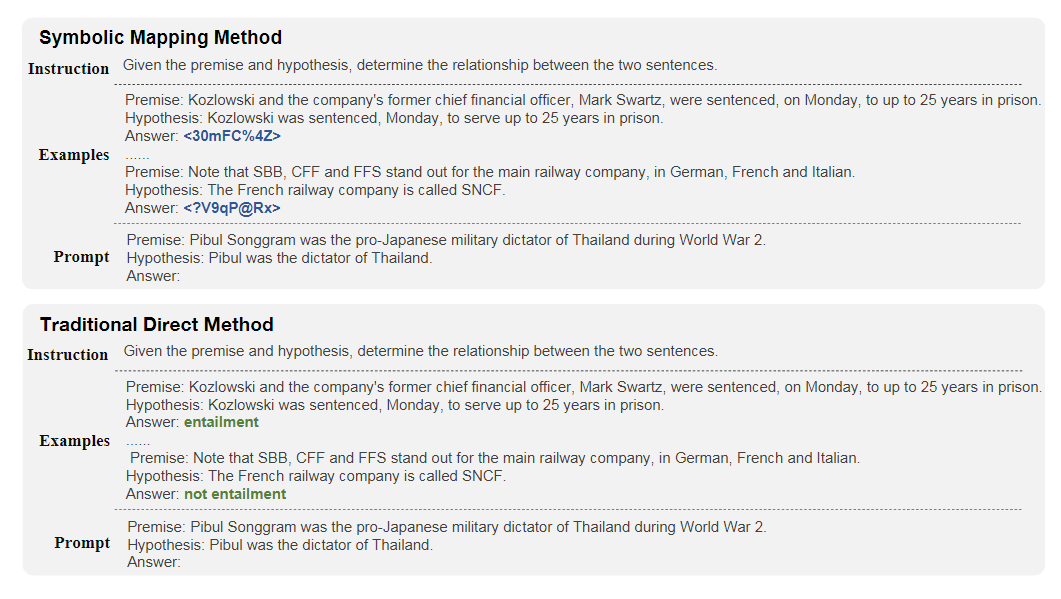

為了解決這個問題,研究者將原始類別標簽替換為在訓練數據中不太可能見到的emoji,來測試模型的真正理解能力和泛化能力。這種做法也把評估任務變得更加側重于上下文學習。下圖是一個符號映射的例子。

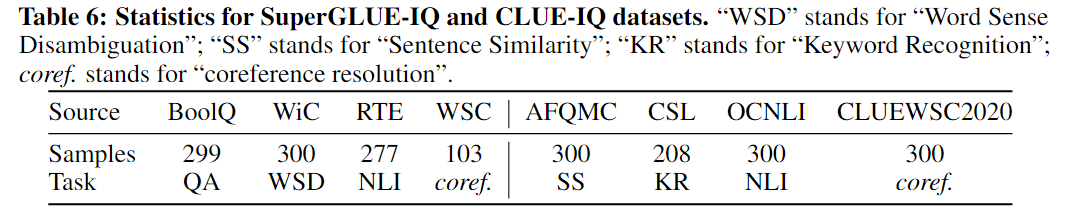

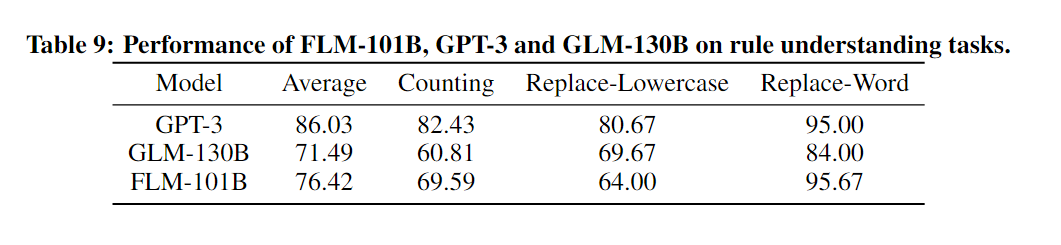

研究者還開創了一種新的IQ基準測試方式。他們利用了已有的基準數據源,例如SuperGLUE和CLUE,并對其中最多300個樣本的原始類別進行了隨機字符串替換。下圖是模型在該基準上的評估結果。

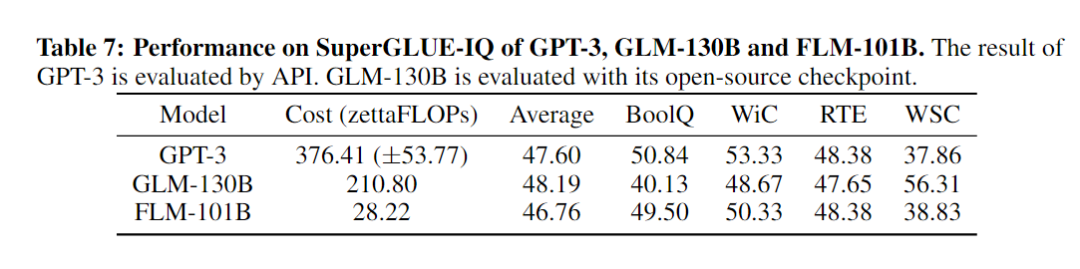

在進行BoolQ、WiC和RTE這些任務測試時,FLM-101B模型和GPT-3的表現非常相似,并且都比GLM-130B表現更好。尤其是在BoolQ任務上,它們的表現比GLM-130B高出9個百分點。但在WSC任務中,GLM-130B表現最佳,領先其他模型18個百分點,這歸功于它的雙向結構,這使得它在處理共指解析任務時更有優勢。值得注意的是,盡管FLM-101B的計算成本只有GPT-3的1/13,但其表現卻相當不錯。

在CLUE-IQ基準測試中,FLM-101B表現最好,得分高達42.07。它特別在AFQMC、CSL和CLUEWSC2020等任務上表現出色,這顯示了該模型在處理中文任務時具有出色的能力。有意思的是,它在中文的WSC任務上勝過GLM-130B,但在英文版上卻稍遜一籌。這揭示了中英兩種語言之間存在的巨大差異。綜上所述,FLM-101B不僅在中文IQ測試中表現突出,其成本效益比也相當顯著,只需要GLM-130B的大約12%的成本就能實現更優秀的表現。

規則理解

理解并按照給定規則執行是衡量人類智能的一個基本方面。為了評估這種理解能力,研究團隊設計了一個規則理解評估測試。這個測試與基于思維鏈的推理測試有所不同;它更側重于理解簡單規則并做出正確行動,而不是推理能力。例如,“計數數字序列”是規則理解評估的一個典型任務,而在模型實現這種基本的規則理解能力之前,它是不能完成基于思維鏈的逐步推理的。

此外,還有一些具體任務來深入評估這一能力,包括無提示計數和字符串替換任務。在無提示計數任務中構建了一個包含150個項目的數據集,一個典型的示例是提示從一個數到另一個數進行計數,如“從10010數到10035:10010,10011,10012,...”。

而字符串替換(4次嘗試)任務則是為了檢驗模型按照人類意圖精確編輯文本的能力,它包含300個項目,每一個都開始于清晰的指示。例如,“替換單詞”任務會要求在下面的句子中用目標詞替換指定的詞,而“替換小寫字母”任務則要求將給定文本中的所有大寫字母修改為小寫。為了保證任務的多樣性,計數范圍和待替換的單詞都是通過均勻分布來確定的。

下表展示了模型在規則理解任務上的表現性能。

模式識別

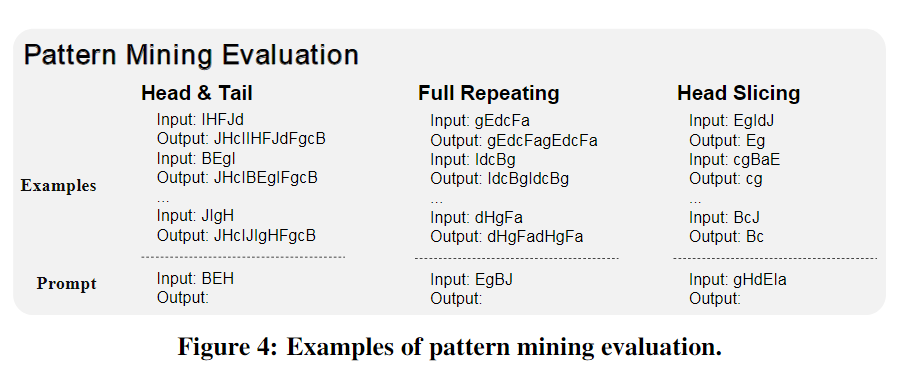

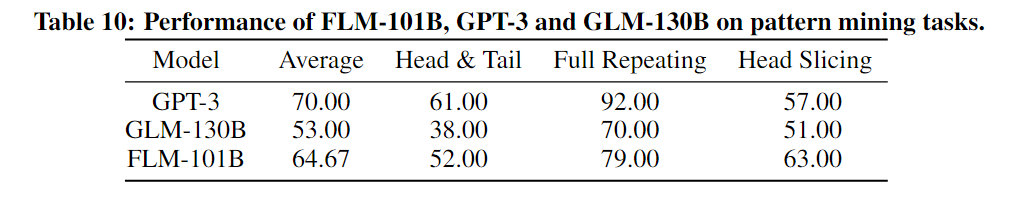

模式識別涉及到在新環境中歸納和推斷出現的模式。在這個基準測試中包含三個任務來進行評估。

- 頭尾添加任務要求在給定的輸入前后添加頭和尾,這兩個元素(即頭和尾)應與給定示例中的元素完全相同。

- 完全重復任務則要求將輸入序列完全重復一次。

- 頭部切片任務,模型需要返回輸入的前一定數量的字符,這個數字可以從前面的示例中推斷出來。

下圖是一個示例。

在模式挖掘的所有三項任務中,FLM-101B取得了第二好的表現。與規則理解評估相似,由于有更多的訓練數據,GPT-3取得了最好的表現。在頭部切片任務上,FLM-101B超越了GPT-3和GLM-130B。在另外兩項任務中,這三個模型的表現順序相同:GPT-3排在第一,FLM-101B排在第二,GLM-130B排在第三。詳細來說,FLM-101B相比GLM-130B分別提高了14%和9%。

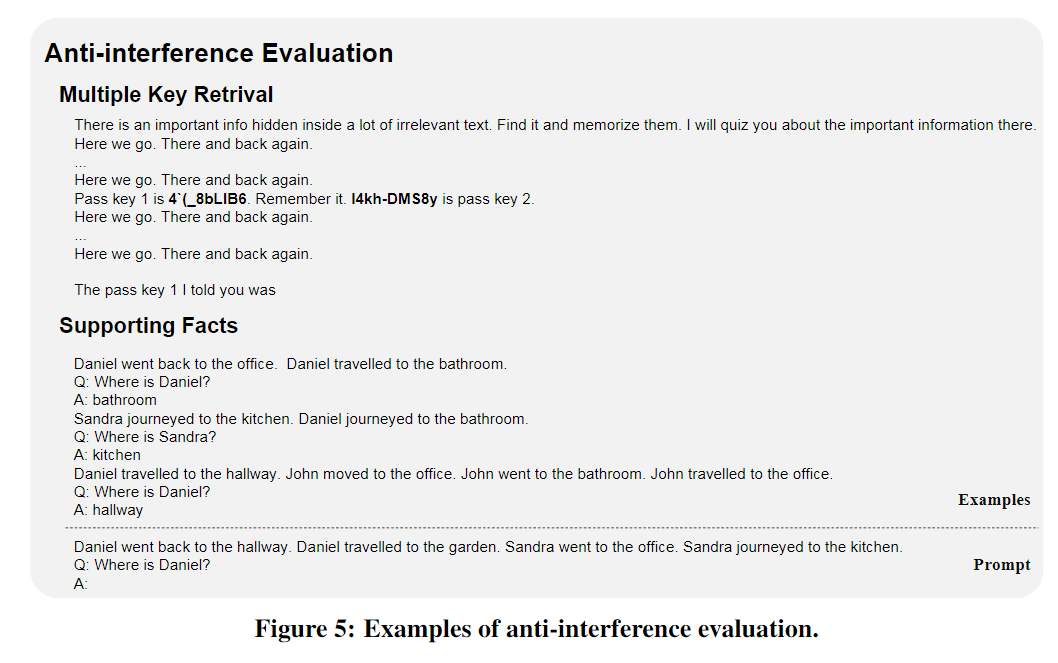

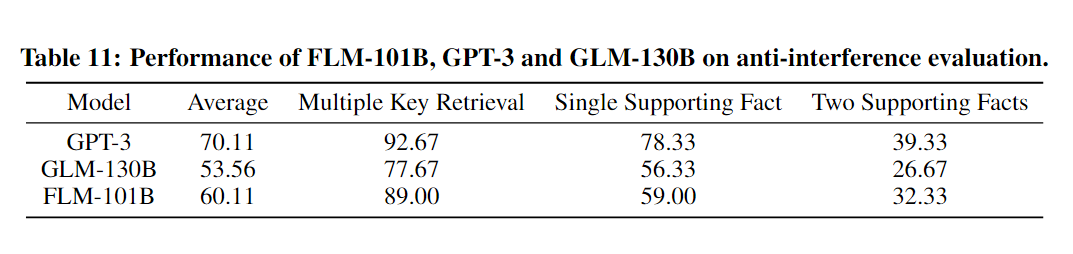

抗干擾評估

抗干擾能力對于在全新的嘈雜環境中找到和利用與特定目標真正相關的信息至關重要。例如,許多LLM會在接收到嘈雜輸入的提示時開始胡言亂語。為此,作者在三種任務類型中進行抗干擾評估:

- 多關鍵詞檢索是一種謎題,它在大量無關的文本中隱藏了一些關鍵詞。如果LLM的抗干擾能力不夠強,它們將輸出錯誤甚至無意義的詞。

- 單一支持事實跟蹤和雙重支持事實跟蹤任務測試模型是否能夠找到隱藏在一系列無關陳述中的支持事實鏈來正確回答問題。

下圖顯示了此測試的兩個典型示例。

在所有baseline中,FLM-101B實現了第二好的性能89%、59%和32.3%,與GLM-130B相比,其優勢約為11%、3%和6%。考慮到計算成本,FLM-101B的出眾是顯而易見的。

總結

該研究開發了中英雙語的FLM-101B模型,一個開源的、成本低廉的但功能強大的LLM,它成功地在10萬美元的預算內從零開始訓練。

研究團隊利用增長策略來訓練模型,以降低初始成本,首先得到一個知識相對有限的基本模型,然后再逐步擴展該模型的知識庫以適應不同領域的需求。

此外,研究團隊還認識到,要準確評估一個LLM的智能程度,需要更先進和綜合的評估方法。傳統的評估方法,如MMLU、SuperGLUE和CLUE等,已不再足夠。為了解決這一問題,他們創造了一個系統的IQ評估基準測試,它能夠全面而準確地衡量智力的四個核心方面,而且還可以方便地進行自動評估。

-

開源

+關注

關注

3文章

3402瀏覽量

42711 -

語言模型

+關注

關注

0文章

538瀏覽量

10341 -

大模型

+關注

關注

2文章

2545瀏覽量

3164

原文標題:開源大模型FLM-101B:訓練成本最低的超100B參數大模型

文章出處:【微信號:zenRRan,微信公眾號:深度學習自然語言處理】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

ARM用以解決圖像超分模型過參數問題

探索一種降低ViT模型訓練成本的方法

飛行訓練成績評估模型的建立與實現

智能開源大模型baichuan-7B技術改進

開源大模型Falcon(獵鷹) 180B發布 1800億參數

開源大模型FLM-101B:訓練成本最低的超100B參數大模型

開源大模型FLM-101B:訓練成本最低的超100B參數大模型

評論