Orca-2-13B[1] 是微軟最新發布的 Orca 2 系列中的一款模型,Orca 2 另外還提供 7B 版本。Orca 2系列模型是由 LLAMA 2 基礎模型中微調而來。Orca 2系列模型擅長推理、文本總結、數學問題解決和理解任務,是在原始 13B Orca 模型的基礎上進一步發展而來,模仿更強大的 AI 系統推理過程從而提高小型模型在復雜任務中的能力。

本文將以 Orca-2-13B 為例,將介紹:

如何在你自己的設備上運行 Orca-2-13B

如何為 Orca-2-13B 創建一個與 OpenAI 兼容的 API 服務

你也可以使用同樣的方式運行 Orca-2-7B 模型,只需要替換 Orca-2-7B模型的 GGUF 格式的下載鏈接。

我們將用 Rust + Wasm 技術棧來開發和部署這個模型的應用程序。無需安裝復雜的 Python 包或 C++ 工具鏈!了解我們為什么選擇 Rust+Wasm 技術棧[2]。

在自己的設備上運行 Orca-2-13B

步驟 1:通過以下命令行安裝 WasmEdge[3]。

curl-sSfhttps://raw.githubusercontent.com/WasmEdge/WasmEdge/master/utils/install.sh|bash-s----pluginwasi_nn-ggml

步驟 2:下載模型 GGUF 文件[4]。由于模型文件有幾 GB,所以可能需要很長時間。

curl-LOhttps://huggingface.co/second-state/Orca-2-13B-GGUF/resolve/main/Orca-2-13b-ggml-model-q4_0.gguf

步驟 3:下載一個跨平臺的可移植 Wasm 文件,用于聊天應用。該應用能讓你用命令行與模型進行交流。戳這里[5]查看該應用的 Rust 源代碼。

curl-LOhttps://github.com/second-state/llama-utils/raw/main/chat/llama-chat.wasm

就這樣。接下來,可以通過輸入以下命令在終端與模型進行聊天。

wasmedge--dir.:.--nn-preloaddefaultAUTO:Orca-2-13b-ggml-model-q4_0.ggufllama-chat.wasm-pchatml-s'YouareOrca,anAIlanguagemodelcreatedbyMicrosoft.Youareacautiousassistant.Youcarefullyfollowinstructions.Youarehelpfulandharmlessandyoufollowethicalguidelinesandpromotepositivebehavior.'--stream-stdout

這個可移植的 Wasm 應用會自動利用你設備上的硬件加速器(如 GPU)。

在我的 Mac M1 32G 內存設備上,它的速度約為每秒 9.15 個token。

[USER]:What isanOrca? [ASSISTANT]: Anorca,orkillerwhale,isalargetoothedpredatorbelongingtotheoceanicdolphinfamily.Theyarehighlyintelligentandsocialanimals,knownfortheircuriosityandplayfulness. [USER]:

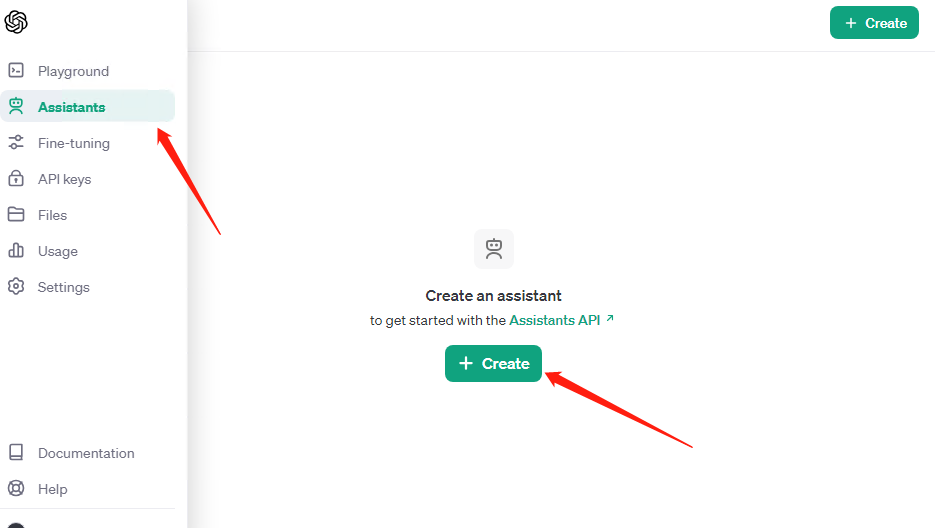

為 Orca-2-13B 創建一個與 OpenAI 兼容的 API 服務

一個與 OpenAI 兼容的網絡 API 能讓 Orca-2-13B 與大量的 LLM 工具和代理框架(如 flows.network、LangChain 和 LlamaIndex)一起工作。

首先,先下載一個 API 服務器應用。它也是一個可以在許多 CPU 和 GPU 設備上運行的跨平臺可移植 Wasm 應用。

curl-LOhttps://github.com/second-state/llama-utils/raw/main/api-server/llama-api-server.wasm

然后,使用以下命令行啟動模型的 API 服務器。

wasmedge--dir.:.--nn-preloaddefaultAUTO:Orca-2-13B.Q5_K_M.ggufllama-api-server.wasm-pchatml

從另一個終端,你可以使用 curl 與 API 服務器進行交互。

curl-XPOSThttp://0.0.0.0:8080/v1/chat/completions-H'accept:application/json'-H'Content-Type:application/json'-d'{"messages":[{"role":"system","content":"YouareahelpfulAIassistant"},{"role":"user","content":"WhatisthecapitalofFrance?"}],"model":"Orca-2-13B"}'

就這樣。WasmEdge 是運行 Orca-2-13B 大模型應用程序最簡單、最快、最安全的方式[6]。試試看吧!

審核編輯:劉清

-

C++語言

+關注

關注

0文章

147瀏覽量

7027 -

python

+關注

關注

56文章

4807瀏覽量

85040 -

硬件加速器

+關注

關注

0文章

42瀏覽量

12840 -

Rust

+關注

關注

1文章

230瀏覽量

6665 -

OpenAI

+關注

關注

9文章

1139瀏覽量

6705

原文標題:跨設備運行微軟最新大語言模型 Orca-2-13B,只需4個命令行

文章出處:【微信號:Rust語言中文社區,微信公眾號:Rust語言中文社區】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

OpenAI斷供API,國產大模型替代方案低成本遷移

OpenAI攻克Sora視頻創建錯誤率高難題

OpenAI宣布API恢復運行,ChatGPT正在逐步回歸

OpenAI 發了一個支持 ESP32 的 Realtime API SDK

OpenAI暫不推出Sora視頻生成模型API

微軟終止中國大陸個人Azure OpenAI服務,為國內大模型帶來機遇

華納云:使用 WireMock 在開發和測試中模擬 API 服務

esp32上使用chatGPT做一些有意思的事情

OpenAI api key獲取并可調用GPT-4.0、GPT-4o、GPT-4omini

OpenAI將終止對中國提供API服務

OpenAI發出警告信:多國開發者面臨API封鎖 OpenAI API解決方案

OpenAI API Key獲取:開發人員申請GPT-4 API Key教程

OpenAI 深夜拋出王炸 “ChatGPT- 4o”, “她” 來了

OpenAI API Key獲取與充值教程:助開發者解鎖GPT-4.0 API

如何為Orca-2-13B創建一個與OpenAI兼容的API服務呢?

如何為Orca-2-13B創建一個與OpenAI兼容的API服務呢?

評論