作者:Arm 高級(jí)副總裁兼物聯(lián)網(wǎng)事業(yè)部總經(jīng)理 Paul Williamson

談到人工智能 (AI) 和機(jī)器學(xué)習(xí) (ML) 時(shí),您會(huì)聯(lián)想到拖拉機(jī)嗎?答案應(yīng)該是不會(huì),但是《經(jīng)濟(jì)學(xué)人》[1]中的這個(gè)類比或許能為您帶來(lái)些啟發(fā)。

雖然拖拉機(jī)在二十世紀(jì)初一經(jīng)問(wèn)世就引起轟動(dòng),但農(nóng)場(chǎng)主們對(duì)于新技術(shù)的接受速度是非常緩慢的。到 1940 年,僅有 23% 的美國(guó)農(nóng)場(chǎng)采用了拖拉機(jī)。為何普及速度如此緩慢?主要原因是拖拉機(jī)功能有限、可靠性較差、維護(hù)困難,以及價(jià)格過(guò)于昂貴。但即使如此,大多數(shù)農(nóng)場(chǎng)主心里也明白,一旦這些問(wèn)題得到解決,且當(dāng)這個(gè)產(chǎn)品更具經(jīng)濟(jì)吸引力,將帶來(lái)巨大的變革。

當(dāng)今技術(shù)的普及速度遠(yuǎn)遠(yuǎn)超過(guò)二十世紀(jì)的農(nóng)業(yè)領(lǐng)域,但從拖拉機(jī)發(fā)展歷程中得出的經(jīng)驗(yàn),對(duì)于 AI 和 ML 在邊緣領(lǐng)域的早期應(yīng)用依然具有重要借鑒意義。換言之,對(duì) AI 系統(tǒng)的競(jìng)相投資不能只停留在對(duì)美好未來(lái)的憧憬上,而要重視切實(shí)可行的實(shí)施計(jì)劃。正如二十世紀(jì) 40 年代,從一開(kāi)始農(nóng)民看到拖拉機(jī)時(shí)的驚奇,轉(zhuǎn)向切實(shí)地提高農(nóng)業(yè)效率,實(shí)現(xiàn)農(nóng)業(yè)多樣化和集約化,以及為拖拉機(jī)開(kāi)發(fā)更多專用附件和服務(wù)。

然而,要在邊緣側(cè)實(shí)現(xiàn) AI 和 ML 的規(guī)模化應(yīng)用,目前仍需克服重重挑戰(zhàn)。

碎片化格局

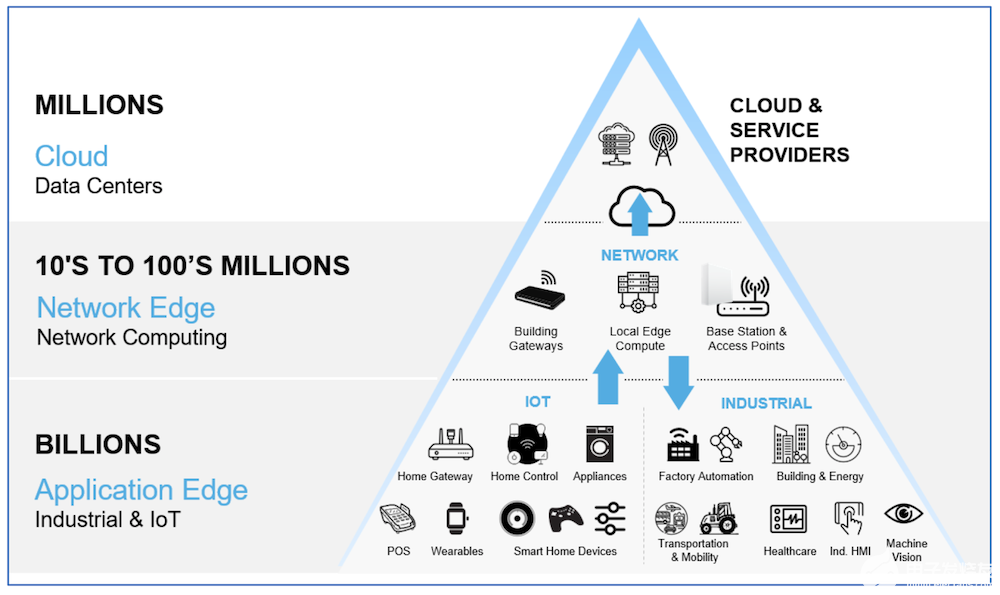

市場(chǎng)上針對(duì)不同應(yīng)用和場(chǎng)景的硬件類型五花八門(mén),這構(gòu)成了在邊緣側(cè)部署 AI 和 ML 的一大挑戰(zhàn)。通常,豐富多樣的硬件選擇會(huì)導(dǎo)致開(kāi)發(fā)者必須為特定硬件定制模型和代碼,這無(wú)疑會(huì)增加開(kāi)發(fā)過(guò)程的復(fù)雜性和管理成本。

現(xiàn)實(shí)情況是,與移動(dòng)設(shè)備和高性能物聯(lián)網(wǎng)類似,大多數(shù) ML 模型都是在 CPU 上運(yùn)行。而物聯(lián)網(wǎng)又廣泛構(gòu)建于 Arm 架構(gòu)之上。2020 年,Arm 推出了 Helium 技術(shù),它是 Arm Cortex-M 指令集的矢量擴(kuò)展,支持在超低功耗設(shè)備上實(shí)現(xiàn) ML 加速。引入 Helium 的 Cortex-M 能夠幫助開(kāi)發(fā)者將 ML 應(yīng)用的性能提升多達(dá) 15 倍,并將其能效提高至少五倍。目前已有超過(guò) 35 家合作伙伴推出了采用 Helium 技術(shù)的設(shè)備,其中包括恩智浦半導(dǎo)體、瑞薩電子、Ambiq 和 Alif Semiconductor。

Arm Ethos NPU 系列產(chǎn)品旨在為邊緣 ML 工作負(fù)載提供更優(yōu)異的性能和能效表現(xiàn),為您的性能提升之路保駕護(hù)航。Ethos NPU 兼具可擴(kuò)展性和可配置性,能夠針對(duì)不同應(yīng)用提供不同級(jí)別的性能和功耗,適用于計(jì)算機(jī)視覺(jué)、自然語(yǔ)言處理、語(yǔ)音識(shí)別、推薦系統(tǒng)等多種應(yīng)用場(chǎng)景。Ethos NPU 可以與任何基于 Arm 技術(shù)的 SoC 集成,為從智能音箱到安全攝像頭等各種設(shè)備提供無(wú)縫的 ML 加速解決方案。

AI 模型生命周期

另一挑戰(zhàn)是 AI 模型的生命周期,其中包括訓(xùn)練、調(diào)整和部署等環(huán)節(jié)。為了在邊緣部署 AI 模型,開(kāi)發(fā)者需要考慮如何針對(duì)特定硬件優(yōu)化模型。這涉及選擇正確的模型架構(gòu)、數(shù)據(jù)格式、量化方案和推理引擎,以便使其能夠在嵌入式設(shè)備上高效運(yùn)行。此外,開(kāi)發(fā)者需要選擇能夠充分利用設(shè)備硬件功能(如 Ethos NPU 或 Helium 技術(shù))的推理引擎,以加速模型的執(zhí)行。

Arm 能夠讓開(kāi)發(fā)者輕松地在嵌入式設(shè)備上使用 PyTorch 和 ExecuTorch 等主流 ML 框架。例如,Arm Keil MDK 是可用于簡(jiǎn)化嵌入式應(yīng)用程序開(kāi)發(fā)和調(diào)試的集成開(kāi)發(fā)環(huán)境 (IDE),能支持 CMSIS 工具包,而后者為設(shè)備能力和 ML 模型提供了通用的抽象層。借助經(jīng)簡(jiǎn)化的開(kāi)發(fā)流程,開(kāi)發(fā)者僅需單一工具鏈和經(jīng)驗(yàn)證的單一架構(gòu)便可以實(shí)現(xiàn) AI 功能。迄今,基于 Cortex-M 的設(shè)備出貨量已超過(guò) 1000 億臺(tái),在全球范圍內(nèi)擁有 100 多家 ML 生態(tài)系統(tǒng)合作伙伴。

利用 Arm 解決方案,開(kāi)發(fā)者可以減少嵌入式設(shè)備中 ML 應(yīng)用開(kāi)發(fā)所需的時(shí)間和成本,同時(shí)獲得更優(yōu)越的性能和能效表現(xiàn)。

使用嵌入式設(shè)備

嵌入式開(kāi)發(fā)面臨的主要挑戰(zhàn)之一在于,需要在資源受限的設(shè)備上優(yōu)化 ML 應(yīng)用的性能和效率。不同于基于云端的解決方案,可利用服務(wù)器強(qiáng)大的計(jì)算和存儲(chǔ)能力,嵌入式設(shè)備通常必須在嚴(yán)苛的功耗和延遲性約束之下,在本地運(yùn)行 ML 模型。為了實(shí)現(xiàn)所需的 ML 性能,開(kāi)發(fā)者通常不得不在初代產(chǎn)品的價(jià)格或功耗上做出妥協(xié)。

而 Arm 虛擬硬件的推出帶來(lái)了一種創(chuàng)新思路,它是一款基于 Arm 架構(gòu)的云端模擬解決方案,使開(kāi)發(fā)者可以在不依賴物理硬件的情況下開(kāi)發(fā)和測(cè)試 ML 應(yīng)用。該解決方案可與 AWS SageMaker 和 Google Cloud AI Platform 等 MLOps 解決方案無(wú)縫集成,有效簡(jiǎn)化了 ML 模型在各種設(shè)備上的部署和管理。這些平臺(tái)提供的工具和服務(wù)支持自動(dòng)執(zhí)行 ML 生命周期的每一個(gè)階段,涵蓋了從數(shù)據(jù)管理和模型訓(xùn)練到部署和監(jiān)控等環(huán)節(jié)。通過(guò)將 Arm 虛擬硬件與 MLOps 解決方案相結(jié)合,開(kāi)發(fā)者可以更快地將嵌入式 ML 應(yīng)用推向市場(chǎng)、降低成本并增強(qiáng)其可擴(kuò)展性。

部署和保護(hù)知識(shí)產(chǎn)權(quán)

在數(shù)以百萬(wàn)計(jì)的端側(cè)設(shè)備中部署和保護(hù)寶貴的知識(shí)產(chǎn)權(quán),也是一項(xiàng)重大挑戰(zhàn)。ML 模型本質(zhì)上是數(shù)學(xué)函數(shù),任何有權(quán)訪問(wèn)設(shè)備或數(shù)據(jù)流的人都可以提取和復(fù)制它。因此,設(shè)備和數(shù)據(jù)可能會(huì)被篡改、操控或惡意攻擊,從而導(dǎo)致其功能和可靠性受到損害。開(kāi)發(fā)者必須確保其 ML 模型受到保護(hù),不會(huì)輕易被逆向工程破解。

Arm 致力于幫助開(kāi)發(fā)者在邊緣設(shè)備上部署 ML 模型并保障其安全,方法之一便是在 PSA Certified 提供的框架內(nèi)操作。PSA Certified 是平臺(tái)安全架構(gòu) (PSA) 的縮寫(xiě),是 Arm 與合作伙伴為幫助保護(hù)物聯(lián)網(wǎng)設(shè)備而制定的最佳實(shí)踐和規(guī)范。經(jīng) PSA Certified 認(rèn)證,用戶可以驗(yàn)證和信任物聯(lián)網(wǎng)產(chǎn)品的安全性,并確保其符合相關(guān)法規(guī)和標(biāo)準(zhǔn)的要求。

嵌入式邊緣 AI

AI 和 ML 正在重新塑造嵌入式系統(tǒng)的發(fā)展面貌。

去年,我們與合作伙伴共同探討了應(yīng)對(duì)嵌入式開(kāi)發(fā)中一些常見(jiàn)挑戰(zhàn)的各種方法,例如:類似 Arm 虛擬硬件等的開(kāi)發(fā)解決方案、新行業(yè)標(biāo)準(zhǔn),或通過(guò)采用 Arm 架構(gòu)以實(shí)現(xiàn)靈活性、高效率并最大限度地降低安全風(fēng)險(xiǎn)。

今年,我們將直面 AI 和 ML 在邊緣領(lǐng)域飛速創(chuàng)新的成果,并切身感受這些變化給 Arm 開(kāi)發(fā)者生態(tài)系統(tǒng)帶來(lái)的影響。物聯(lián)網(wǎng)邊緣互聯(lián)設(shè)備日漸增多,數(shù)據(jù)量呈指數(shù)級(jí)增長(zhǎng),這為 AI 算法處理數(shù)據(jù)并實(shí)時(shí)提供洞察帶來(lái)了大量機(jī)遇。盡管生成式 AI 和大語(yǔ)言模型 (LLM) 備受矚目,但部署到邊緣物聯(lián)網(wǎng)設(shè)備(如:樹(shù)莓派)上的較小模型也開(kāi)始嶄露頭角。Transformer 架構(gòu)模型正在邊緣側(cè)掀起波瀾,因其固有的出色靈活性,使其與傳統(tǒng)的卷積神經(jīng)網(wǎng)絡(luò) (CNN) 區(qū)別開(kāi)來(lái)。

變革的步伐之快令人驚嘆。Arm 非常高興能夠在支持高性能物聯(lián)網(wǎng)設(shè)備和系統(tǒng)實(shí)現(xiàn) AI 方面發(fā)揮關(guān)鍵作用。Arm 的愿景是提供安全的智能設(shè)備和系統(tǒng),進(jìn)而推動(dòng)創(chuàng)新并改善人們的生活。通過(guò)以下舉措,Arm 持續(xù)致力于幫助開(kāi)發(fā)者應(yīng)對(duì)挑戰(zhàn):

通過(guò)優(yōu)化高性能物聯(lián)網(wǎng)中部署 AI 的硬件和軟件,以實(shí)現(xiàn)性能、功耗、成本效益、安全性與可擴(kuò)展性的優(yōu)異平衡。

簡(jiǎn)便易用的工具和平臺(tái),讓高性能物聯(lián)網(wǎng)中的 AI 開(kāi)發(fā)和部署變得更加容易,讓更多具有不同知識(shí)背景的開(kāi)發(fā)者和系統(tǒng)搭建者都能根據(jù)自身需求構(gòu)建和定制解決方案。

強(qiáng)大的生態(tài)系統(tǒng)支持和戰(zhàn)略合作伙伴關(guān)系,加速推動(dòng)了在高性能物聯(lián)網(wǎng)中 AI 的普及并最大限度的發(fā)揮其效用,鼓勵(lì)各利益相關(guān)方和行業(yè)之間開(kāi)展合作與共創(chuàng)。

這些是 Arm 實(shí)現(xiàn)物聯(lián)網(wǎng)邊緣 AI 愿景的重要支柱。我們堅(jiān)信,就像拖拉機(jī)曾經(jīng)大幅改變了農(nóng)業(yè)和食物供應(yīng)鏈一樣,邊緣 AI 也將轉(zhuǎn)變我們與物理世界的互動(dòng)方式,開(kāi)啟人類創(chuàng)新創(chuàng)造的嶄新篇章。

-

ARM

+關(guān)注

關(guān)注

134文章

9167瀏覽量

369217 -

AI

+關(guān)注

關(guān)注

87文章

31520瀏覽量

270339 -

ML

+關(guān)注

關(guān)注

0文章

149瀏覽量

34714 -

機(jī)器學(xué)習(xí)

+關(guān)注

關(guān)注

66文章

8438瀏覽量

133087 -

邊緣AI

+關(guān)注

關(guān)注

0文章

99瀏覽量

5054

原文標(biāo)題:將可能變?yōu)楝F(xiàn)實(shí):利用 Arm 技術(shù)實(shí)現(xiàn)邊緣 AI 和 ML

文章出處:【微信號(hào):Arm社區(qū),微信公眾號(hào):Arm社區(qū)】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

利用TinyML在MCU上實(shí)現(xiàn)AI/ML推論工作

揭秘:AI 的神話與現(xiàn)實(shí)

硬件幫助將AI移動(dòng)到邊緣

EdgeBoard FZ5 邊緣AI計(jì)算盒及計(jì)算卡

【HarmonyOS HiSpark AI Camera】邊緣計(jì)算安全監(jiān)控系統(tǒng)

網(wǎng)絡(luò)邊緣實(shí)施AI的原因

ST MCU邊緣AI開(kāi)發(fā)者云 - STM32Cube.AI

FPGA如何在PC中實(shí)現(xiàn)AI和ML

ML-EXray:云到邊緣部署驗(yàn)證框架

選擇邊緣ML應(yīng)用程序硬件的注意事項(xiàng)

將ML模型推向邊緣實(shí)現(xiàn)了AI的新用例

利用擴(kuò)展型 NAS 存儲(chǔ)加速 AI/ML 工作負(fù)載

AI邊緣計(jì)算是什么意思?邊緣ai是什么?AI邊緣計(jì)算應(yīng)用

Arm與ExecuTorch合作加速端側(cè)生成式AI實(shí)現(xiàn)

利用Arm Kleidi技術(shù)實(shí)現(xiàn)PyTorch優(yōu)化

將可能變?yōu)楝F(xiàn)實(shí):利用Arm技術(shù)實(shí)現(xiàn)邊緣AI和ML

將可能變?yōu)楝F(xiàn)實(shí):利用Arm技術(shù)實(shí)現(xiàn)邊緣AI和ML

評(píng)論