簡介 /

幾十年來,人工智能 (AI) 的威脅一直是科幻小說不變的主題。熒幕反派角色,比如 HAL 9000、終結者、復制人和《黑客帝國》中的機器人,都站在了人類的對立面,迫使人類必須克服這些技術帶來的威脅。最近,DALLE-2 和 ChatGPT 的發布引起了廣大公眾對 AI可以做什么的極大興趣,也引發了人們關于 AI 將如何改變教育和工作性質的討論。AI 也是當前和未來數據中心增長的主要驅動力。

AI 包含以下三個方面: 在訓練期間,大量數據被輸入算法,算法使用數據并從數據中“學習”。 然后,算法接觸新數據集,并將負責基于在訓練期間學習的內容生成新知識或結論。例如,這是一張貓的照片嗎?此過程稱作“推理 AI”。 第三個方面是“生成式 AI”,這可能比較有意思。生成式 AI 是指算法根據簡單的提示“創建”原始輸出,包括文本、圖像、視頻、代碼等。

AI 計算由圖形處理單元 (GPU) 進行處理,GPU 是專為并行處理而設計的芯片,非常適合 AI。用于訓練和運行 AI 的模型會占用大量處理能力,這通常是單臺機器無法承受的。

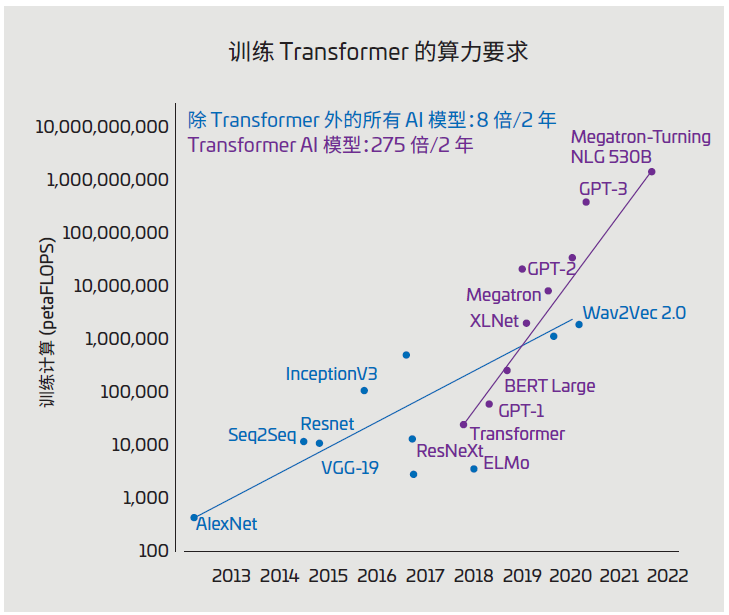

圖 1:AI 模型大小(單位:petaFLOPS)

(資料來源:https://blogs.nvidia.com/blog/2022/03/25/what-is-a-transformer-model/)

圖 1 顯示了 A I 模型的歷史增長情況, 單位為petaFLOPS(每秒千萬億次浮點運算)。處理這些大型模型需使用多個服務器和機架上的眾多互聯GPU。AI 數據中心部署了幾十個這樣的 AI 集群,而將所有內容連接在一起以保持數據流動的布線基礎設施正面臨著一系列棘手挑戰。

以下內容概述了 AI 數據中心布線的一些關鍵挑戰和機遇,以及一些最佳實踐和成功技巧。

典型數據中心架構 /

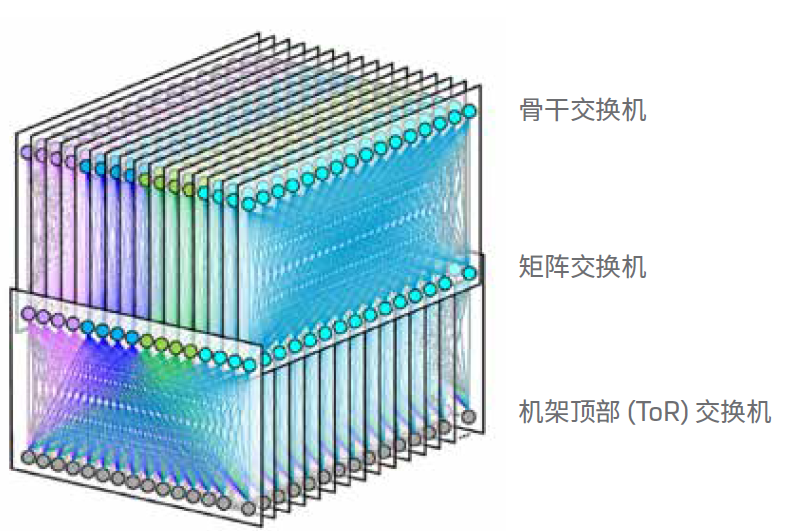

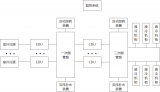

幾乎所有現代數據中心,尤其是超大規模數據中心,使用的都是折疊式 Clos 架構,也稱為“分支和骨干”架構。數據中心的所有分支交換機都連接到所有骨干交換機。在數據中心中,服務器機架連接到機架頂部 (ToR) 交換機。然后,ToR 連接到行末端的分支交換機或通過光纜連接到另一個房間。機架中的服務器通過一至兩米的短銅纜連接到 ToR,傳輸 25G 或 50G信號。

這種配置可讓數據中心使用很少的光纜。例如,使用 F16 架構的 Meta 數據中心(參見圖 2),一行中每臺服務器機架有 16根雙工光纜。這些線纜從 ToR 延伸到行的末端,在那里它們與模塊連接,將雙工光纖組合成 24 根光纜。接著,這 24 根光纜延伸到另一個房間,與分支交換機連接。

數據中心在實施 AI 時,會將 AI 集群部署在采用傳統架構的計算集群旁。傳統計算有時稱為“前端網絡”,AI 集群有時稱為“后端網絡”。

圖 2:FaceBook F16 數據中心網絡拓撲結構

(資料來源:https://engineering..com/2019/03/14/data-center-engineering/f16-minipack/)

帶有 AI 集群的數據中心 /

如上所述,AI 集群具有特有的數據處理要求,因此需要新的數據中心架構。GPU 服務器需要更多的服務器間連接,但是由于電力和散熱的限制,每個機架不得不減少服務器的數量。因此,與傳統數據中心相比,AI 數據中心中的機架間布線更多。每臺 GPU 服務器都連接到行內或房間內的交換機。這些鏈路需要在長距離內達到 100G 到 400G 的速率,而這是銅纜所無法支持的。此外,每臺服務器都需要連接到交換機網絡、存儲和帶外管理。

例如:NVIDIA

舉個例子,可以看看 AI 領域知名企業 NVIDIA 提出的架構。NVIDIA 發布了新款 GPU 服務器 DGX H100,該服務器具有 4 個 800G 交換機端口(作為 8 個 400GE 運行)、4 個 400GE 存儲端口以及 1GE 和 10GE 管理端口。一個 DGXSuperPOD(圖 3)可以包含 32 個這樣的 GPU 服務器,這些GPU 服務器可連接到單行中的 18 臺交換機。然后,每行將擁有 384 個 400GE 光纖鏈路用于交換機網絡和存儲,還有 64個銅纜鏈路用于管理。數據中心中光纖鏈路的數量將顯著增加。前面提到的 F16 架構將在服務器機架數量保持不變的情況下擁有 128 (8x16) 根雙工光纜。

AI 集群的鏈路有多長?/

在 NVIDIA 描繪的理想場景中,AI 集群中的所有 GPU 服務器將緊密結合在一起。與高性能計算 (HPC) 一樣,AI/機器學習算法對延遲極為敏感。有人估計,運行大型訓練模型有 30%的時間花在網絡延遲上,70% 的時間花在計算上。由于訓練一個大模型的成本可能高達 1000 萬美元,因此這種網絡延遲時間代表著一筆巨大的費用。即使是節省 50 納秒或 10 米光纖的延遲,效果也非常明顯。AI 集群中幾乎所有的鏈路都限制在 100 米范圍內。

不幸的是,并非所有數據中心都能夠在同一行部署 GPU 服務器機架。這些機架需要大約 40 kW 才能為 GPU 服務器供電。這一功率比典型服務器機架的更高,按較低功率要求構建的數據中心將需要騰出專門的 GPU 機架空間。

如何選擇收發器?/

運營商應仔細考慮其 AI 集群使用哪些光收發器和光纜才能更大限度地降低成本和功耗。如上所述,AI 集群中的最長鏈路將限制為 100 米。由于距離短,光學設備成本將主要集中在收發器上。使用并行光纖的收發器將具有一個優勢:它們不需要使用光復用器和分解復用器進行波分復用 (WDM)。這降低了并行光纖收發器的成本和功耗。收發器節省下的費用遠遠抵消了多芯光纖取代雙工光纜所略微增加的成本。例如,使用帶有八芯光纖的 400G-DR4 收發器比采用雙工光纜的 400G-FR4 收發器更具成本效益。

單模和多模光纖應用可以支持長達 100 米的鏈路。硅光子技術的發展降低了單模收發器的成本,使其更接近等效多模收發器的成本。我們的市場研究表明,對于高速收發器 (400G+),單模收發器的成本是等效多模收發器成本的兩倍。雖然多模光纖的成本略高于單模光纖,但由于多芯光纖成本主要由 MPO 連接器決定,因此多模和單模光纖之間的成本差異較小。

此外,高速多模收發器的功耗比單模收發器少一兩瓦。單個 AI集群具有 768 個收發器(128 個內存鏈路 + 256 個交換機鏈路x2),使用多模光纖將節省高達 1.5 kW 的功率。與每個 DGXH100 消耗的 10 kW 相比,這似乎微不足道,但對于 AI 集群來說,任何降低功耗的機會都非常寶貴。

在 2022 年,IEEE 短距離光纖工作小組完成了 IEEE 802.3db的工作,該規范為新的超短距離 (VR) 多模收發器確立了標準。此新標準針對的是 AI 集群等行內布線,最大覆蓋范圍為50 米。這些收發器有可能更大程度地降低 AI 連接的成本和功耗。

收發器與 AOC /

許多 AI、ML 和 HPC 集群使用有源光纜 (AOC) 來互聯 GPU 和交換機。AOC 是兩端集成了光發射器和接收器的光纜。大多數 AOC 用于短距離,通常與多模光纖和 VCSEL 搭配使用。高速 (>40G) 有源光纜將使用與連接光收發器的光纜相同的 OM3 或 OM4 光纖。AOC 中的收發器未必和設備兼容,如果不兼容將無法工作。AOC 的收發器直接接入設備即可,但是由于安裝人員測試 AOC 中的收發器,因此不需要具備清潔和檢查光纖連接器所需的技能。

AOC 的缺點是它們不具備收發器所擁有的靈活性。AOC 安裝非常耗時,因為布線時必須連接收發器。正確安裝帶有扇出功能的 AOC 尤其具有挑戰性。AOC 的故障率是同等收發器的兩倍。當 AOC 發生故障時,必須通過網絡來安裝新的 AOC。這會占用計算時間。最后,當需要升級網絡鏈路時,必須拆除有問題的 AOC 并更換為新的 AOC。相對于 AOC 連接而言,光纖布線是基礎設施的一部分,并且可以在幾代數據速率迭代升級中保持生命力。

結論 /

仔細考慮 AI 集群的布線將有助于節省成本、功耗和安裝時間。合理的光纖布線將使企業能夠充分受益于人工智能。

-

數據中心

+關注

關注

16文章

4859瀏覽量

72381 -

AI

+關注

關注

87文章

31520瀏覽量

270335 -

布線

+關注

關注

9文章

777瀏覽量

84430

原文標題:數據中心白皮書系列丨AI 數據中心的布線考量

文章出處:【微信號:康普中國,微信公眾號:康普中國】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

Meta AI數據中心網絡用了哪家的芯片

AI時代,我們需要怎樣的數據中心?AI重新定義數據中心

數據中心布線標準有什么

蘋果正在研發全新數據中心AI芯片

數據中心布線光纜設計方案

AI數據中心的布線考量

AI數據中心的布線考量

評論