自動駕駛領域的技術變革呼之欲出。

如果說,自動駕駛大規模落地的痛點在于深度學習的范疇僅限于圖像等靜態材料,那很快,自動駕駛深度學習的范圍將擴展到視頻領域。

近日,眾安信息技術服務有限公司(以下簡稱“眾安科技”)數據科學實驗室的論文"Dense Dilated Network for Few Shot Action Recognition"(《基于密集擴展網絡的少樣本視頻動作識別》)被ICMR(國際多媒體圖像分析峰會)錄用,這是深度學習在視頻分類領域的創新應用,在駕駛行為分析、視頻檢索等領域有重要的業務價值。

深度學習進入“視頻學習”時代

“讀圖”已經無法滿足機器的學習胃口。深度學習是機器學習中一種基于對數據進行表面特征的方法,其概念源于人工神經網絡的研究。目前,深度學習的主要素材來源于文字、圖片,而隨著智能手機等設備的發展,視頻沉淀了大量深度學習素材。近年來人工智能、神經網絡的發展更是促進了視頻的分類、識別的研究。

不過,機器想要學習視頻素材絕非易事。一般來說,訓練深度神經網絡需要大量標記良好的數據。對于機器來說,由于視頻動作、視角較多,且視頻每秒都包含了20-30幀畫面,數據規模較大,機器的標注難度比標注圖像復雜很多倍。另一方面,就視頻本身而言,雖然不同的視頻內容差異很大,但同一類的視頻在語義上有著很高的相似性,對于機器學習來說,如何避免“重復勞動”也是擺在現實面前的一道難題。

針對上述難題,眾安科技通過在視頻多樣性中提取高層共有的特性來實現機器學習。

眾安科技方面表示,基于機器學習視頻的痛點,數據科學實驗室研發了一種新穎的神經網絡架構來同時捕獲局部信息和整體時空信息。具體來看,眾安科技采用了擴張卷積網絡,在這個網絡的不同層之間,使用密集連接的方式組合,由此可以融合每一層的輸出,從而學習視頻的高級特征。

和其他網絡架構相比,眾安科技的這款神經網絡架構利用每層與之前所有層相連的方式,可以得到從最初局部特征到總體視頻的所有特征信息。而每層網絡使用了擴張卷積(dilated convolution),相比原始的卷積方式,可以更加充分利用時空信息。因此不需要很深的層數,在少量數據下就可以訓練效果較好的網絡。

以目前動作類別數、樣本數較多的數據庫之一UCF101為例,眾安科技在此數據庫的通用視頻數據集上進行了大量實驗,在僅有20%的訓練數據時(模擬對新任務的快速學習),利用該神經網絡架構,機器仍然可以學到每類視頻的高層語義特征。

視頻深度學習下個落地場景:出行、醫療

視頻深度學習有望率先在出行和醫療領域落地。

眾安科技研發的這款神經網絡架構在實戰中也有很高的應用價值,由于該架構只需要少量訓練數據就可以促進不同任務之間的遷移學習,幫助系統快速上線,從而減少了大量采集數據和訓練過程。

如在車險領域,可以使用該方法對路口監控或行車記錄儀等視頻進行快速分析,識別碰撞和高危駕駛片段,從而對車主的駕駛行為進行建模,實現車險的自主定價。

此外,在醫療方面,目前人工智能輔助醫療的手段除了CT圖片等,還有許多造影等多樣的數據有待分析。該方法利用時序信息,可以針對造影進行識別診斷,尤其是對于病例較少的罕見病分析更為高效。

眾安科技數據科學實驗室認為,該神經網絡架構針對出行和醫療領域會有較大的幫助,這也是該團隊未來產學研結合的落地方向之一。

-

神經網絡

+關注

關注

42文章

4781瀏覽量

101178 -

機器學習

+關注

關注

66文章

8441瀏覽量

133094 -

自動駕駛

+關注

關注

785文章

13932瀏覽量

167017

原文標題:從圖像識別走向視頻識別,眾安科技推出視頻深度學習利器

文章出處:【微信號:robot-1hjqr,微信公眾號:1號機器人網】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

GPU深度學習應用案例

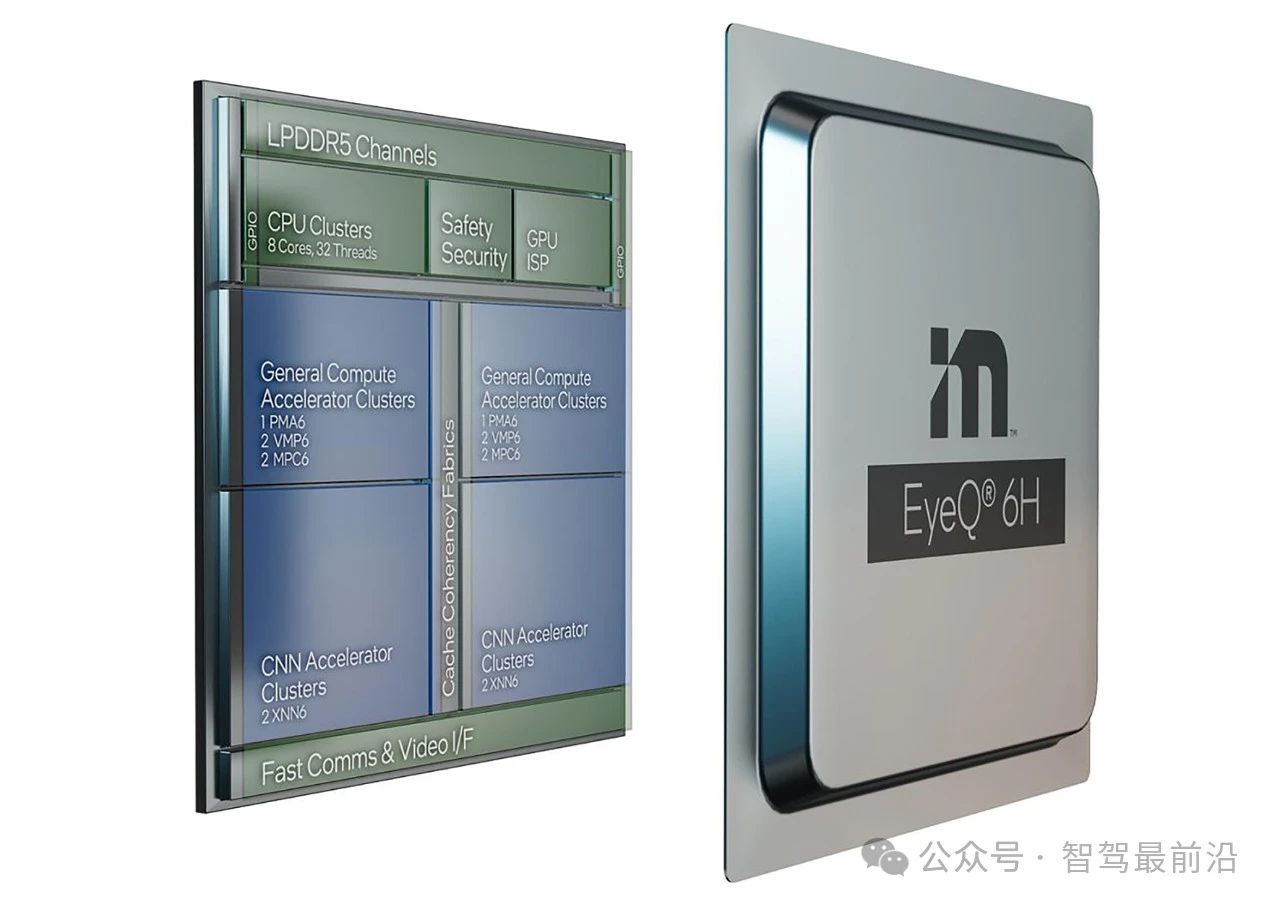

Mobileye端到端自動駕駛解決方案的深度解析

NVIDIA推出全新深度學習框架fVDB

FPGA在自動駕駛領域有哪些優勢?

FPGA在自動駕駛領域有哪些應用?

中級自動駕駛架構師應該學習哪些知識

初級自動駕駛架構師應該學習哪些知識

未來已來,多傳感器融合感知是自動駕駛破局的關鍵

FPGA在深度學習應用中或將取代GPU

端到端自動駕駛的基石到底是什么?

自動駕駛領域的技術變革呼之欲出,深度學習進入“視頻學習”時代

自動駕駛領域的技術變革呼之欲出,深度學習進入“視頻學習”時代

評論