2018,仍是AI領(lǐng)域激動(dòng)人心的一年。

計(jì)算機(jī)視覺領(lǐng)域同樣精彩紛呈,與四年前相比GAN生成的假臉逼真到讓人不敢相信;新工具、新框架的出現(xiàn),也讓這個(gè)領(lǐng)域的明天特別讓人期待……

近日,Analytics Vidhya發(fā)布了一份2018人工智能技術(shù)總結(jié)與2019趨勢預(yù)測報(bào)告,原文作者PRANAV DAR。這份報(bào)告總結(jié)和梳理了全年主要AI技術(shù)領(lǐng)域的重大進(jìn)展,同時(shí)也給出了相關(guān)的資源地址,以便大家更好的使用、查詢。

重點(diǎn)為大家介紹這份報(bào)告中的兩個(gè)部分:

計(jì)算機(jī)視覺

工具和庫

下面,我們就逐一來盤點(diǎn)和展望。

計(jì)算機(jī)視覺

今年,無論是圖像還是視頻方向都有大量新研究問世,有三大研究曾在CV圈掀起了集體波瀾。

BigGAN

今年9月,當(dāng)搭載BigGAN的雙盲評審中的ICLR 2019論文現(xiàn)身,行家們就沸騰了:簡直看不出這是GAN自己生成的。

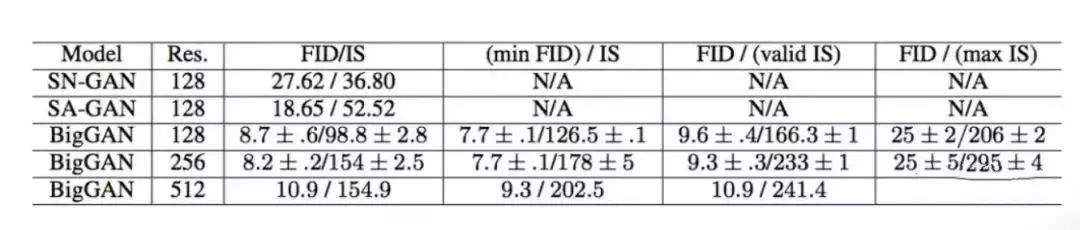

在計(jì)算機(jī)圖像研究史上,BigGAN的效果比前人進(jìn)步了一大截。比如在ImageNet上進(jìn)行128×128分辨率的訓(xùn)練后,它的Inception Score(IS)得分166.3,是之前最佳得分52.52分3倍。

除了搞定128×128小圖之外,BigGAN還能直接在256×256、512×512的ImageNet數(shù)據(jù)上訓(xùn)練,生成更讓人信服的樣本。

在論文中研究人員揭秘,BigGAN的驚人效果背后,真的付出了金錢的代價(jià),最多要用512個(gè)TPU訓(xùn)練,費(fèi)用可達(dá)11萬美元,合人民幣76萬元。

不止是模型參數(shù)多,訓(xùn)練規(guī)模也是有GAN以來最大的。它的參數(shù)是前人的2-4倍,批次大小是前人的8倍。

研究論文:https://openreview.net/pdf?id=B1xsqj09Fm

Fast.ai 18分鐘訓(xùn)練整個(gè)ImageNet

在完整的ImageNet上訓(xùn)練一個(gè)模型需要多久?各大公司不斷下血本刷新著記錄。

不過,也有不那么燒計(jì)算資源的平民版。

今年8月,在線深度學(xué)習(xí)課程Fast.ai的創(chuàng)始人Jeremy Howard和自己的學(xué)生,用租來的亞馬遜AWS的云計(jì)算資源,18分鐘在ImageNet上將圖像分類模型訓(xùn)練到了93%的準(zhǔn)確率。

前前后后,F(xiàn)ast.ai團(tuán)隊(duì)只用了16個(gè)AWS云實(shí)例,每個(gè)實(shí)例搭載8塊英偉達(dá)V100 GPU,結(jié)果比Google用TPU Pod在斯坦福DAWNBench測試上達(dá)到的速度還要快40%。

這樣拔群的成績,成本價(jià)只需要40美元,F(xiàn)ast.ai在博客中將其稱作人人可實(shí)現(xiàn)。

Fast.ai博客介紹:https://www.fast.ai/2018/08/10/fastai-diu-imagenet/

vid2vid技術(shù)

今年8月,英偉達(dá)和MIT的研究團(tuán)隊(duì)高出一個(gè)超逼真高清視頻生成AI。

只要一幅動(dòng)態(tài)的語義地圖,就可獲得和真實(shí)世界幾乎一模一樣的視頻。換句話說,只要把你心中的場景勾勒出來,無需實(shí)拍,電影級的視頻就可以自動(dòng)P出來:

除了街景,人臉也可生成:

這背后的vid2vid技術(shù),是一種在生成對抗性學(xué)習(xí)框架下的新方法:精心設(shè)計(jì)的生成器和鑒別器架構(gòu),再加上時(shí)空對抗目標(biāo)。

這種方法可以在分割蒙版、素描草圖、人體姿勢等多種輸入格式上,實(shí)現(xiàn)高分辨率、逼真、時(shí)間相干的視頻效果。

好消息,vid2vid現(xiàn)已被英偉達(dá)開源。

研究論文:https://tcwang0509.github.io/vid2vid/paper_vid2vid.pdf

GitHub地址:https://github.com/NVIDIA/vid2vid

2019趨勢展望

Analytics Vidhya預(yù)計(jì),明年在計(jì)算機(jī)視覺領(lǐng)域,對現(xiàn)有方法的改進(jìn)和增強(qiáng)的研究可能多于創(chuàng)造新方法。

在美國,政府對無人機(jī)的限令可能會(huì)稍微“松綁”,開放程度可能增加。而今年大火的自監(jiān)督學(xué)習(xí)明年可能會(huì)應(yīng)用到更多研究中。

Analytics Vidhya對視覺領(lǐng)域也有一些期待,目前來看,在CVPR和ICML等國際頂會(huì)上公布最新研究成果,在工業(yè)界的應(yīng)用情況還不樂觀。他希望在2019年,能看到更多的研究在實(shí)際場景中落地。

Analytics Vidhya預(yù)計(jì),視覺問答(Visual Question Answering,VQA)技術(shù)和視覺對話系統(tǒng)可能會(huì)在各種實(shí)際應(yīng)用中首次亮相。

工具和框架

哪種工具最好?哪個(gè)框架代表了未來?這都是一個(gè)個(gè)能永遠(yuǎn)爭論下去的話題。

沒有異議的是,不管爭辯的結(jié)果是什么,我們都需要掌握和了解最新的工具,否則就有可能被行業(yè)所拋棄。

今年,機(jī)器學(xué)習(xí)領(lǐng)域的工具和框架仍在快速的發(fā)展,下面就是這方面的總結(jié)和展望。

PyTorch 1.0

根據(jù)10月GitHub發(fā)布的2018年度報(bào)告,PyTorch在增長最快的開源項(xiàng)目排行上,名列第二。也是唯一入圍的深度學(xué)習(xí)框架。

作為谷歌TensorFlow最大的“勁敵”,PyTorch其實(shí)是一個(gè)新兵,2017年1月19日才正式發(fā)布。2018年5月,PyTorch和Caffe2整合,成為新一代PyTorch 1.0,競爭力更進(jìn)一步。

相較而言,PyTorch速度快而且非常靈活,在GitHub上有越來越多的開碼都采用了PyTorch框架。可以預(yù)見,明年P(guān)yTorch會(huì)更加普及。

至于PyTorch和TensorFlow怎么選擇?在我們之前發(fā)過的一篇報(bào)道里,不少大佬站PyTorch。

實(shí)際上,兩個(gè)框架越來越像。前Google Brain深度學(xué)習(xí)研究員,Denny Britz認(rèn)為,大多數(shù)情況下,選擇哪一個(gè)深度學(xué)習(xí)框架,其實(shí)影響沒那么大。

PyTorch官網(wǎng):https://pytorch.org/

AutoML

很多人將AutoML稱為深度學(xué)習(xí)的新方式,認(rèn)為它改變了整個(gè)系統(tǒng)。有了AutoML,我們就不再需要設(shè)計(jì)復(fù)雜的深度學(xué)習(xí)網(wǎng)絡(luò)。

今年1月17日,谷歌推出Cloud AutoML服務(wù),把自家的AutoML技術(shù)通過云平臺對外發(fā)布,即便你不懂機(jī)器學(xué)習(xí),也能訓(xùn)練出一個(gè)定制化的機(jī)器學(xué)習(xí)模型。

不過AutoML并不是谷歌的專利。過去幾年,很多公司都在涉足這個(gè)領(lǐng)域,比方國外有RapidMiner、KNIME、DataRobot和H2O.ai等等。

除了這些公司的產(chǎn)品,還有一個(gè)開源庫要介紹給大家:

Auto Keras!

這是一個(gè)用于執(zhí)行AutoML任務(wù)的開源庫,意在讓更多人即便沒有人工智能的專家背景,也能搞定機(jī)器學(xué)習(xí)這件事。

這個(gè)庫的作者是美國德州農(nóng)工大學(xué)(Texas A&M University)助理教授胡俠和他的兩名博士生:金海峰、Qingquan Song。Auto Keras直擊谷歌AutoML的三大缺陷:

第一,還得付錢。

第二,因?yàn)樵谠粕希€得配置Docker容器和Kubernetes。

第三,服務(wù)商(Google)保證不了你數(shù)據(jù)安全和隱私。

官網(wǎng):https://autokeras.com/

GitHub:https://github.com/jhfjhfj1/autokeras

TensorFlow.js

今年3月底的TensorFlow開發(fā)者會(huì)峰會(huì)2018上,TensorFlow.js正式發(fā)布。

這是一個(gè)面向JavaScript開發(fā)者的機(jī)器學(xué)習(xí)框架,可以完全在瀏覽器中定義和訓(xùn)練模型,也能導(dǎo)入離線訓(xùn)練的TensorFlow和Keras模型進(jìn)行預(yù)測,還對WebGL實(shí)現(xiàn)無縫支持。

在瀏覽器中使用TensorFlow.js可以擴(kuò)展更多的應(yīng)用場景,包括展開交互式的機(jī)器學(xué)習(xí)、所有數(shù)據(jù)都保存在客戶端的情況等。

實(shí)際上,這個(gè)新發(fā)布的TensorFlow.js,就是基于之前的deeplearn.js,只不過被整合進(jìn)TensorFlow之中。

谷歌還給了幾個(gè)TensorFlow.js的應(yīng)用案例。比如借用你的攝像頭,來玩經(jīng)典游戲:吃豆人(Pac-Man)。

-

人工智能

+關(guān)注

關(guān)注

1796文章

47683瀏覽量

240307 -

計(jì)算機(jī)視覺

+關(guān)注

關(guān)注

8文章

1700瀏覽量

46130

原文標(biāo)題:一文看盡2018全年計(jì)算機(jī)視覺大突破

文章出處:【微信號:AItists,微信公眾號:人工智能學(xué)家】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

計(jì)算機(jī)視覺有哪些優(yōu)缺點(diǎn)

計(jì)算機(jī)視覺技術(shù)的AI算法模型

機(jī)器視覺和計(jì)算機(jī)視覺有什么區(qū)別

計(jì)算機(jī)視覺的五大技術(shù)

計(jì)算機(jī)視覺的工作原理和應(yīng)用

機(jī)器人視覺與計(jì)算機(jī)視覺的區(qū)別與聯(lián)系

計(jì)算機(jī)視覺與人工智能的關(guān)系是什么

計(jì)算機(jī)視覺與智能感知是干嘛的

計(jì)算機(jī)視覺和機(jī)器視覺區(qū)別在哪

計(jì)算機(jī)視覺和圖像處理的區(qū)別和聯(lián)系

計(jì)算機(jī)視覺屬于人工智能嗎

深度學(xué)習(xí)在計(jì)算機(jī)視覺領(lǐng)域的應(yīng)用

機(jī)器視覺與計(jì)算機(jī)視覺的區(qū)別

計(jì)算機(jī)視覺的主要研究方向

計(jì)算機(jī)視覺的十大算法

盤點(diǎn)2018年計(jì)算機(jī)視覺大突破

盤點(diǎn)2018年計(jì)算機(jī)視覺大突破

評論