谷歌首席科學(xué)家提出要想讓半監(jiān)督學(xué)習(xí)實(shí)際上有用,要同時(shí)考慮低維數(shù)據(jù)和高維數(shù)據(jù),并討論了谷歌最近的兩個(gè)研究。作者認(rèn)為在實(shí)際環(huán)境中重新審視半監(jiān)督學(xué)習(xí)的價(jià)值是一個(gè)激動(dòng)人心的時(shí)刻。

作為一個(gè)機(jī)器學(xué)習(xí)工程師,可能平時(shí)最常打交道的就是海量數(shù)據(jù)了。這些數(shù)據(jù)只有少部分是有標(biāo)注的,可以用來進(jìn)行監(jiān)督學(xué)習(xí)。但另外一大部分的數(shù)據(jù)是沒有標(biāo)注過的。

那么接下來,我們就會順理成章的想到用這些已標(biāo)注過的數(shù)據(jù)進(jìn)行訓(xùn)練,再利用訓(xùn)練好的學(xué)習(xí)器找出未標(biāo)注數(shù)據(jù)中,對性能改善最大的數(shù)據(jù),讓機(jī)器自己的對未標(biāo)注數(shù)據(jù)進(jìn)行分析來提高泛化性能,

這種介于監(jiān)督學(xué)習(xí)和無監(jiān)督學(xué)習(xí)之間的方式,稱為半監(jiān)督學(xué)習(xí)。人類的學(xué)習(xí)方法是半監(jiān)督學(xué)習(xí),我們能從大量的未標(biāo)注數(shù)據(jù)和極少量的標(biāo)注數(shù)據(jù)學(xué)習(xí),迅速理解這個(gè)世界。

然而半監(jiān)督學(xué)習(xí)實(shí)踐中根本沒用?

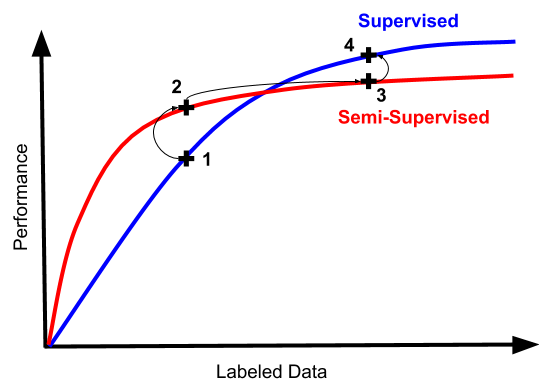

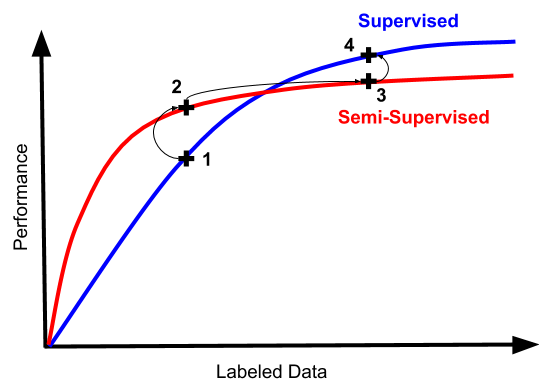

人類的半監(jiān)督學(xué)習(xí)非常有效,那么我們自然的希望機(jī)器的半監(jiān)督學(xué)習(xí)也能達(dá)到類似的程度。但是從歷史上來看,半監(jiān)督學(xué)習(xí)的效果和我們想象的效果有很大差距。先來看一張圖:

上圖可以看出來,最開始的時(shí)候,半監(jiān)督學(xué)習(xí)訓(xùn)練確實(shí)有種提升監(jiān)督學(xué)習(xí)效果的趨勢,然而實(shí)際操作中,我們經(jīng)常陷入從“可怕又不可用”的狀態(tài),到“不那么可怕但仍然完全不可用”。

如果你突然發(fā)現(xiàn)你的半監(jiān)督學(xué)習(xí)起效了,這意味著你的分類器單純的不行,單純的沒有實(shí)際用處。

而且面對大量的數(shù)據(jù),半監(jiān)督學(xué)習(xí)方式通常不能實(shí)現(xiàn)和監(jiān)督學(xué)習(xí)中所實(shí)現(xiàn)的相同漸近性質(zhì),未標(biāo)注的數(shù)據(jù)可能會引入偏差。

舉個(gè)例子,在深度學(xué)習(xí)的早期階段,一種非常流行的半監(jiān)督學(xué)習(xí)方法是首先學(xué)習(xí)一個(gè)關(guān)于未標(biāo)注數(shù)據(jù)的自動(dòng)編碼器,然后對標(biāo)注數(shù)據(jù)進(jìn)行微調(diào)。

現(xiàn)在幾乎沒人這么做了。因?yàn)橥ㄟ^自動(dòng)編碼學(xué)習(xí)的表示,傾向于在經(jīng)驗(yàn)上限制微調(diào)的漸近性能。

而且,即使是已經(jīng)突飛猛進(jìn)的現(xiàn)代生成方法,也沒有對此狀況有多大的改善。可能因?yàn)樘嵘赡P托Ч脑兀⒉荒芎苡行У奶嵘诸惼鞯男Ч?/p>

當(dāng)你在今天看到機(jī)器學(xué)習(xí)工程師對模型進(jìn)行微調(diào)時(shí),基本都是從從監(jiān)督數(shù)據(jù)上學(xué)習(xí)的表示開始。而且文本是用于語言建模目的的自監(jiān)督數(shù)據(jù)。

最終我們得出一個(gè)結(jié)論:實(shí)際情況下,從其他預(yù)訓(xùn)練模型進(jìn)行轉(zhuǎn)移學(xué)習(xí)是一個(gè)更穩(wěn)健的起點(diǎn),在這方面半監(jiān)督方法難以超越。

所以,一位機(jī)器學(xué)習(xí)工程師在半監(jiān)督學(xué)習(xí)的沼澤中艱難前行的典型路徑如下:

一切都很糟糕,讓我們嘗試半監(jiān)督學(xué)習(xí)吧!(畢竟這是工程工作,比標(biāo)注數(shù)據(jù)這種純體力活可有意思多了)

看,數(shù)字上去了!但是仍然很糟糕。看起來我們還是得去搞標(biāo)注數(shù)據(jù)...

數(shù)據(jù)越多,效果越好。但是你有沒有嘗試過丟棄半監(jiān)督機(jī)器會發(fā)生什么?

嘿你知道嗎,它實(shí)際上更簡單更好。我們可以通過完全跳過2和3來節(jié)省時(shí)間和大量技術(shù)債

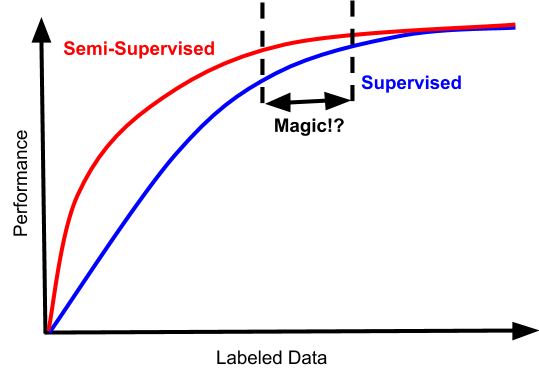

如果你走運(yùn)的話,你的問題也可能具有這樣的性能特征:

巧了,在這種情況下,存在一種狹窄的數(shù)據(jù)體系。半監(jiān)督學(xué)習(xí)在其中不僅不糟糕,而且還實(shí)實(shí)在在的提高了數(shù)據(jù)效率。

但是根據(jù)過來人的經(jīng)驗(yàn)來看,這個(gè)點(diǎn)很難找到。考慮到額外復(fù)雜性的成本,標(biāo)注數(shù)據(jù)量之間的鴻溝,通常不會帶來多大的效果,并且收益遞減,所以根本不值當(dāng)浪費(fèi)精力在這個(gè)上面,除非你想在這個(gè)領(lǐng)域競爭學(xué)術(shù)基準(zhǔn)。

半監(jiān)督學(xué)習(xí)其實(shí)正在悄然的進(jìn)化

說了這么多半監(jiān)督學(xué)習(xí)的弱項(xiàng)。其實(shí)本文真正想講的是在半監(jiān)督學(xué)習(xí)領(lǐng)域,一直在悄悄發(fā)生的進(jìn)化。

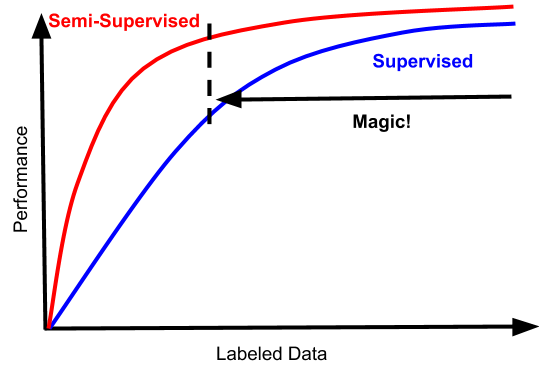

一個(gè)引人入勝的趨勢是,半監(jiān)督學(xué)習(xí)的可能會變成看起來更像這樣的東西:

這將改變所有目前半監(jiān)督學(xué)習(xí)領(lǐng)域的難題。

這些曲線符合我們理想中的半監(jiān)督方法的情況:數(shù)據(jù)越多越好。半監(jiān)督學(xué)習(xí)和監(jiān)督學(xué)習(xí)之間的差距,也應(yīng)該是嚴(yán)格成正比的,即使是監(jiān)督學(xué)習(xí)表現(xiàn)的很好的領(lǐng)域,半監(jiān)督學(xué)習(xí)也應(yīng)該能表現(xiàn)的很好。

而且這種效果的提升伴隨著的是成本的穩(wěn)定,以及很少量的額外復(fù)雜性。圖中的“magic區(qū)域”從更低的地方開始,同樣重要的是,它不受高數(shù)據(jù)制度的束縛。

其他一些新的發(fā)展包括:有更好的方式進(jìn)行自我標(biāo)注數(shù)據(jù),并以這樣的方式表達(dá)損失,即它們與噪聲和自我標(biāo)注的潛在偏差兼容。

最近有兩篇論文講述了半監(jiān)督學(xué)習(xí)最近的進(jìn)展。

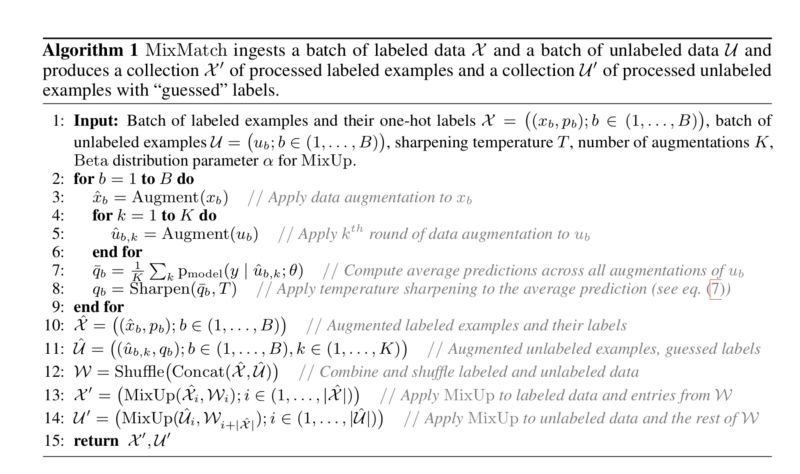

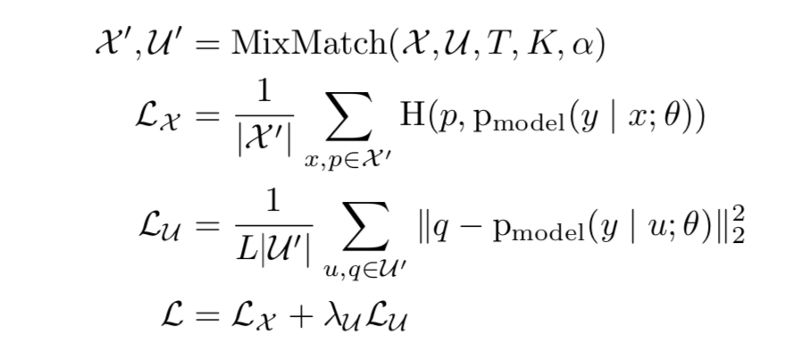

MixMatch: A Holistic Approach to Semi-Supervised Learning

論文地址:

https://arxiv.org/abs/1905.02249

Mixmatch是本文中提出的新方法,它巧妙地結(jié)合了以前單獨(dú)使用的3種SSL范例。

一致性正則化:通過增加標(biāo)記和未標(biāo)記的數(shù)據(jù)輸入來引入

熵最小化:銳化函數(shù)減少了未標(biāo)記數(shù)據(jù)的猜測標(biāo)簽中的熵

傳統(tǒng)正則化: MixUp引入了數(shù)據(jù)點(diǎn)之間的線性關(guān)系

在每個(gè)batch中,每個(gè)標(biāo)記的數(shù)據(jù)點(diǎn)被增強(qiáng)一次,并且每個(gè)未標(biāo)記的數(shù)據(jù)點(diǎn)被增加K(超參數(shù))時(shí)間。要求該模型預(yù)測所有K個(gè)增廣條目(L類的概率),并將它們的平均值作為所有K個(gè)條目的預(yù)測。

銳化該平均值以最小化熵并將其作為最終預(yù)測。將增強(qiáng)的標(biāo)記和未標(biāo)記的數(shù)據(jù)連接并混洗以獲得W.batch中的標(biāo)記數(shù)據(jù)與第一個(gè)|X|“混合”。 W的條目得到X',其中|X|是batch中標(biāo)記數(shù)據(jù)的大小。batch中的未標(biāo)記數(shù)據(jù)與W的其余條目“混合”以獲得U'。

MixMatch算法結(jié)合了不同的SSL范例,通過一個(gè)重要因素實(shí)現(xiàn)了比所有基線數(shù)據(jù)集上所有當(dāng)前方法明顯更好的性能。它確保了差異隱私的更好的準(zhǔn)確性和隱私的權(quán)衡,因?yàn)樾枰绕渌椒ǜ俚臄?shù)據(jù)來實(shí)現(xiàn)類似的性能。

Unsupervised Data Augmentation

論文地址

https://arxiv.org/abs/1904.12848

本文的重點(diǎn)是從(主要是啟發(fā)式的,實(shí)用的)數(shù)據(jù)增強(qiáng)世界中為監(jiān)督學(xué)習(xí)提供進(jìn)展,并將其應(yīng)用于無監(jiān)督設(shè)置,作為在半監(jiān)督環(huán)境中引入更好性能的一種方式(具有許多未標(biāo)記點(diǎn),以及很少標(biāo)記的)。

論文中的無監(jiān)督數(shù)據(jù)增強(qiáng)(UDA)策略注意到兩件事:首先在監(jiān)督學(xué)習(xí)領(lǐng)域,在生成增強(qiáng)數(shù)據(jù)方面存在特定于數(shù)據(jù)集的創(chuàng)新,這對于給定數(shù)據(jù)集特別有用。語言建模,這方面的一個(gè)例子是把一個(gè)句子翻譯成另一種語言,并通過兩個(gè)訓(xùn)練有素的翻譯網(wǎng)絡(luò)再次返回,并使用得到的句子作為輸入。對于ImageNet,有一種稱為AutoAugment的方法,它使用驗(yàn)證集上的強(qiáng)化學(xué)習(xí)來學(xué)習(xí)圖像操作的策略(比如旋轉(zhuǎn),剪切,改變顏色),以提高驗(yàn)證的準(zhǔn)確性。

(2)在半監(jiān)督學(xué)習(xí)中,越來越傾向于使用一致性損失作為利用未標(biāo)記數(shù)據(jù)的一種方式。一致性損失的基本思想是,即使不知道給定數(shù)據(jù)點(diǎn)的類,如果以某種很小的方式修改它,也可以確信模型的預(yù)測應(yīng)該在數(shù)據(jù)點(diǎn)與其擾動(dòng)之間保持一致,即使你并不知道實(shí)際的ground truth是什么。通常,這樣的系統(tǒng)是在原始未標(biāo)記圖像的基礎(chǔ)上使用簡單的高斯噪聲設(shè)計(jì)的。本文的關(guān)鍵提議是用更加簡化的擾動(dòng)程序替代在監(jiān)督學(xué)習(xí)中迭代的增強(qiáng)方法,因?yàn)閮烧叩哪繕?biāo)幾乎相同。

除了這個(gè)核心理念之外,UDA論文還提出了一個(gè)額外的聰明的訓(xùn)練策略:如果你有許多未標(biāo)注的樣本和少量標(biāo)注的樣本,你可能需要一個(gè)大型模型來捕獲未標(biāo)注樣本中的信息,但這可能會導(dǎo)致過擬合。

為了避免這種情況,他們使用一種稱為“訓(xùn)練信號退火”的方法,在訓(xùn)練中的每個(gè)點(diǎn),他們從損失計(jì)算中刪除模型特別有信心的任何樣本,比如真實(shí)類別的預(yù)測高于某個(gè)閾值等。

隨著培訓(xùn)的進(jìn)行,網(wǎng)絡(luò)逐漸被允許看到更多的訓(xùn)練信號。在這種框架中,模型不能輕易過度擬合,因?yàn)橐坏┧_始在受監(jiān)督的例子上得到正確的答案,他們就會退出損失計(jì)算。

在實(shí)證結(jié)果方面,作者發(fā)現(xiàn),在UDA中,他們能夠通過極少數(shù)標(biāo)記的例子來改進(jìn)許多半監(jiān)督基準(zhǔn)。有一次,他們使用BERT模型作為基線,在其半監(jiān)督訓(xùn)練之前以無人監(jiān)督的方式進(jìn)行微調(diào),并表明他們的增強(qiáng)方法甚至可以在無人監(jiān)督的預(yù)訓(xùn)練值之上增加價(jià)值。

例如,在IMDb文本分類數(shù)據(jù)集中,僅有20個(gè)標(biāo)注樣本,UDA優(yōu)于在25000個(gè)標(biāo)注樣本上訓(xùn)練的最先進(jìn)模型。

在標(biāo)準(zhǔn)的半監(jiān)督學(xué)習(xí)基準(zhǔn)測試中,CIFAR-10具有4,000個(gè)樣本,SVHN具有1,000個(gè)樣本,UDA優(yōu)于所有先前的方法,并且降低了超過30%的最先進(jìn)方法的錯(cuò)誤率:從7.66%降至5.27%,以及從3.53%降至2.46%。

UDA也適用于具有大量標(biāo)記數(shù)據(jù)的數(shù)據(jù)集。例如,在ImageNet上,使用130萬額外的未標(biāo)記數(shù)據(jù),與AutoAugment相比,UDA將前1/前5精度從78.28/94.36%提高到79.04/94.45%。

半監(jiān)督學(xué)習(xí)激動(dòng)人心的未來

半監(jiān)督學(xué)習(xí)的另一個(gè)基礎(chǔ)轉(zhuǎn)變,是大家認(rèn)識到它可能在機(jī)器學(xué)習(xí)隱私中扮演非常重要的角色,例如Private Aggregation of Teacher Ensemble(PATE)。PATE框架通過仔細(xì)協(xié)調(diào)幾種不同機(jī)器學(xué)習(xí)模型的行為來實(shí)現(xiàn)隱私學(xué)習(xí)。

用于提取知識的隱私敏感方法正在成為聯(lián)合學(xué)習(xí)(Federated Learning)的關(guān)鍵推動(dòng)者之一,聯(lián)合學(xué)習(xí)提供了有效的分布式學(xué)習(xí)的方式,其不依賴于具有訪問用戶數(shù)據(jù)的模型,具有強(qiáng)大的數(shù)學(xué)隱私保證。

在實(shí)際環(huán)境中重新審視半監(jiān)督學(xué)習(xí)的價(jià)值有點(diǎn)激動(dòng)人心,這些進(jìn)步將會導(dǎo)致機(jī)器學(xué)習(xí)工具架構(gòu)有極大可能性發(fā)生根本轉(zhuǎn)變。

-

谷歌

+關(guān)注

關(guān)注

27文章

6195瀏覽量

106016 -

機(jī)器學(xué)習(xí)

+關(guān)注

關(guān)注

66文章

8438瀏覽量

133087 -

自動(dòng)編碼

+關(guān)注

關(guān)注

0文章

4瀏覽量

5844

原文標(biāo)題:谷歌首席科學(xué)家:半監(jiān)督學(xué)習(xí)的悄然革命

文章出處:【微信號:AI_era,微信公眾號:新智元】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

時(shí)空引導(dǎo)下的時(shí)間序列自監(jiān)督學(xué)習(xí)框架

揭秘未來辦公新趨勢:樓宇自控系統(tǒng)的智能進(jìn)化

【《大語言模型應(yīng)用指南》閱讀體驗(yàn)】+ 基礎(chǔ)知識學(xué)習(xí)

【《大語言模型應(yīng)用指南》閱讀體驗(yàn)】+ 基礎(chǔ)篇

神經(jīng)網(wǎng)絡(luò)如何用無監(jiān)督算法訓(xùn)練

深度學(xué)習(xí)中的無監(jiān)督學(xué)習(xí)方法綜述

谷歌Tensor G5芯片代工轉(zhuǎn)向臺積電,強(qiáng)化AI智能手機(jī)競爭力

基于FPGA的類腦計(jì)算平臺 —PYNQ 集群的無監(jiān)督圖像識別類腦計(jì)算系統(tǒng)

谷歌地圖正在對隱私進(jìn)行重大更改

谷歌提出大規(guī)模ICL方法

谷歌模型框架是什么軟件?谷歌模型框架怎么用?

機(jī)器學(xué)習(xí)基礎(chǔ)知識全攻略

DALI照明在物聯(lián)網(wǎng)時(shí)代的進(jìn)化

谷歌:半監(jiān)督學(xué)習(xí)其實(shí)正在悄然的進(jìn)化

谷歌:半監(jiān)督學(xué)習(xí)其實(shí)正在悄然的進(jìn)化

評論